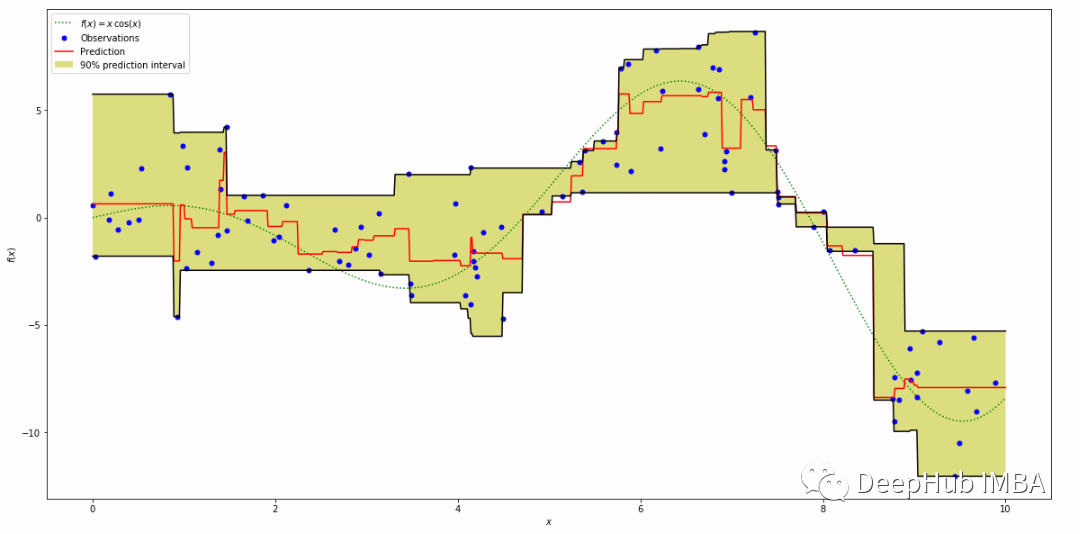

在使用机器学习构建预测模型时,我们不只是想知道“预测值(点预测)”,而是想知道“预测值落在某个范围内的可能性有多大(区间预测)”。例如当需要进行需求预测时,如果只储备最可能的需求预测量,那么缺货的概率非常的大。但是如果库存处于预测的第95个百分位数(需求有95%的可能性小于或等于该值),那么缺货数量会减少到大约20分之1。

获得这些百分位数值的机器学习方法有:

scikit-learn:GradientBoostingRegressor(loss='quantile, alpha=alpha)LightGBM: LGBMRegressor(objective='quantile', alpha=alpha)XGBoost: XGBoostRegressor(objective='reg:quantileerror', quantile_alpha=alpha) (version 2.0~)

这种”预测值落在某个范围内的可能性有多大(区间预测)”的方法都被称作分位数回归,上面的这些机器学习的方法是用了一种叫做Quantile Loss的损失。

Quantile loss是用于评估分位数回归模型性能的一种损失函数。在分位数回归中,我们不仅关注预测的中心趋势(如均值),还关注在分布的不同分位数处的预测准确性。Quantile loss允许我们根据所关注的分位数来量化预测的不确定性。

https://avoid.overfit.cn/post/e64a72a342af4aeda08b249ebca2c214

标签:loss,quantile,预测,回归,Quantile,神经网络,位数,alpha From: https://www.cnblogs.com/deephub/p/17937246