前言 CVPR 2023有哪些亮点?Collaborative Diffusion提供了一种简单有效的方法来实现不同扩散模型之间的合作。

本文转载自我爱计算机视觉

作者 | Huang Ziqi

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

近一两年,扩散模型(diffusion models)展现了强大的生成能力。不同种类的扩散模型各显神通 —— text-to-image模型可以根据文字生成图片,mask-to-image模型可以从分割图生成图片,除此之外还有更多种类的扩散模型,例如生成视频、3D、motion等等。

倘若有一种方法让这些pre-trained的扩散模型合作起来,发挥各自的专长,那么我们就可以得到一个多功能的生成框架。比如当text-to-image模型与mask-to-image模型合作时,我们就可以同时接受text和mask输入,生成与text和mask一致的图片了。

论文: https://arxiv.org/abs/2304.10530

代码: https://github.com/ziqihuangg/Collaborative-Diffusion

网页: https://ziqihuangg.github.io/projects/collaborative-diffusion.html

视频: https://www.youtube.com/watch?v=inLK4c8sNhc

我们先看看不同扩散模型合作生成图片的效果~

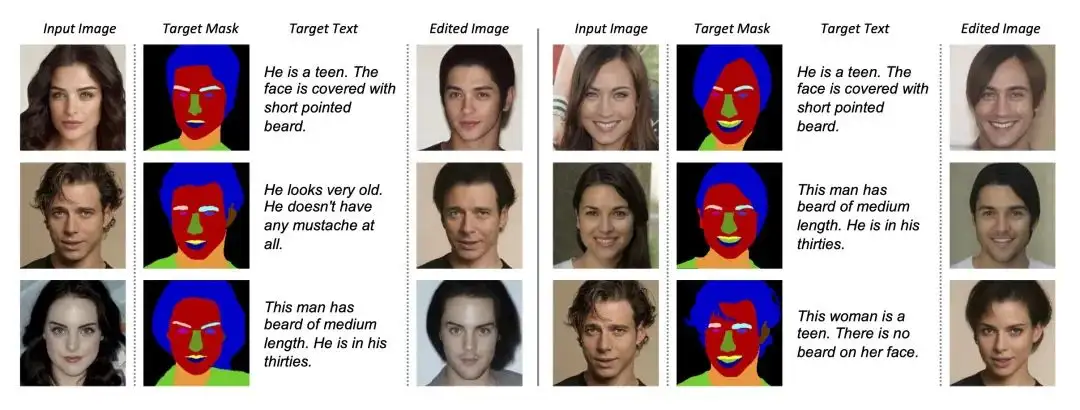

当text-to-image和mask-to-image通过Collaborative Diffusion合作时,生成的图片可以达到和输入的text以及mask高度一致。

给定不同的多模态输入组合,Collaborative Diffusion可以生成高质量的图片,而且图片与多模态控制条件高度一致。即便多模态输入是相对少见的组合,例如留长头发的男生,和留寸头的女生,Collaborative Diffusion依旧可以胜任。

那不同的扩散模型究竟怎样实现合作呢?

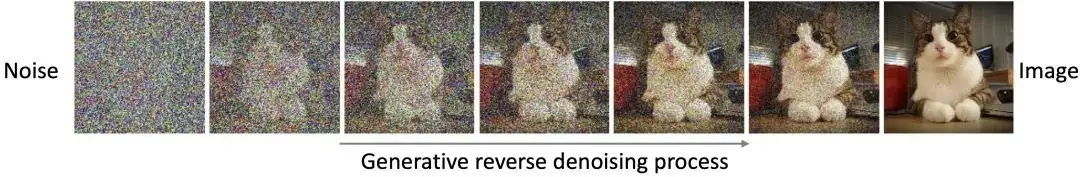

首先,我们知道,扩散模型在生成图片的过程中,会从高斯噪声开始,逐步去噪,最终得到自然图像。

图片来源:CVPR 2022 Tutorial: Denoising Diffusion-based Generative Modeling: Foundations and Applications

图片来源:CVPR 2022 Tutorial: Denoising Diffusion-based Generative Modeling: Foundations and Applications

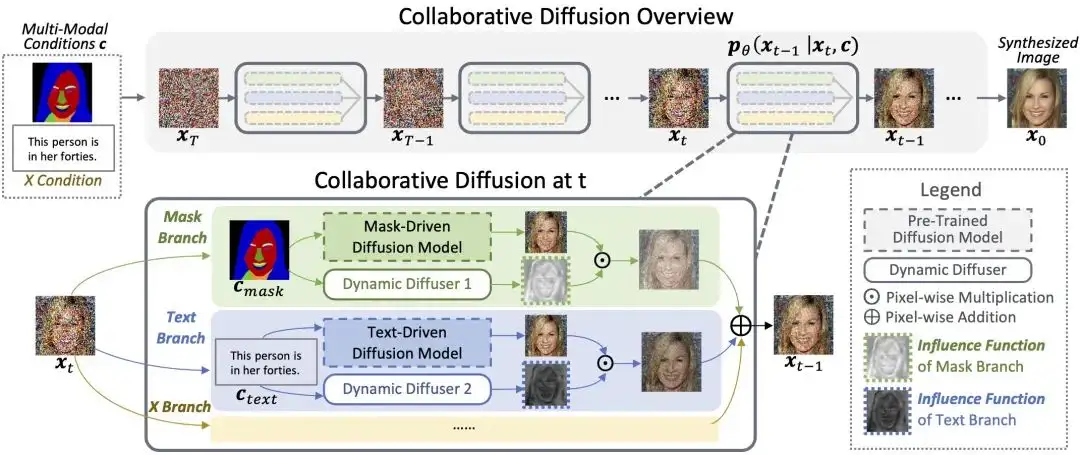

基于扩散模型迭代去噪的性质,我们的Collaborative Diffusion在去噪的每一步都会动态地预测不同的扩散模型如何有效合作,各取所长。Collaborative Diffusion的基本框架如下图所示。

我们在每一步去噪时,用Dynamic Diffusers动态地预测每个扩散模型对整体预测结果带来的影响(也就是Influence Functions)。Influence Functions会选择性地增强或者减少某个扩散模型的贡献,从而让各位合作者(也就是扩散模型)发挥专长,实现合作共赢。

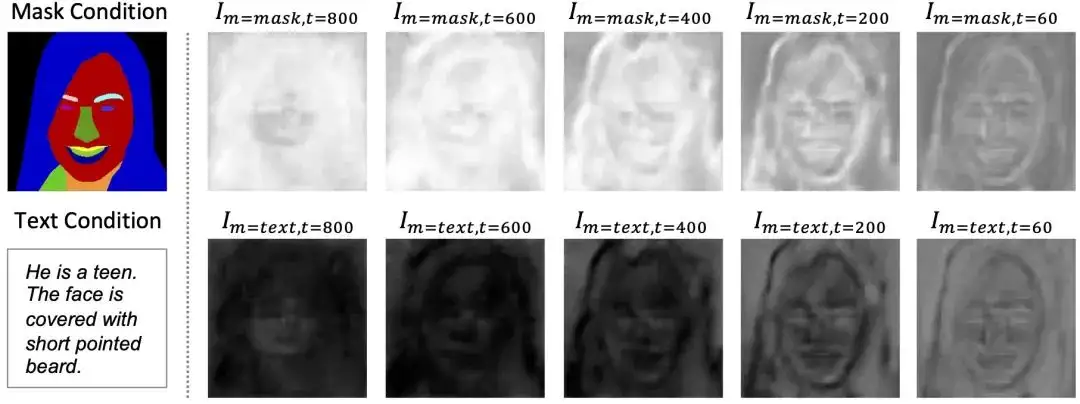

值得注意的是,预测得到的Influence Functions在时间和空间上都是适应性变化的。下图展示了mask-to-image和text-to-image模型合作时,在不同时间和空间位置的Influence Functions强度。

从上图中我们可以观察到,在时间上,决定mask-to-image模型影响的Influence Functions在去噪初期很强(第一行左边),到后期逐渐变弱(第一行右边),这是因为扩散模型在去噪初期会首先形成图片内容的布局,到后期才会逐渐生成纹路和细节;而在多模态控制人脸生成时,图片的布局信息主要是由mask提供的,因此mask分支的Influence Functions会随着时间由强变弱。与之相对应的text-to-image模型的Influence Functions(第二行)会随着时间由弱到强,因为text提供的多数信息是与细节纹路相关的,例如胡子的浓密程度,头发颜色,以及与年龄相关的皮肤皱纹,而扩散模型的去噪过程也是在后期才会逐步确定图片的纹理以及细节。

与此同时,在空间上,mask-to-image模型的Influence在面部区域分界处更强,例如面部轮廓和头发的外边缘,因为这些地方对整体面部布局是至关重要的。text-to-image模型的Influence则在面中,尤其是脸颊和胡子所在的区域较强,因为这些区域的纹理需要text提供的年龄,胡子等信息来填充。

Collaborative Diffusion的通用性

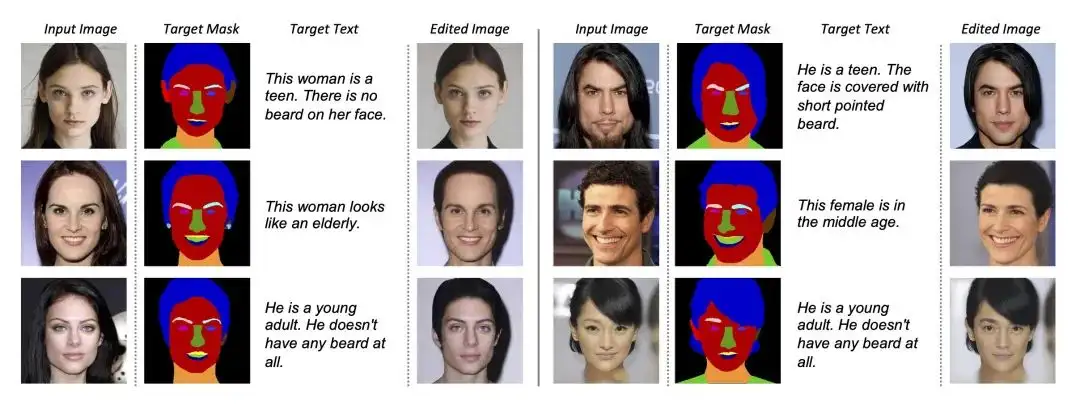

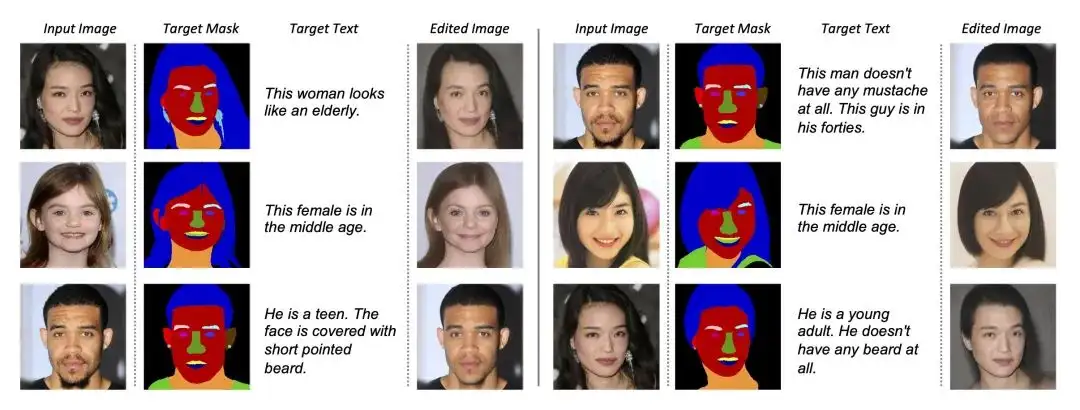

Collaborative Diffusion是一个通用的框架,它不仅适用于图片生成,还可以让text-based editing和mask-based editing方法合作起来。我们利用在生成任务上训练的Dynamic Diffusers来预测Influence Functions,并将其直接用到editing中。话不多说我们看图~

完整的实验细节和实验结果,以及更多图片结果,请参考论文(https://arxiv.org/abs/2304.10530)。

总结

- 我们提出了Collaborative Diffusion,一种简单有效的方法来实现不同扩散模型之间的合作。

- 我们充分利用扩散模型的迭代去噪的性质,设计了Dynamic Diffuser来预测在时间和空间上均有适应性的Influence Functions来控制不同的扩散模型如何合作。

- 我们实现了高质量的多模态控制的人脸生成和编辑。

- Collaborative Diffusion是一个通用的框架,不仅适用于图片生成,还适用于图片编辑,以及未来更多的基于扩散模型的其他任务。

代码已开源,各位大佬走过路过不要忘记star~

https://github.com/ziqihuangg/Collaborative-Diffusion

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

CVPR'23|泛化到任意分割类别?FreeSeg:统一、通用的开放词汇图像分割新框架

全新YOLO模型YOLOCS来啦 | 面面俱到地改进YOLOv5的Backbone/Neck/Head

通用AI大型模型Segment Anything在医学图像分割领域的最新成果!

可复现、自动化、低成本、高评估水平,首个自动化评估大模型的大模型PandaLM来了

实例:手写 CUDA 算子,让 Pytorch 提速 20 倍

BEV专栏(一)从BEVFormer深入探究BEV流程(上篇)

可见光遥感图像目标检测(三)文字场景检测之Arbitrary

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

标签:Diffusion,Collaborative,text,模型,mask,CVPR,扩散 From: https://www.cnblogs.com/wxkang/p/17422026.html