前言 Stability AI又来卷了AI视觉圈了!Stable Animation震撼发布,动画效果令人惊叹。

本文转载自新智元

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

Stability AI又放大招!

现在,Stable Diffusion也能生成视频了。AI届,实在是太卷了。

昨天,Stability AI发布了一款专为艺术家和开发人员设计的工具——Stable Animation SDK。用户可以通过多种方式创建令人惊叹的动画效果。

此前,Runway的Gen-2就相当炸裂,宣传词非常霸气——「say it,see it」。现在,Stability AI也有比肩Gen-2的视频生成工具了!Stable Diffusion能做视频了

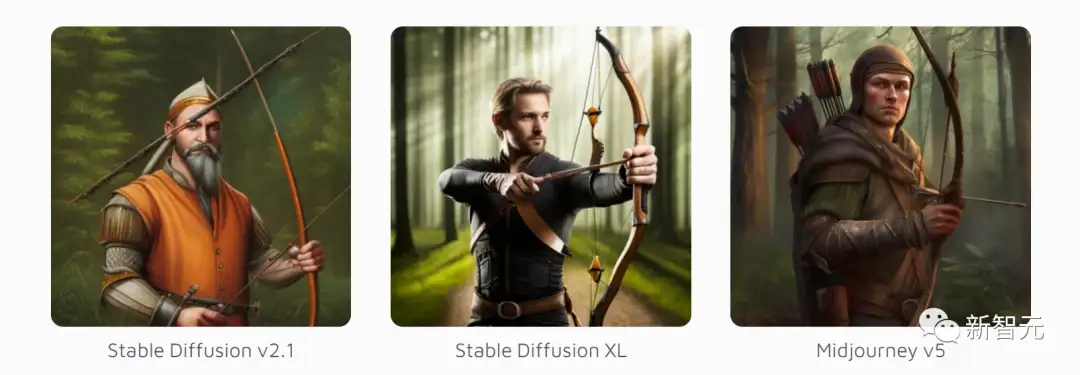

借助Stability AI的动画端点,美术师可以使用所有Stable Difusion模型来生成动画,包括Stable Diffusion 2.0和Stable Diffusion XL。

不过,有别于之前发布的开源模型,Stable Animation目前仅能通过SDK和付费API使用。现在,用这三种方式,都可以创建动画了——

- 经典的prompt

就像使用Stable Diffusion、Midjourney或DALL-E 2一样,用文本生成动画。输入prompt,调整各种参数,就能生成动画。

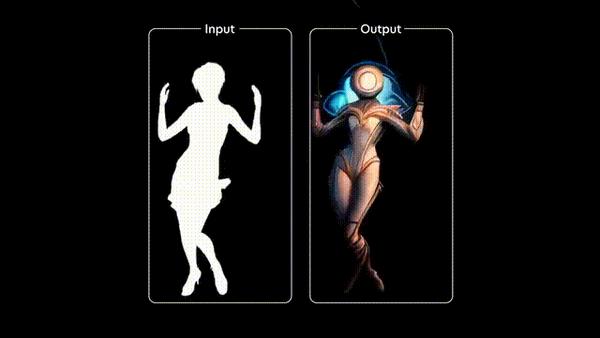

- prompt+图像

提供一个初始图像,作为动画的基础。之后,结合prompt和这个初始图像,就能生成最终输出的动画。

- prompt+视频

提供一个初始视频,作为动画的基础。同样,通过各种参数的调整,外加prompt的引导,最终得到输出的动画。

1块钱,就能生成100帧动画

该软件似乎仍处于测试阶段。Stability AI并没有通过他们的浏览器平台(如DreamStudio或ClipDrop)提供,而是仅提供软件开发套件(SDK)和付费API。

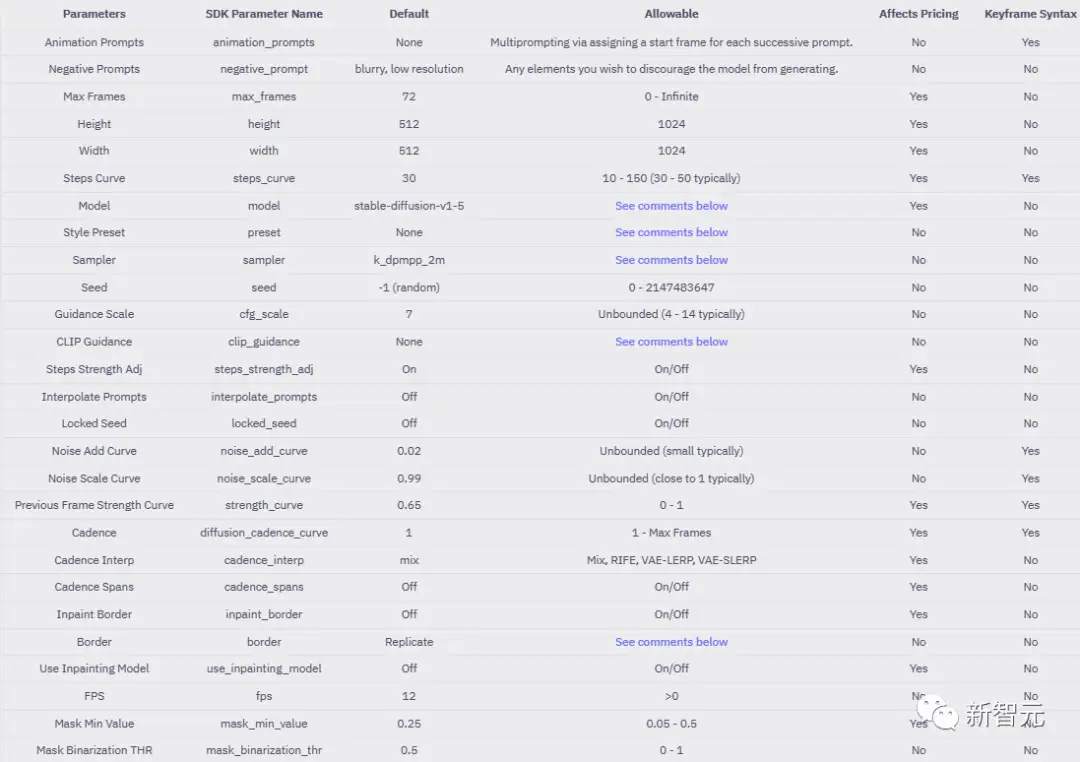

当然,这并不妨碍第三方通过服务提供这种动画模型。不过,目前想试用这个功能的话,门槛还比较高,因为SDK和API要通过Python脚本来调用。与Stability AI的图像模型类似,Stable Animation也可以设置许多参数,例如step、sampler、scale或seed。此外,还提供了诸如outpainting或prompt interpolation等功能。

不同的参数也会影响价格。所以创建一个视频要花费多少钱,并不确定。Stability给出的报价范围是,在不同设置下,每100帧的价格从3美分到18美分不等。Stability AI以输出动画的积分值作为收费的依据,用户生成的动画会被换算成一个积分,每1000个积分消耗1美元。小编算了一下,根据官方公布的积分计算方法,一块钱人民币大概能生成一段100帧的1024*1024分辨率的动画。但是其他的参数也会影响价格,官方给了一个表来说明支持调整的参数,以及是否会影响到生成动画的价格。

与Stable Diffuision XL兼容

Stable Animation可以与每个版本的Stable Diffusion结合使用。

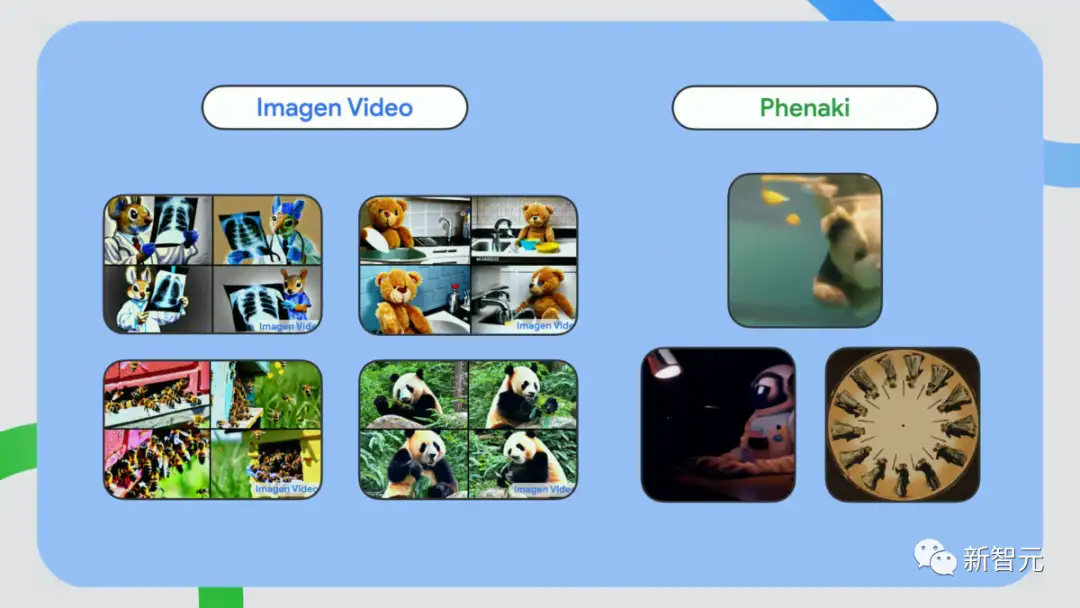

它的默认版本是1.5,但我们也可以选择使用新版的Stable Diffusion XL。里面有很多样板,包括动漫、漫画书、低多边形、像素艺术。原始分辨率是512 x 512像素,可以增加到1,024 x 1,024像素。此外,可以使用升频器。Stable Animation的默认值是72 帧(12帧每秒),但根据说明,它可以增加到无穷大。此前,Stability AI就已经有了基于Stable Diffusion的动画工具,比如,我们可以通过prompt interpolation(不断改变prompt的某些属性)生成一小段动图。这次的升级的不同之处在于,table Animation生成视频的能力更全面、更成熟。虽然现在,AI还没进化到让我们按个按钮就能生成电影,但Stable Animation、Runway ML、Phenaki、Imagen Video等模型的超强进化,已经预示了视觉生成AI的视频生成功能,会越来越惊艳。

网友实测

Stable Animation一发布,网友们就按捺不住自己渴望尝试的小手。

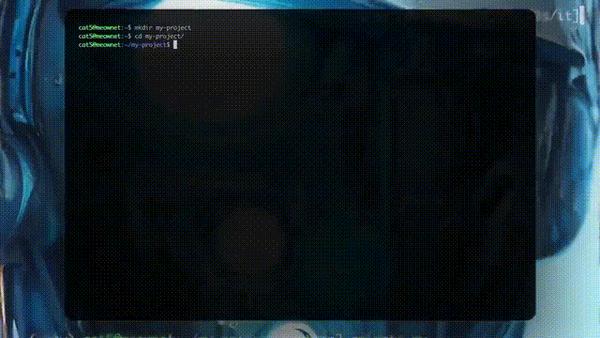

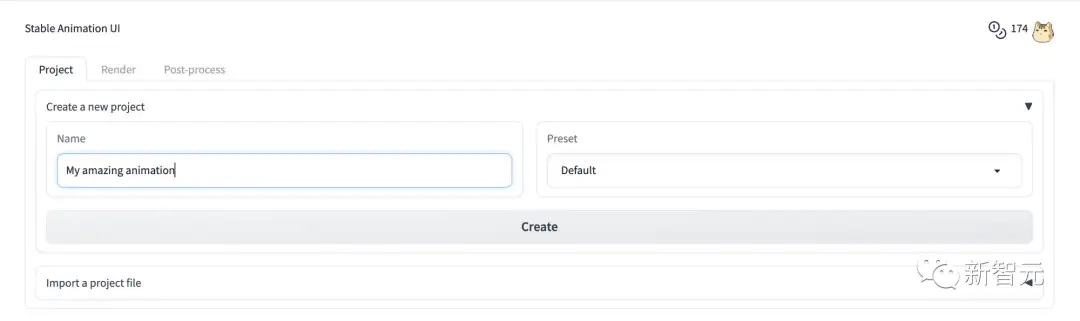

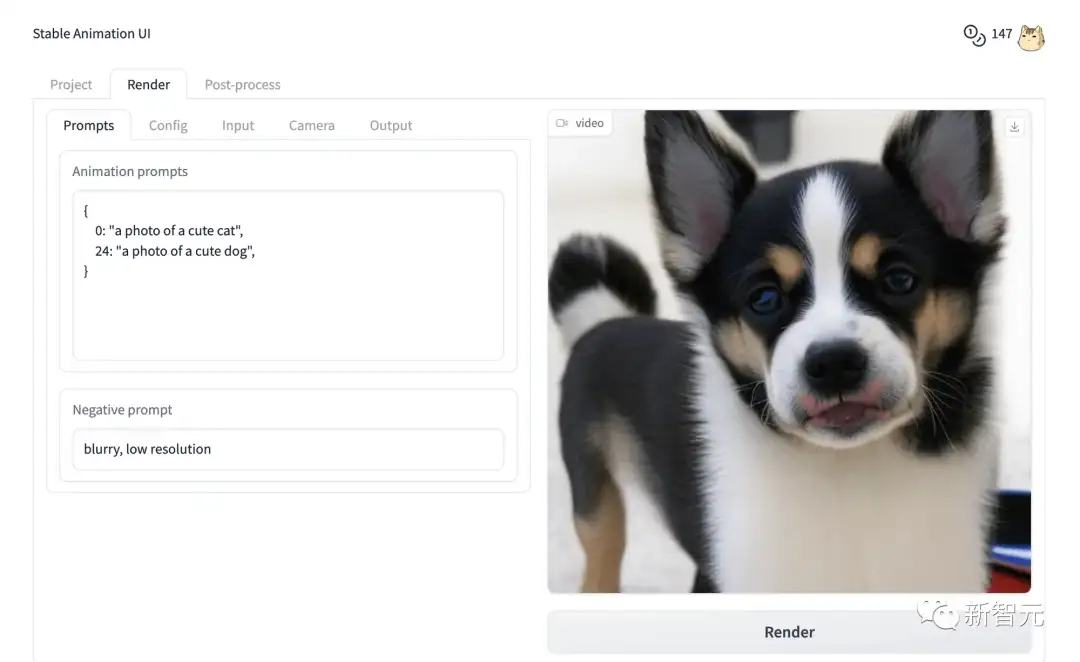

比如,npaka就分享了自己的使用体验。首先,将DreamStudio的API密钥设置为本机的环境变量。然后,准备Python虚拟环境,并安装stability_sdk并启动Animation GUI。

$ pip install 'stability_sdk[anim_ui]'

$ python -m stability_sdk animate --gui

Running on local URL: http://127.0.0.1:7860用浏览器打开显示的网址后,就可以在「Project」选项卡中创建项目了。

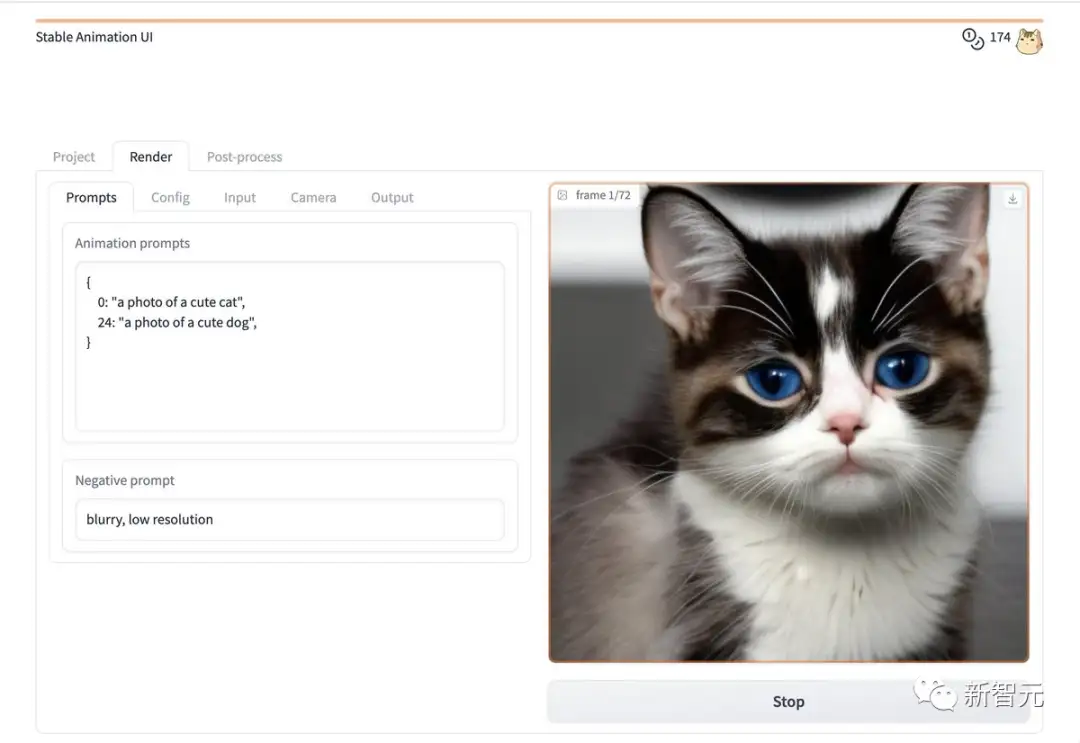

在「Render」选项卡中设置文本提示,然后按「Render」按钮。

最后,动画就做好啦。

此外,还有一些网友也分享了自己的作品。

AI离生成电影还有多远

AI生成视频的功能如此强大,已经有网友打算投资AI动画工作室了。

这位表示,脑洞已准备好,就等一个用户友好的动画工具了。

网友们的畅想并不遥远,最近,Wes Anderson的《指环王》的新预告片中,就用到了不少AI工具。

OpenAI前AI主管Andrej Karpathy猜测,这部预告片中至少用到了Midjourney/Stable Diffusion、ControlNet、 ElevenLabs、D-Id、ChatGPT、Adobe等工具。

看来,AI视觉工具再这么进化下去,取代好莱坞大导不会太远了。

参考资料:

https://stability.ai/blog/stable-animation-sdk

https://twitter.com/StabilityAI/status/1656691563995512834

https://the-decoder.com/stable-animation-stability-ai-makes-images-move/

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

CVPR'23|泛化到任意分割类别?FreeSeg:统一、通用的开放词汇图像分割新框架

全新YOLO模型YOLOCS来啦 | 面面俱到地改进YOLOv5的Backbone/Neck/Head

通用AI大型模型Segment Anything在医学图像分割领域的最新成果!

可复现、自动化、低成本、高评估水平,首个自动化评估大模型的大模型PandaLM来了

实例:手写 CUDA 算子,让 Pytorch 提速 20 倍

BEV专栏(一)从BEVFormer深入探究BEV流程(上篇)

可见光遥感图像目标检测(三)文字场景检测之Arbitrary

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

标签:Diffusion,动画,出大招,AI,Stability,Animation,Stable From: https://www.cnblogs.com/wxkang/p/17416111.html