前言 最近OCC的综述很多,这两天arxiv上又挂出来一篇,从信息融合的角度全面回顾了占用网络的相关工作,值得一看!

本文转载自自动驾驶之心

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

招聘高光谱图像、语义分割、diffusion等方向论文指导老师

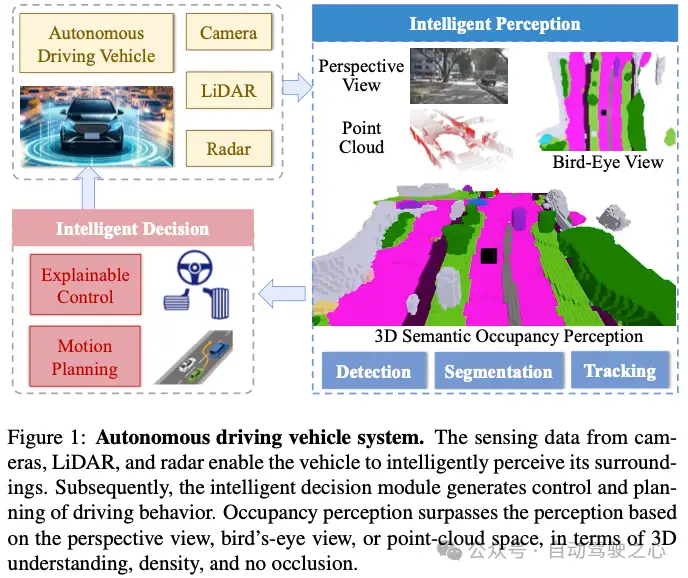

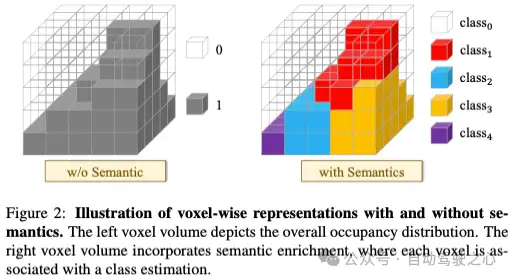

3D占用感知技术旨在观察和理解自动驾驶汽车的密集3D环境。由于其全面的感知能力,该技术正在成为自动驾驶感知系统的一种趋势,并引起了工业界和学术界的极大关注。与传统的BEV感知类似,3D占用感知具有多源输入的性质,具有信息融合的必要性。然而,不同之处在于,它捕捉了2D BEV忽略的垂直结构。在这项调查中,我们回顾了关于3D占用感知的最新工作,并对各种输入模态的方法进行了深入分析。具体来说,我们总结了一般的网络管道,重点介绍了信息融合技术,并讨论了有效的网络训练。我们在最流行的数据集上评估和分析了最先进的占用感知性能。此外,还讨论了挑战和未来的研究方向。

开源仓库:https://github.com/HuaiyuanXu/3D-Occupancy-Perception

总结来说,本文的主要贡献如下:

- 我们系统地回顾了自动驾驶领域3D占用感知的最新研究,涵盖了整体研究背景、对其重要性的全面分析以及对相关技术的深入讨论。

- 我们提供了3D占用感知的分类,并详细阐述了核心方法论问题,包括网络pipeline、多源信息融合和有效的网络训练。

- 我们提供了3D占用感知的评估,并提供了详细的性能比较。此外,还讨论了目前的局限性和未来的研究方向。

背景

Occ历史回顾

占用感知源于占用网格映射(OGM),这是移动机器人导航中的一个经典主题,旨在从有噪声和不确定的测量中生成网格图。该地图中的每个网格都被分配了一个值,该值对网格空间被障碍物占据的概率进行评分。语义占用感知源于SUNCG,它从单个图像中预测室内场景中所有体素的占用状态和语义。然而,与室内场景相比,研究室外场景中的占用感知对于自动驾驶来说是必不可少的。MonoScene是仅使用单眼相机进行户外场景占用感知的开创性工作。特斯拉在2022年CVPR自动驾驶研讨会上宣布了其全新的纯视觉的占用网络,与MonoScene并驾齐驱。这个新网络根据环绕视图RGB图像全面了解车辆周围的3D环境。随后,占用感知引起了广泛关注,推动了近年来自动驾驶占用感知研究的激增。

早期的户外占用感知方法主要使用激光雷达输入来推断3D占用。然而,最近的方法已经转向更具挑战性的以视觉为中心的3D占用预测。目前,占用感知研究的一个主要趋势是以视觉为中心的解决方案,辅以以激光雷达为中心的方法和多模式方法。占用感知可以作为端到端自动驾驶框架内3D物理世界的统一表示,随后是跨各种驾驶任务(如检测、跟踪和规划)的下游应用。占用感知网络的训练在很大程度上依赖于密集的3D占用标签,导致了多样化街景占用数据集的开发。最近,利用大型模型强大的性能,将大型模型与占用感知相结合,有望缓解繁琐的3D占用标签需求。

与OCC的相关任务主要包含:

- BEV感知

- 3D语义场景补全

- 视觉3D重建

方法论

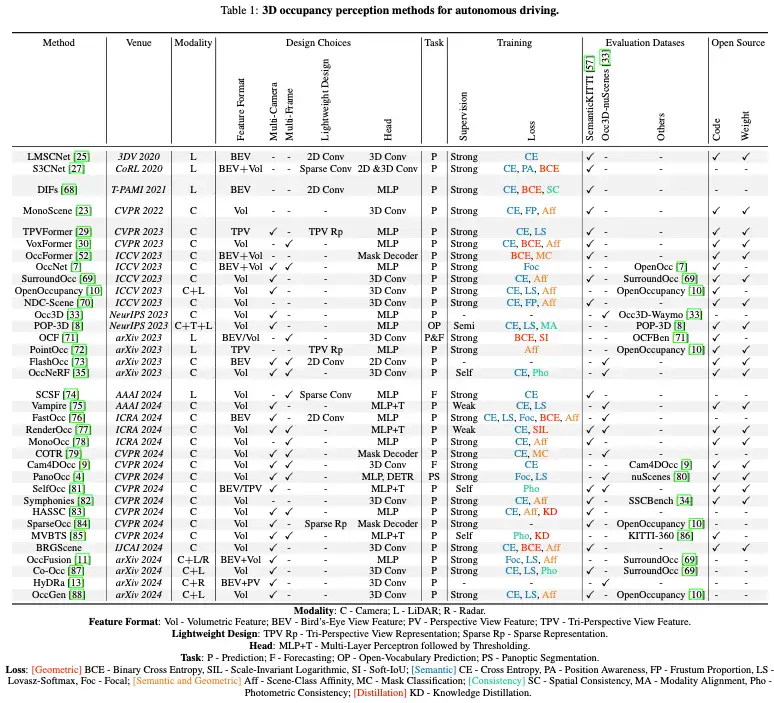

表1详细介绍了自动驾驶占用感知的最新方法及其特点。该表详细说明了每种方法的发布地点、输入方式、网络设计、目标任务、网络培训和评估以及开源状态。下面,我们根据输入数据的模态将占用感知方法分为三种类型。它们分别是以激光雷达为中心的占用感知、以视觉为中心的占据感知和多模态占用感知。随后,讨论了占用网络的训练及其损失函数。最后,介绍了利用占用感知的各种下游应用程序。

LiDAR-Centric Occupancy Perception

General Pipeline

以激光雷达为中心的语义分割仅预测稀疏点的语义类别。相比之下,以激光雷达为中心的占用感知提供了对环境的密集3D理解,这对自动驾驶系统至关重要。对于激光雷达传感,所获取的点云具有固有的稀疏特性,并受到遮挡。这就要求以激光雷达为中心的占用感知不仅解决了场景从稀疏到密集的占用推理,而且实现了对物体的部分到完全估计。

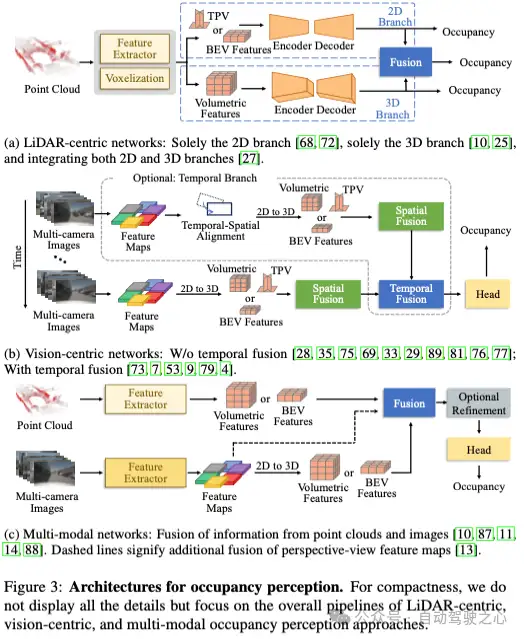

图3a说明了以激光雷达为中心的占用感知的一般流程。输入点云首先进行特征提取和体素化,然后通过编码器-解码器模块进行表示增强。最终,推断出场景的完整和密集占用。

以激光雷达为中心的OCC信息融合

一些作品直接利用单个2D分支来推理3D占用,例如DIF和PointOcc。在这些方法中,只需要2D特征图而不是3D特征体积,从而减少了计算需求。然而,一个显著的缺点是高度信息的部分丢失。相反,3D分支不压缩任何维度的数据,从而保护完整的3D场景。为了提高三维分支中的内存效率,LMSCNet将高度维度转换为特征通道维度。与3D分支中的3D卷积相比,这种自适应便于使用更高效的2D卷积。此外,集成来自2D和3D分支的信息可以显著地细化占用预测。

S3CNet提出了一种独特的后期融合策略,用于整合来自2D和3D分支的信息。该融合策略涉及动态体素融合技术,该技术利用2D分支的结果来增强来自3D分支的输出的密度。消融研究报告称,这种直接的信息融合策略可以在3D占用感知方面提高5-12%的性能。

以视觉为中心的OCC预测

General Pipeline

受特斯拉的启发,以视觉为中心的占用感知在工业界和学术界都引起了极大的关注。与以激光雷达为中心的方法相比,仅依赖于相机传感器的以视觉为中心的占用感知代表了当前的趋势。主要有三个原因:(i)相机在车辆上大规模部署具有成本效益。(ii)RGB图像捕捉丰富的环境纹理,有助于理解场景和物体,如交通标志和车道线。(iii)深度学习技术的迅速发展使从2D视觉实现3D占用感知成为可能。以视觉为中心的占用感知可以分为单目解决方案和环视解决方案。多摄像头感知覆盖了更广阔的视野,遵循如图3b所示的一般流程。它首先从多摄像头图像中提取前视图特征图,然后进行二维到三维转换、空间信息融合和可选的时间信息融合,最后使用占用头推断环境三维占用情况。

2D-to-3D Transformation

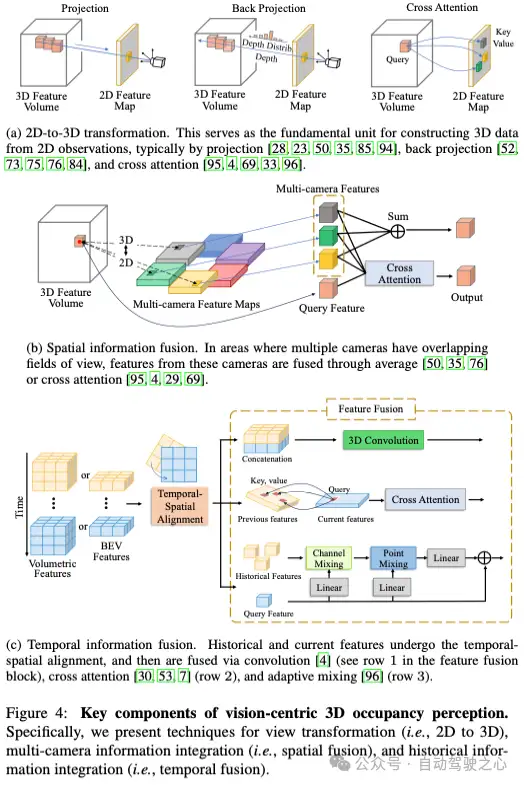

该转换旨在将前视图特征转换为BEV特征、TPV特征或体积特征,以获取前视图缺失的深度维度。值得注意的是,尽管BEV特征位于俯视2D平面上,但它们可以将高度信息编码到特征的通道维度中,从而表示3D场景。三视角视图将3D空间投影到三个正交的2D平面中,使得3D空间中的每个特征可以表示为三个TPV特征的组合。这种转换可以分为三种类型,分别以使用投影、反向投影和交叉注意力技术为特征。以体积特征的构建为例,该过程如图4a所示。

- Projection

- Back projection

- Cross Attention

以视觉为中心的OCC信息融合

在环视设置中,每个相机的前视图特征图描述场景的一部分。为了全面了解场景,有必要在空间上融合来自多个特征图的信息。此外,场景中的对象可能被遮挡或处于运动中。临时融合多帧的特征图可以帮助推断遮挡区域并识别物体的运动状态。

(1)空间信息融合:来自多个相机的观测结果的融合可以创建具有扩展视野的3D特征体积,用于场景感知。在多相机视图的重叠区域内,特征体积中的3D体素在投影后会碰到几个2D前视图特征图。有两种方法可以融合命中的2D特征:平均注意力和交叉注意力,如图4b所示。平均运算计算多个特征的平均值,这简化了融合过程并降低了计算成本。然而,它假设不同2D视角对感知3D场景的贡献是相等的。这种情况可能并不总是如此,尤其是当某些视图被遮挡或模糊时。

(2)时间信息融合:基于视觉的BEV感知系统的最新进展表明,整合时间信息可以显著提高感知性能。同样,在基于视觉的占用感知中,可以通过结合历史特征和当前感知输入的相关信息来提高准确性和可靠性。时间信息融合过程由两个部分组成:时间-空间对齐和特征融合,如图4c所示。

多模态OCC

General Pipeline

相机拍摄的RGB图像提供了丰富而密集的语义信息,但对天气条件变化敏感,缺乏精确的几何细节。相比之下,激光雷达或雷达的点云对天气变化具有鲁棒性,并擅长通过准确的深度测量捕捉场景几何结构。然而,它们只产生稀疏的特征。多模态占用感知可以结合多种模态的优势,减轻单模态感知的局限性。图3c展示了多模式占用感知的一般流程。大多数多模态方法将2D图像特征映射到3D空间,然后将它们与点云特征融合。此外,在融合过程中结合2D透视图特征可以进一步细化表示。融合表示由可选的细化模块和占用头(例如3D卷积或MLP)处理,以生成最终的3D占用预测。可选的细化模块可以是交叉注意力、自注意力和扩散去噪的组合。

多模态OCC的信息融合

有三种主要的多模态信息融合技术来集成不同的模态分支:串联、求和和和交叉注意。

(1)串联:受BEVFusion的启发,OccFusion通过沿着特征通道连接来自不同模态的3D特征体积,并随后应用卷积层。类似地,RT3DSO将3D点的强度值及其相应的2D图像特征(通过投影)连接起来,然后将组合数据馈送到卷积层。然而,3D空间中的一些体素可能仅包含来自点云分支或视觉分支的特征。为了缓解这个问题,CO-Occ引入了几何和语义感知融合(GSFusion)模块,该模块识别包含点云和视觉信息的体素。该模块利用K近邻(KNN)搜索来选择特定半径内体素空间中给定位置的K近邻。

(2)求和:CONet和OccGen采用自适应融合模块,动态集成来自相机和激光雷达分支的占用表示。它利用3D卷积来处理多个单模态表示,以确定其融合权重,随后应用这些权重来求和激光雷达分支表示和相机分支特征。

(3)交叉注意:HyDRa提出了在透视图(PV)和BEV表示空间中集成多模态信息。具体地,PV图像特征通过使用交叉注意力的BEV点云特征来改进。然后,将增强的PV图像特征转换为具有估计深度的BEV视觉表示。这些BEV视觉特征通过与BEV点云特征串联,然后是简单的挤压和激发层来进一步增强。最后,通过交叉关注将增强的PV图像特征和增强的BEV视觉特征融合,得到最终的占用表示。

模型训练

我们根据监督训练类型对文献中提到的网络训练技术进行分类。最普遍的类型是强监督学习,而其他人则采用弱监督、半监督或自监督的方式进行训练。本节详细介绍了这些网络训练技术及其相关的损失函数。表1中的“训练”列简要概述了各种占用感知方法的网络训练。

Training with Strong Supervision

占用感知的强监督学习涉及使用占用标签来训练占用网络。大多数占用感知方法都采用这种训练方式。相应的损失函数可分为:几何损失,优化几何精度;语义损失,增强语义预测;语义和几何损失相结合,这促进了更好的语义和几何准确性;一致性损失,鼓励整体一致性;以及提炼损失,将知识从教师模式转移到学生模式。接下来,我们将提供详细的描述。

在几何损失中,二进制交叉熵(BCE)损失是最常用的,用于区分空体素和占用体素。

交叉熵(CE)损失是优化占用语义的首选损失。它将类视为独立的实体。

此外,一些占用感知方法使用了其他语义损失,这些损失通常用于语义分割任务,如Lovasz-Softmax损失和Focal损失。此外,还有两种专门的语义损失:截头体比例损失,它从视觉截头体的角度提供线索来缓解遮挡歧义;位置感知损失,它利用局部语义比喻来鼓励更清晰的语义和几何梯度。

可以同时优化占用感知的语义和几何结构的损失包括场景类仿射损失和掩码分类损失。前者从几何和语义角度优化了准确性、回忆性和特异性的组合。后者通常与掩模解码器头相关联。掩码分类损失源于MaskFormer和Mask2Former,它结合了交叉熵分类损失和每个预测掩码段的二进制掩码损失。

consistency损失和蒸馏损失分别对应于空间一致性损失和Kullback–Leibler(KL)发散损失。空间一致性损失最小化了空间中给定点和某些支持点之间语义推理的Jenssen-Shannon分歧,从而增强了语义的空间一致性。KL散度,也称为相对熵,量化了一个概率分布如何偏离参考分布。HASC采用KL发散损失来鼓励学生模型从教师模型提供的在线软标签中学习更准确的占用率。

Training with Other Supervisions

(1)弱监督:表示未使用占用标签,监管来源于替代标签。例如,具有语义标签的点云可以指导占用预测。具体来说,Vampire和RenderOcc构建密度和语义体积,这有助于通过体积渲染推断场景的语义占用,以及计算深度和语义图。这些方法不使用占用标签。或者,他们将带有语义标签的激光雷达点云投影到相机平面上,以获取地面实况深度和语义,然后监督网络训练。由于强监督和弱监督学习都预测几何和语义占用,因此强监督学习中使用的损失,如交叉熵损失、Lovasz-Softmax损失和尺度不变对数损失,也适用于弱监督学习。

(2)半监督:它使用占用标签,但不覆盖整个场景,因此仅为占用网络培训提供半监督。POP-3D最初通过处理激光雷达点云来生成占用标签,其中,如果体素包含至少一个激光雷达点,则将其记录为占用,否则为空。考虑到激光雷达点云中固有的稀疏性和遮挡性,以这种方式产生的占用标签并不包括整个空间,这意味着只有场景的一部分具有其占用标签。POP-3D采用交叉熵损失和Lovasz-Softmax损失来监督网络训练。此外,为了建立文本和3D占用之间的跨模态对应关系,POP-3D提出将语言图像特征和3D语言特征之间的L2均方误差计算为模态对齐损失。

(3)自监督:它在没有任何标签的情况下训练占用感知网络。为此,体积渲染提供了一个自监督信号,通过最小化光度差异,从时间和空间角度鼓励不同视图之间的一致性。MVBTS计算渲染的RGB图像和目标RGB图像之间的光度差。然而,其他几种方法可以计算扭曲图像(来自源图像)和目标图像之间的差异,其中扭曲过程所需的深度是通过体积渲染获得的。OccNeRF认为,不比较渲染图像的原因是,室外场景的规模大,视图监督少,这会使体积渲染网络难以收敛。从数学上讲,照片集一致性损失结合了L1损失和可选的结构相似性(SSIM)损失来计算重建误差。

评测

性能

感知准确性

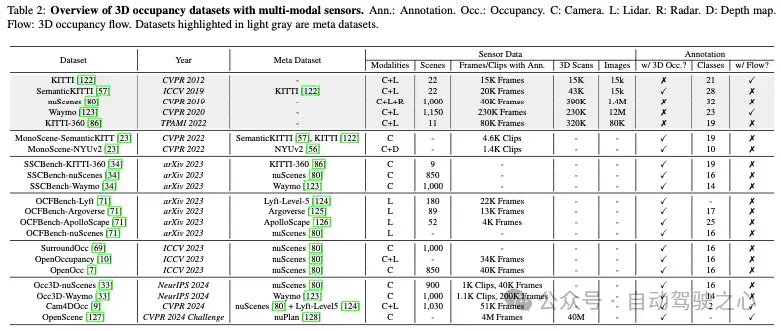

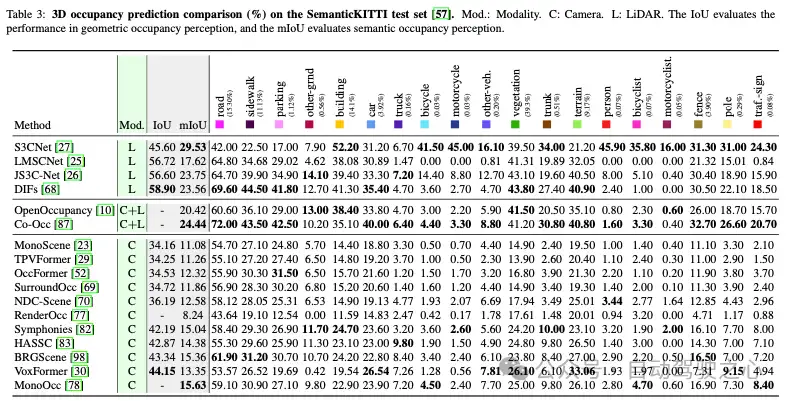

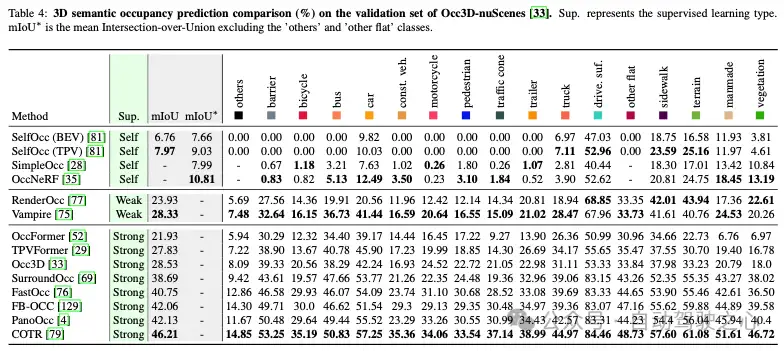

SemanticKITTI是第一个具有户外驾驶场景3D占用标签的数据集。Occ3D nuScenes是CVPR 2023 3D占用预测挑战中使用的数据集。这两个数据集是目前最受欢迎的。因此,我们总结了在这些数据集上训练和测试的各种3D占用方法的性能,如表3和表4所示。这些表分别根据输入模式和监督学习类型进一步组织占用方法。最佳表现以粗体突出显示。表3利用IoU和mIoU度量来评估3D几何形状和3D语义占用感知能力。表4采用mIoU和mIoU来评估语义占用感知。与mIoU不同,mIoU度量不包括“其他”和“其他平面”类,由自监督OccNeRF使用。为了公平起见,我们计算了其他自监督占用方法的mIoU*。值得注意的是,OccScore指标用于CVPR 2024自主大挑战赛,但目前尚未普及。因此,我们没有用这个指标来总结入住率表现。下面,我们将从三个方面对感知准确性进行比较:整体比较、模态比较和超视觉比较。

(1)总体比较。表3显示(i)占用网络的IoU分数小于50%,而mIoU分数低于30%。IoU分数(指示几何感知,即忽略语义)大大超过mIoU分数。这是因为预测某些语义类别的占用率很有挑战性,例如自行车、摩托车、人、骑自行车的人、骑摩托车的人、电线杆和交通标志。这些类中的每一个在数据集中的比例都很小(不到0.3%),它们的形状很小,很难观察和检测。因此,如果这些类别的IOU分数较低,它们会显著影响mIoU的整体值。因为mIOU计算不考虑类别频率,它将所有类别的总IoU分数除以类别的数量。(ii)较高的IoU并不保证较高的mIoU。一种可能的解释是,占用网络的语义感知能力(反映在mIoU中)和几何感知能力(体现在IoU中中)是不同的,并且不是正相关的。

从表4中可以明显看出,(i)占用网络的mIOU分数在50%以内,高于SemanticKITTI上的分数。例如,TPVFormer在SemanticKITTI上的mIOU为11.26%,但在Occ3D nuScenes上为27.83%。类似地,OccFormer和SurroundOcc具有相同的情况。我们认为这可能是由于Occ3D nuScenes中的占用标签更准确。SemanticKITTI基于激光雷达点云对每个体素进行注释,也就是说,基于对体素内所有标记点的多数投票,将标签分配给体素。相比之下,Occ3D nuScenes利用了复杂的标签生成过程,包括体素致密化、遮挡推理和图像引导的体素细化。此注释可以生成更精确、更密集的三维占用标签。(ii)COTR的mIoU最好(46.21%),并且在所有类别中的IoU得分最高。

(2)模态比较。输入数据模态显著影响3D占用感知准确性。“Mod.”表3中的列报告了各种占用方法的输入模式。可以看出,由于激光雷达传感提供了准确的深度信息,以激光雷达为中心的占用方法具有更精确的感知,IoU和mIoU得分更高。例如,S3CNet具有最高的mIoU(29.53%),DIFs实现了最高的IoU(58.90%)。我们观察到,这两种多模态方法并不优于S3CNet和DIF,这表明它们没有充分利用多模态融合的优势和输入数据的丰富性。在多模式占用感知方面有相当大的进一步改进潜力。此外,尽管近年来以视觉为中心的占用感知发展迅速,但从表3可以看出,最先进的以视觉为核心的占用方法在IoU和mIoU方面与以激光雷达为中心的方法仍有差距。我们认为有必要进一步改进以视觉为中心的方法的深度估计。

(3)监督比较。“主管”表4的列概述了用于训练占用网络的监督学习类型。具有强大监督的培训,直接使用3D占用标签,是最普遍的类型。表4显示,基于强监督学习的占用网络取得了令人印象深刻的性能。FastOcc、FB Occ、PanoOcc和COTR的mIoU得分显著高于弱监督或自监督方法(mIoU增加12.42%-38.24%)。这是因为数据集提供的占用标签经过了高精度的标注,并且可以对网络训练施加强大的约束。然而,注释这些密集的占用标签既费时又费力。有必要探索基于薄弱或自我监督的网络培训,以减少对占用标签的依赖。Vampire是基于弱监督学习的表现最好的方法,其mIoU得分为28.33%。这表明语义激光雷达点云可以监督三维占用网络的训练。然而,语义激光雷达点云的收集和注释是昂贵的。SelfOcc和OccNeRF是基于自我监督学习的两部具有代表性的占有作品。它们利用体积渲染和光度一致性来获取自监督信号,证明网络可以在没有任何标签的情况下学习3D占用感知。然而,它们的性能仍然有限,SelfOcc的mIoU为7.97%,OccNeRF的mIoU*为10.81%。

推理速度

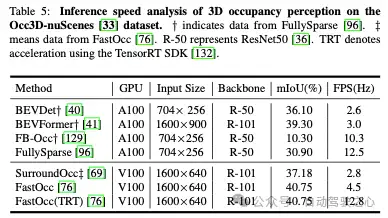

最近关于3D占用感知的研究不仅开始考虑感知的准确性,还开始考虑其推理速度。根据FastOcc和FullySparse提供的数据,我们梳理了3D占用方法的推理速度,并在Occ3D nuScenes数据集上报告了它们的运行平台、输入图像大小、骨干架构和占用精度,如表5所示。

一种实用的占用方法应该具有高精度(mIoU)和快速推理速度(FPS)。从表5中可以看出,FastOcc实现了高mIoU(40.75%),与BEVFomer的mIoU相当。值得注意的是,FastOcc在性能较低的GPU平台上的FPS值高于BEVFomer。此外,经过TensorRT的加速,FastOcc的推理速度达到12.8Hz。

挑战与机遇

基于OCC的自动驾驶应用

3D占用感知使人们能够全面了解3D世界,并支持自动驾驶中的各种任务。现有的基于占用的应用程序包括分割、检测、流量预测和规划。(1) 分割:语义占用感知本质上可以看作是一个三维语义分割任务。(2) 检测:OccupancyM3D和SOGDet是实现三维物体检测的两个基于占用的作品。OccuencyM3D首先学习占用以增强3D特征,然后将其用于3D检测。SOGDet开发了两个并行任务:语义占用预测和3D对象检测,同时训练这些任务以实现相互增强。(3) 流量预测:Cam4Occ从占用的角度预测三维空间中的前景流量,并实现对周围三维环境变化的理解。(4) 规划:OccNet将物理3D场景量化为语义占用,并训练共享占用描述符。该描述符被馈送到各种任务头以实现驾驶任务。例如,运动规划头输出自车的规划轨迹。

然而,现有的基于占用的应用程序主要关注感知层面,而较少关注决策层面。鉴于3D占用比其他感知方式(如鸟瞰感知和透视感知)更符合3D物理世界,我们认为3D占用在自动驾驶中有更广泛的应用机会。在感知层面,它可以提高现有轨迹预测、3D物体跟踪和3D车道线检测的准确性。在决策层面,它可以帮助更安全的驾驶决策,并为驾驶行为提供3D解释。

部署效率

对于复杂的3D场景,总是需要处理和分析大量的点云数据或多视图视觉信息,以提取和更新占用状态信息。为了实现自动驾驶应用程序的实时性能,解决方案通常需要在有限的时间内完成计算,并需要高效的数据结构和算法设计。一般来说,在目标边缘设备上部署深度学习算法不是一项容易的任务。

目前,已经尝试在占用任务上进行一些实时工作。例如,Hou等人提出了一种基于输入分辨率、视图转换模块和预测头的调整来加快预测推理速度的解决方案FastOcc。刘等人提出了SparseOcc,一种没有任何密集三维特征的稀疏占用网络,以最小化基于稀疏卷积层和掩模引导的稀疏采样的计算成本。唐等人提出采用稀疏潜在表示代替TPV表示和稀疏插值运算,以避免信息丢失,降低计算复杂度。然而,上述方法距离采用自动驾驶系统的实时部署还有一段距离。

鲁棒3D占用预测

在动态和不可预测的真实世界驾驶环境中,感知鲁棒性对自动驾驶汽车的安全至关重要。现有技术的3D占用模型可能容易受到分布外的场景和数据的影响,例如会引入视觉偏差的照明和天气变化,以及由车辆运动引起的输入图像模糊。此外,传感器故障(例如,丢失帧和相机视图)也很常见。鉴于这些挑战,研究稳健的3D占用感知是有价值的。

然而,对稳健3D占用率的研究有限,主要是由于数据集的稀缺性。最近,ICRA 2024 RoboDrive挑战赛为研究稳健的3D占用感知提供了不完美的场景。我们认为,稳健BEV感知的相关工作可以启发稳健占用感知的研究。M-BEV提出了随机掩蔽和重建相机视图,以增强在各种丢失相机情况下的鲁棒性。GKT采用粗投影来实现鲁棒的BEV表示。在大多数涉及自然损伤的情况下,多模态模型因多模态输入的互补性而优于单模态模型。此外,在3D LiDAR感知中,Robo3D将知识从具有完整点云的教师模型提取到具有不完美输入的学生模型,从而增强了学生模型的鲁棒性。基于这些工作,实现稳健的3D占用感知可以包括但不限于稳健的数据表示、多种模式、网络架构和学习策略。

泛化性

3D标签是昂贵的,并且用于真实世界的大规模3D注释是不切实际的。在有限的3D标记数据集上训练的现有网络的泛化能力尚未得到广泛研究。为了摆脱对3D标签的依赖,自监督学习代表了一种实现广义3D占用感知的潜在途径。它从广泛的未标记图像中学习占用感知。然而,目前自监督的入住感知表现不佳。在Occ3D nuScene数据集上(见表4),自监督方法的最高精度在很大程度上低于强监督方法。此外,目前的自我监督方法需要用更多的数据进行训练和评估。因此,增强自监督广义三维占有率是未来一个重要的研究方向。此外,当前的3D占用感知只能识别一组预定义的对象类别,这限制了其可推广性和实用性。大型语言模型(LLM)和大型视觉语言模型(LVLMs)的最新进展表明,它们具有很好的推理和视觉理解能力。整合这些预先训练的大型模型已被证明可以增强感知的泛化能力。POP-3D利用强大的预训练视觉语言模型来训练其网络,并实现开放词汇的3D占用感知。因此,我们认为使用LLM和LVLMs是实现广义3D占用感知的挑战和机遇。

结论

本文对近年来自动驾驶中的3D占用感知进行了全面的调查。我们详细回顾和讨论了最先进的以激光雷达为中心、以视觉为中心和多模式感知解决方案,并重点介绍了该领域的信息融合技术。为了便于进一步研究,提供了现有占用方法的详细性能比较。最后,我们描述了一些悬而未决的挑战,这些挑战可能会启发未来几年的研究方向。我们希望这项调查能造福社区,支持自动驾驶的进一步发展,并帮助不熟练的读者在该领域导航。

参考

[1] A Survey on Occupancy Perception for Autonomous Driving: The Information Fusion Perspective

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

LSKA注意力 | 重新思考和设计大卷积核注意力,性能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改进小型ViT

ICCV2023|涨点神器!目标检测蒸馏学习新方法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图像融合与分割研究:全时多模态基准与多交互特征学习

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 解决DeepSORT等跟踪方法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,性能直逼GPT-4

SAM-Med2D:打破自然图像与医学图像的领域鸿沟,医疗版 SAM 开源了!

GhostSR|针对图像超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追踪模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,性能达到UNet家族的巅峰!

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

标签:占用,语义,融合,Occupancy,工业界,mIoU,感知,激光雷达,3D From: https://www.cnblogs.com/wxkang/p/18196946