本地部署 Llama3 – 8B/70B 大模型!最简单的方法: 支持CPU /GPU运行 【3种方案】

目前在开源大模型领域,Llama3 无疑是最强的!这次Meta不仅免费公布了 8B和70B两个性能强悍的大模型,400B也即将发布,这是可以和GPT-4对打的存在!今天我们就来介绍3各本地部署方法,简单易懂,非常适合新手!

1. GPT4All : 适合低配置用户,可以在CPU/GPU上跑 【点击下载:https://gpt4all.io/index.html】

2.LMstudio ,支持下载多模型 8B/70B 等,模型选择更多!【点击下载:https://lmstudio.ai/】

提醒:如果你不在海外,实在下载不了模型,

请通过网盘获取 【点击下载:https://www.123pan.com/s/jZKSVv-M1Xfv.html】 提取码:uBNq

3.Ollama,支持多平台!Windows / Mac /Linux 都可以运行 【点击下载:https://ollama.com/】

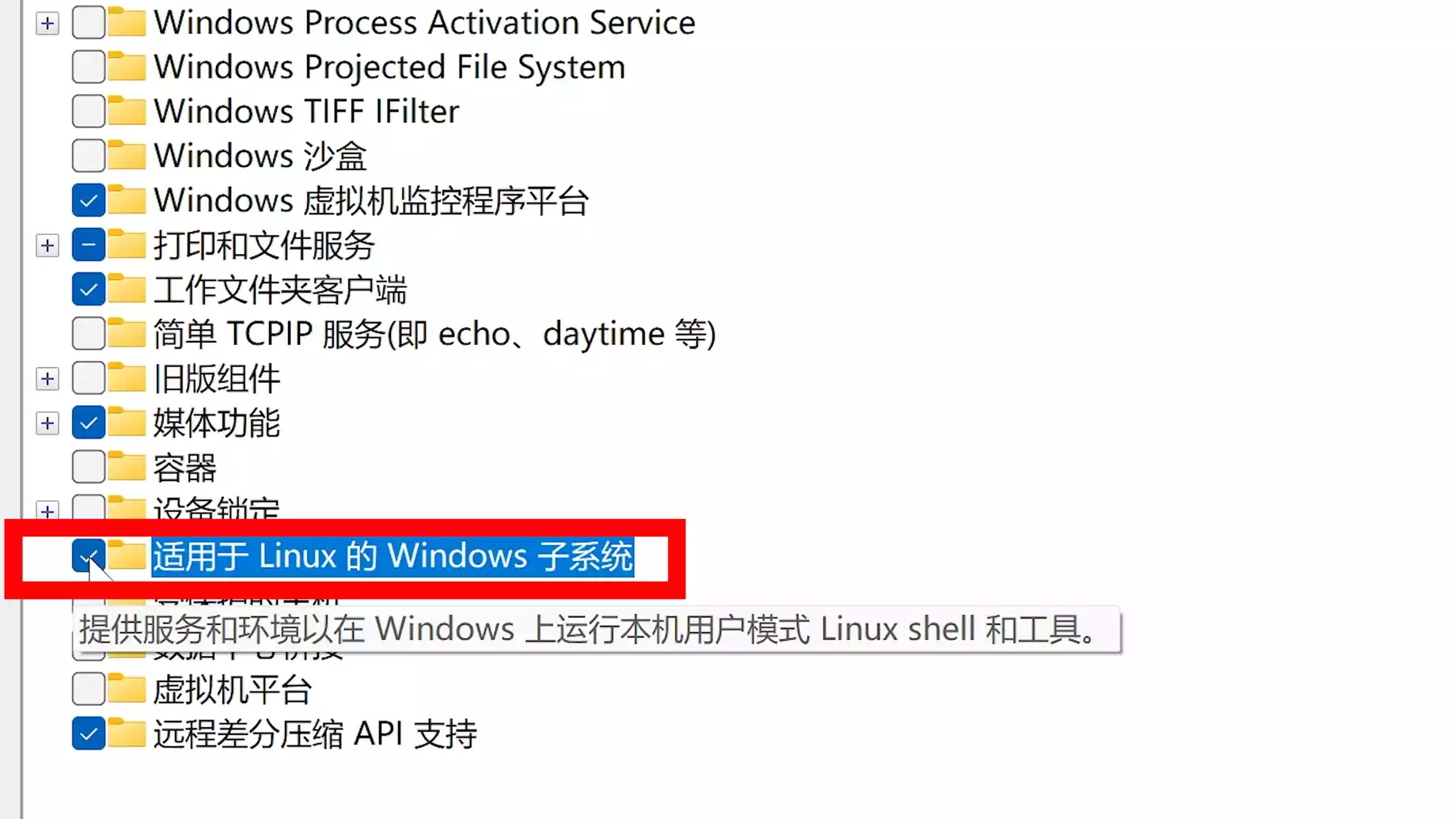

并在 Windows 上打开 WSL 功能:

安装Docker Desktop :【点击前往:https://www.docker.com/products/docker-desktop/】

然后本地安装webUI

(1)在CPU下运行:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

(2)支持GPU运行:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

安装完成通过本地地址:http://127.0.0.1:3000 进行访问

参考连接:https://www.freedidi.com/12189.html

参考视频:https://www.youtube.com/watch?v=NP0s7T9Mou8

标签:8B,447,Llama3,--,webui,https,GPU,open,CPU From: https://www.cnblogs.com/hechangchun/p/18158688