LoRA可以说是针对特定任务高效训练大型语言模型的重大突破。它被广泛应用于许多应用中。在本文中,我们将解释LoRA本身的基本概念,然后介绍一些以不同的方式改进LoRA的功能的变体,包括LoRA+、VeRA、LoRA- fa、LoRA-drop、AdaLoRA、DoRA和Delta-LoRA。

Lora

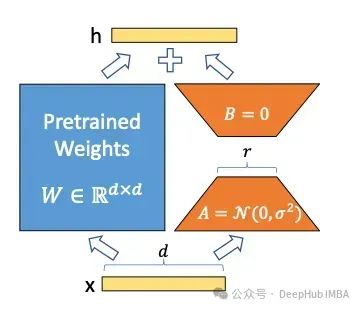

低秩自适应(Low-Rank adaptation, LoRA)[1]是目前广泛用于训练大型语言模型(large language models, llm)的一种技术。大型语言模型可以为我们生成各种内容,但对于解决许多问题来说,我们还是希望在给定的下游任务上训练LLM,例如对句子进行分类或生成给定问题的答案。但是如果直接使用微调,这就需要要训练有数百万到数十亿个参数的大模型。

https://avoid.overfit.cn/post/76413f0a06ec48b08186b28f88da206f

标签:模型,AdaLoRA,DoRA,Delta,变体,LoRA From: https://www.cnblogs.com/deephub/p/18075147