这篇论文总结了现有LLM在金融领域的应用现状,推荐和金融相关或者有兴趣的朋友都看看

论文分为2大部分:

1、作者概述了使用llm的现有方法

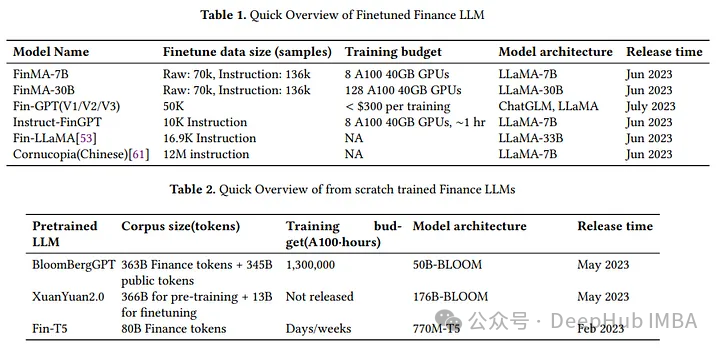

包括使用零样本或少样本的预训练模型,对特定于领域的数据进行微调,还有从头开始训练定制llm,并给出了关键模型的总结与评价。

2、根据给定的用例、数据约束、计算和性能需求,提出决策框架,指导选择合适的LLM解决方案,这是这篇论文可以好好阅读的地方,因为论文还对在金融领域使用LLM的局限性和挑战提出了一些见解。

论文从总结语言模型架构经历了重大的演变开始:

1、从n-gram模型中,下一个单词的概率完全取决于前面的(n-1)个单词

2、以RNN为基础的模型,如LSTM或GRU,神经网络架构,捕获序列数据中的长期依赖关系。

3、2017年,Transformer架构标志着语言模型的革命,在翻译等任务中表现优于rnn,并且梳理了一些著名模型:

GPT(Generative Pretrained Transformer):一个仅用于编码器的框架,以其在生成连贯文本方面的有效性而闻名。

BERT(Bidirectional Encoder Representations from Transformers):一个仅用于解码器的框架,擅长从文本的两个方向理解上下文。

T5 (Text-to-Text Transfer Transformer):采用编码器和解码器两种结构,拓宽了应用范围,最著名的就是翻译任务。

https://avoid.overfit.cn/post/49595cb2da41438787b404e070ae7f8c

标签:Transformer,架构,语言,模型,论文,领域,LLM From: https://www.cnblogs.com/deephub/p/17995845