引言

SLAM(Simultaneous Localization and Mapping,即时定位与地图构建)是机器人学和计算机视觉领域的一项关键技术。它允许机器人在未知环境中自主导航,同时构建环境的地图并确定自身的精确位置。SLAM 技术在机器人、无人驾驶、增强现实和无人机等领域有着广泛的应用。本文将全面详细地介绍 SLAM 的原理和技术实现,帮助读者深入理解这一领域的核心内容。

SLAM 的基本概念

1. 什么是 SLAM?

SLAM 是 Simultaneous Localization and Mapping 的缩写,中文译作“同时定位与地图构建”。它是指搭载特定传感器的主体,在没有环境先验信息的情况下,于运动过程中建立环境的模型,同时估计自己的运动状态。SLAM 的核心问题可以描述为:

- 定位:机器人需要知道它在环境中的位置。

- 建图:机器人需要知道环境的布局和结构。

这两个任务是相互依赖的:

- 定位需要依赖于已知的地图信息。

- 建图需要依赖于机器人的位置信息。

2. SLAM 的发展历程

SLAM 最早由 Smith、Self 和 Cheeseman 于 1988 年提出。由于其重要的理论与应用价值,被很多学者认为是实现真正全自主移动机器人的关键。随着时间的推移,SLAM 技术不断发展,出现了多种传感器和算法,包括激光雷达、摄像头、惯性测量单元(IMU)等。

SLAM 的工作原理

1. 感知

机器人通过传感器(如激光雷达、摄像头等)收集环境数据。感知数据通常包括距离测量、图像特征等。

2. 特征提取

从感知数据中提取有用的特征点或特征描述子。特征点可以是环境中的角落、边缘或其他显著点。常用的特征提取方法包括 SIFT(Scale-Invariant Feature Transform)、SURF(Speeded-Up Robust Features)、ORB(Oriented FAST and Rotated BRIEF)等。

3. 数据关联

将当前观测到的特征点与已有地图中的特征点进行匹配。数据关联是 SLAM 中最关键的一步,错误的关联会导致地图构建失败。常用的数据关联方法包括最近邻匹配、RANSAC(Random Sample Consensus)等。

4. 状态估计

使用滤波器(如扩展卡尔曼滤波器、粒子滤波器等)估计机器人的位置和姿态。同时更新地图中的特征点位置。常用的状态估计方法包括 EKF-SLAM(Extended Kalman Filter SLAM)、FastSLAM(FastSLAM)等。

5. 地图更新

根据新的观测数据和状态估计结果,更新地图。地图可以是点云地图、栅格地图或拓扑地图等。

6. 回环检测

当机器人回到之前访问过的位置时,检测并修正累积的定位误差。回环检测有助于减少地图中的漂移误差。常用的回环检测方法包括视觉词袋模型、几何验证等。

7. 优化

对地图和轨迹进行全局优化,提高地图的准确性和一致性。常用的优化方法包括图优化(Graph Optimization)和束调整(Bundle Adjustment)。

SLAM 的传感器选择

1. 激光雷达

激光雷达是最古老的 SLAM 传感器之一,提供机器人本体与周围环境障碍物间的距离信息。常见的激光雷达品牌包括 SICK、Velodyne 和国产的 RPLIDAR 等。激光雷达的优点是精度高、速度快,计算量不大,容易做成实时 SLAM。缺点是价格昂贵,会大幅提高机器人的成本。

2. 摄像头

视觉 SLAM 是 21 世纪 SLAM 研究热点之一。视觉 SLAM 可以分为单目、双目(或多目)和 RGB-D 三种类型:

- 单目相机:只用一支摄像头完成 SLAM,传感器简单、成本低。单目 SLAM 的主要问题是无法确切地得到深度,需要通过运动中的三角测量来估计。

- 双目相机:通过多个相机之间的基线估计空间点的位置。双目相机可以在运动和静止时估计深度,但配置和标定较为复杂。

- RGB-D相机:通过红外结构光或 Time-of-Flight 原理直接测出图像中各像素离相机的距离。RGB-D 相机提供丰富的信息,但存在测量误差和计算量大的问题。

3. 惯性测量单元(IMU)

IMU 可以提供机器人的加速度和角速度信息,常用于辅助视觉 SLAM 和激光 SLAM,提高系统的鲁棒性和准确性。

SLAM 的算法分类

1. 基于滤波器的 SLAM

基于滤波器的 SLAM 方法通过递归估计状态,常用的方法包括:

- 扩展卡尔曼滤波器(EKF-SLAM):适用于线性系统,计算效率较高,但对非线性系统的适应性较差。

- 粒子滤波器(FastSLAM):适用于非线性、非高斯分布的情况,鲁棒性强,但计算复杂度较高,需要大量的粒子。

2. 基于图优化的 SLAM

基于图优化的 SLAM 方法通过构建图模型进行全局优化,常用的方法包括:

- 图优化(g2o):将 SLAM 问题转化为图优化问题,通过最小化误差函数来优化地图和轨迹。

- 束调整(Bundle Adjustment):通过优化所有观测数据之间的约束关系,提高地图的准确性和一致性。

3. 基于深度学习的 SLAM

近年来,深度学习在 SLAM 领域也取得了显著进展。基于深度学习的 SLAM 方法利用神经网络的强大特征提取和回归能力,实现端到端的 SLAM。常用的方法包括:

- 直接法(Direct Method):直接使用图像像素信息进行定位和建图,不需要提取特征点。

- 基于深度学习的视觉 SLAM:结合卷积神经网络(CNN)和循环神经网络(RNN)等技术,提高 SLAM 的鲁棒性和准确性。

SLAM 的技术挑战

1. 数据关联

错误的特征点匹配会导致地图构建失败。解决方法包括使用鲁棒的特征描述子和多假设匹配。

2. 动态环境

动态物体(如行人、车辆)会影响定位和建图的准确性。解决方法包括使用动态对象检测和剔除技术。

3. 计算效率

SLAM 算法需要实时运行,对计算资源的要求很高。解决方法包括优化算法结构,使用硬件加速(如 GPU)。

4. 回环检测

回环检测是减少地图漂移的关键,但容易出现误检和漏检。解决方法包括使用视觉词袋模型和几何验证。

5. 多传感器融合

单一传感器的数据往往不足以满足高精度要求。解决方法包括融合多种传感器数据,提高定位和建图的准确性。

SLAM 的应用场景

1. 机器人导航

SLAM 技术广泛应用于自主移动机器人在未知环境中的导航,包括家用服务机器人、工业机器人和无人驾驶清洁机器人等。

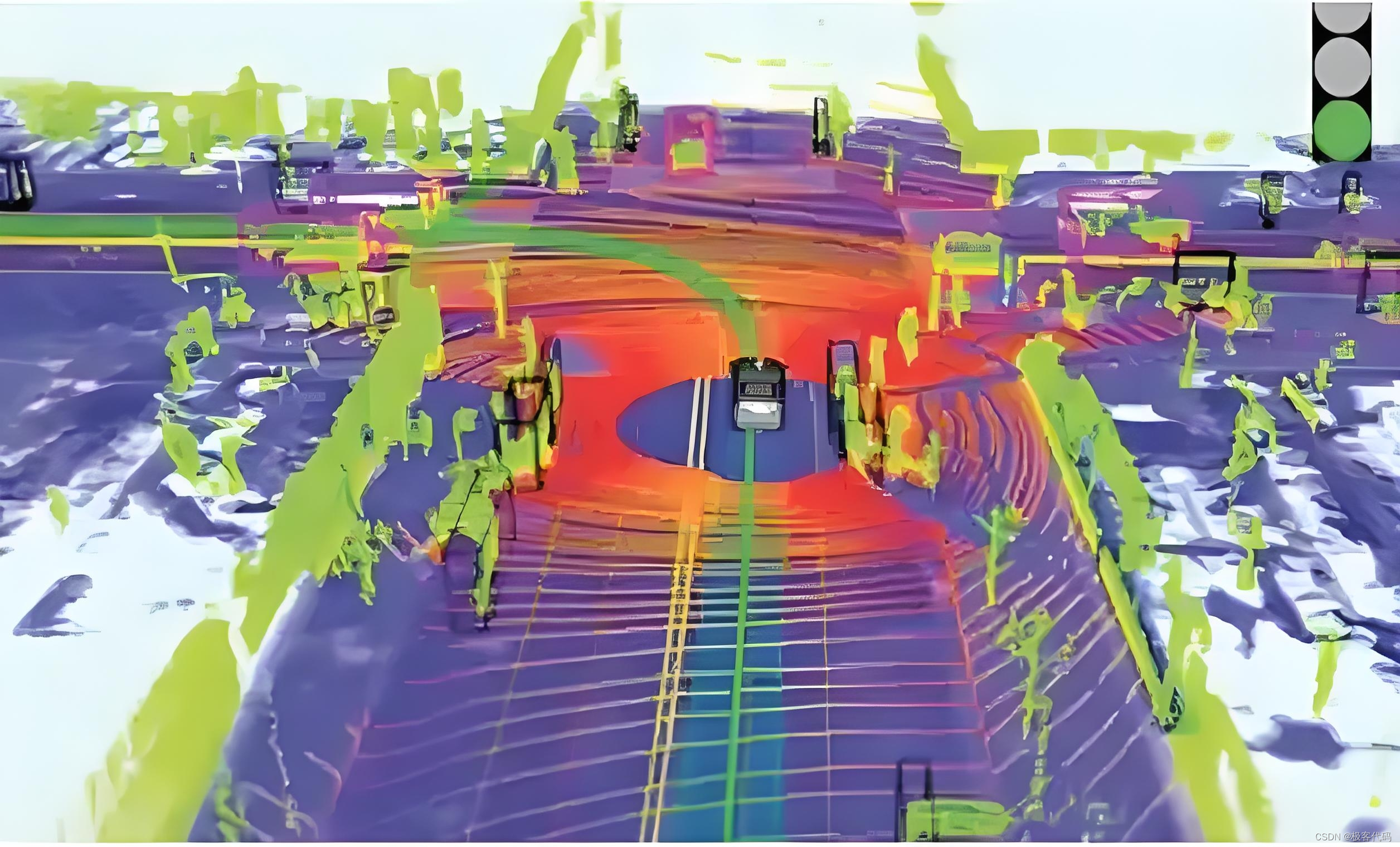

2. 无人驾驶

SLAM 技术帮助自动驾驶汽车理解周围环境,实现自主导航和避障。常见的应用场景包括自动驾驶汽车、无人机和无人船等。

3. 增强现实与虚拟现实

SLAM 技术在 AR/VR 领域用于在现实世界中叠加虚拟信息,实现三维重建和场景模拟。

4. 智能监控与安防

SLAM 技术在智能监控系统中用于实现自主巡逻和目标跟踪,提高安全性和效率。

5. 其他领域

SLAM 技术还在救援机器人、农业自动化和空间探索等领域有着广泛的应用。

实战案例:基于激光雷达的 SLAM 实现

假设你正在开发一个自主移动机器人,需要在未知环境中进行导航。项目结构如下:

robot-navigation/

├── laser_data.csv

├── map.pcd

└── robot_pose.txt

1. 初始化 SLAM 系统

import numpy as np

import open3d as o3d

# 初始化地图

map = o3d.geometry.PointCloud()

# 初始化机器人位姿

robot_pose = np.eye(4)

2. 读取激光雷达数据

def read_laser_data(file_path):

data = np.loadtxt(file_path, delimiter=',')

return data

laser_data = read_laser_data('laser_data.csv')

3. 特征提取

def extract_features(laser_data):

# 假设激光雷达数据已经包含了特征点

features = laser_data

return features

features = extract_features(laser_data)

4. 数据关联

def associate_data(current_features, map_features):

# 使用最近邻匹配进行数据关联

distances = np.linalg.norm(current_features[:, np.newaxis] - map_features, axis=2)

min_indices = np.argmin(distances, axis=1)

return min_indices

map_features = np.array(map.points)

min_indices = associate_data(features, map_features)

5. 状态估计

def estimate_pose(current_features, map_features, min_indices):

# 使用 RANSAC 进行姿态估计

src_points = current_features[min_indices]

dst_points = map_features

transform, _ = o3d.pipelines.registration.registration_ransac_based_on_correspondence(

src_points, dst_points, min_indices, max_correspondence_distance=0.05,

estimation_method=o3d.pipelines.registration.TransformationEstimationPointToPoint()

)

return transform

transform = estimate_pose(features, map_features, min_indices)

robot_pose = np.dot(transform.transformation, robot_pose)

6. 地图更新

def update_map(map, features, transform):

transformed_features = np.dot(transform.transformation[:3, :3], features.T).T + transform.transformation[:3, 3]

map.points.extend(o3d.utility.Vector3dVector(transformed_features))

return map

map = update_map(map, features, transform)

7. 回环检测

def detect_loop_closure(current_features, map_features):

# 使用视觉词袋模型进行回环检测

bag_of_words = create_bag_of_words(map_features)

current_bow = create_bow(current_features)

similarity_scores = compute_similarity(bag_of_words, current_bow)

loop_closure_index = np.argmax(similarity_scores)

return loop_closure_index

loop_closure_index = detect_loop_closure(features, map_features)

8. 优化

def optimize_map(map, poses, loop_closure_index):

# 构建图模型

graph = build_graph(map, poses)

# 添加回环约束

add_loop_closure_constraint(graph, loop_closure_index)

# 进行图优化

optimized_graph = optimize_graph(graph)

return optimized_graph

optimized_graph = optimize_map(map, [robot_pose], loop_closure_index)

9. 保存结果

def save_results(map, poses, file_paths):

o3d.io.write_point_cloud(file_paths['map'], map)

np.savetxt(file_paths['poses'], poses)

file_paths = {'map': 'map.pcd', 'poses': 'robot_pose.txt'}

save_results(map, [robot_pose], file_paths)

通过这个实战案例,读者可以更直观地理解基于激光雷达的 SLAM 系统是如何实现的。希望这些示例能帮助你在实际工作中更好地应用 SLAM 技术。

实战案例:基于视觉的 SLAM 实现

假设你正在开发一个增强现实应用,需要在未知环境中进行实时定位和建图。项目结构如下:

ar-application/

├── images/

│ ├── image_0001.jpg

│ └── ...

├── camera_params.json

├── map.ply

└── trajectory.txt

1. 初始化 SLAM 系统

import cv2

import numpy as np

import json

import open3d as o3d

# 读取相机参数

with open('camera_params.json', 'r') as f:

camera_params = json.load(f)

camera_matrix = np.array(camera_params['camera_matrix'])

dist_coeffs = np.array(camera_params['dist_coeffs'])

# 初始化地图

map = o3d.geometry.PointCloud()

# 初始化机器人位姿

robot_pose = np.eye(4)

2. 读取图像数据

def read_images(image_dir):

images = []

for filename in sorted(os.listdir(image_dir)):

if filename.endswith('.jpg'):

image_path = os.path.join(image_dir, filename)

image = cv2.imread(image_path)

images.append(image)

return images

images = read_images('images/')

3. 特征提取

def extract_features(image):

orb = cv2.ORB_create()

keypoints, descriptors = orb.detectAndCompute(image, None)

return keypoints, descriptors

keypoints, descriptors = extract_features(images[0])

4. 数据关联

def associate_data(current_descriptors, map_descriptors):

bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)

matches = bf.match(current_descriptors, map_descriptors)

matches = sorted(matches, key=lambda x: x.distance)

return matches

map_keypoints, map_descriptors = [], []

for image in images:

kp, desc = extract_features(image)

map_keypoints.extend(kp)

map_descriptors.extend(desc)

matches = associate_data(descriptors, map_descriptors)

5. 状态估计

def estimate_pose(keypoints1, keypoints2, matches):

points1 = np.float32([keypoints1[m.queryIdx].pt for m in matches])

points2 = np.float32([keypoints2[m.trainIdx].pt for m in matches])

E, mask = cv2.findEssentialMat(points1, points2, camera_matrix, method=cv2.RANSAC, prob=0.999, threshold=1.0)

_, R, t, _ = cv2.recoverPose(E, points1, points2, camera_matrix)

return R, t

R, t = estimate_pose(keypoints, map_keypoints, matches)

robot_pose[:3, :3] = R

robot_pose[:3, 3] = t.flatten()

6. 地图更新

def update_map(map, keypoints, descriptors, robot_pose):

points3D = cv2.triangulatePoints(

camera_matrix @ robot_pose[:3],

camera_matrix @ np.eye(3),

keypoints[0].reshape(-1, 1, 2),

keypoints[1].reshape(-1, 1, 2)

)

points3D /= points3D[3]

map.points.extend(o3d.utility.Vector3dVector(points3D[:3].T))

return map

map = update_map(map, keypoints, descriptors, robot_pose)

7. 回环检测

def detect_loop_closure(current_descriptors, map_descriptors):

bag_of_words = create_bag_of_words(map_descriptors)

current_bow = create_bow(current_descriptors)

similarity_scores = compute_similarity(bag_of_words, current_bow)

loop_closure_index = np.argmax(similarity_scores)

return loop_closure_index

loop_closure_index = detect_loop_closure(descriptors, map_descriptors)

8. 优化

def optimize_map(map, poses, loop_closure_index):

graph = build_graph(map, poses)

add_loop_closure_constraint(graph, loop_closure_index)

optimized_graph = optimize_graph(graph)

return optimized_graph

optimized_graph = optimize_map(map, [robot_pose], loop_closure_index)

9. 保存结果

def save_results(map, poses, file_paths):

o3d.io.write_point_cloud(file_paths['map'], map)

np.savetxt(file_paths['poses'], poses)

file_paths = {'map': 'map.ply', 'poses': 'trajectory.txt'}

save_results(map, [robot_pose], file_paths)

通过这个实战案例,读者可以更直观地理解基于视觉的 SLAM 系统是如何实现的。希望这些示例能帮助你在实际工作中更好地应用 SLAM 技术。

结论

SLAM 技术是机器人学和计算机视觉领域的核心技术之一,它允许机器人在未知环境中自主导航,同时构建环境的地图并确定自身的精确位置。本文全面详细地介绍了 SLAM 的原理和技术实现,包括感知、特征提取、数据关联、状态估计、地图更新、回环检测和优化等关键步骤。希望本文能为读者提供有价值的指导,帮助他们在实际工作中更好地应用 SLAM 技术。

SLAM 技术的发展仍在继续,未来的研究方向包括:

- 多传感器融合:结合多种传感器数据,提高系统的鲁棒性和准确性。

- 实时性能:优化算法,提高 SLAM 的实时性能,使其在资源受限的设备上也能高效运行。

- 深度学习:利用深度学习技术,进一步提高 SLAM 的鲁棒性和泛化能力。

通过不断的研究和创新,SLAM 技术将在更多领域发挥重要作用,推动智能机器人的发展和应用。

标签:map,features,Localization,descriptors,pose,SLAM,np,机器人学 From: https://blog.csdn.net/suifengme/article/details/143661825