理论基础

算法本质与背景

层次化(Hierarchial)Softmax算法是在深度学习领域中解决大规模词嵌入训练效率问题的重要突破。该算法通过引入Huffman树结构,有效地将传统Softmax的计算复杂度从线性降至对数级别,从而在处理大规模词汇表时表现出显著的优势。

在传统的神经网络词嵌入模型中,Softmax函数扮演着将任意实数向量转换为概率分布的关键角色。其基本形式可表述为:

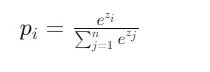

给定分数向量 z =[*z_1,*z_2,…,zn],类别 i 的概率计算公式为:

这种计算方式在处理大规模词汇表时面临着严重的计算瓶颈。当词汇表规模达到百万级别时,每次预测都需要计算整个词汇表的概率分布,这在实际应用中是难以接受的。

https://avoid.overfit.cn/post/88ee8ff7530243a7ab6ec40b276ab8a7

标签:层次化,词汇表,大规模,神经网络,Softmax,Huffman From: https://www.cnblogs.com/deephub/p/18596634