最近的一项研究广泛探讨了小语言模型(slm)在现代 AI 中的作用。该研究对 slm 进行了全面分析,重点关注其功能、应用和潜在优势,特别是与大型模型相比。本研究强调了 slm 在需要效率和可解释性的领域中的重要性,同时也讨论了它们在大型模型可能不实用的特定任务中的相关性。

最近的一项研究通过两个视角考察了大型语言模型(LLM)和小型语言模型(SLM)之间的关系:协作和竞争。

随着LLM的规模扩大,它们的计算成本和能源需求呈指数级增长,这使得资源有限的研究人员和企业更难以获得它们。

同时,小模型(SMs)在实际应用中仍然被广泛使用,但往往被低估。最近的一项研究探讨了LLM和 slm 之间的关系,研究了它们如何协作和竞争,旨在为优化 AI 系统的计算效率提供见解。

小语言模型(Small Language Models, slm)让人兴奋的是正在开发的创新训练技术,特别是使用大型模型来生成不同的、特定于拓扑的训练数据。

slm 也正在演变成具有本地托管和推理能力的多模态系统。

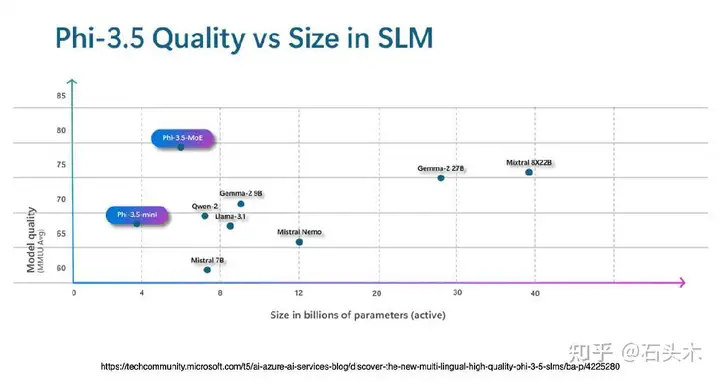

像 Phi-3.5 这样的开源模型展示了这些较小模型的强大功能。此外,像模型量化这样的进步正在扩展托管选项的范围,使各种应用程序更容易访问 slm,同时保持高性能。

slm 也被训练成不灌输特定的知识,或者使

模型知识密集。而是去改变模型的行为。

模型

扩大模型尺寸会导致计算成本和能源消耗显著增加,使得大型模型对于资源有限的研究人员和企业来说不切实际。

LLM和 SMs/ slm 可以协作以平衡性能和效率——LLM管理复杂的任务,而 SMs 处理更集中、资源效率更高的任务。

然而,由于 SMs 的简单性、较低的成本和可访问性,在受限环境或需要高度可解释性的任务中,SMs 通常优于LLM。选择取决于特定任务的需求,SMs 在特定应用程序中表现出色。

协作

LLM和较小模型之间的协作可以平衡功率和效率,从而产生资源高效、可扩展、可解释和成本效益高的系统,同时仍然保持高性能和灵活性。

较小的模型具有独特的优势,例如简单,成本较低和更大的可解释性,使它们非常适合利基市场。根据任务或应用程序的特定需求评估LLM和较小模型之间的权衡是很重要的。

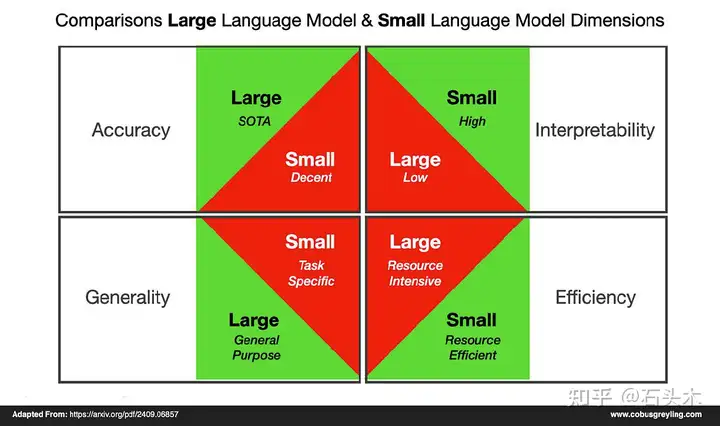

精度

大型语言模型(Large language models, llm)由于具有大量的参数和对不同数据集的广泛训练,在各种自然语言处理任务中表现出出色的性能。

虽然较小的模型通常在较低的水平上执行,但当使用知识蒸馏等技术进行改进时,它们仍然可以获得类似的结果。

普遍性

LLM是高度通用的,能够处理范围广泛的任务,只有几个训练的例子。

相比之下,较小的模型往往更专业化,研究表明,在特定领域的数据集上对它们进行微调,有时可以在特定任务上比一般LLM获得更好的性能。

效率

LLM需要大量的计算资源进行训练和推理,导致高成本和延迟,这使得它们不太适合实时应用,如信息检索,或在资源有限的环境中,如边缘设备。

相比之下,较小的模型需要更少的训练数据和计算能力,在提供有竞争力的性能的同时大大降低了资源需求。

可解释性

与更大、更复杂的模型相比,更小、更简单的模型通常更透明、更容易解释。

在医疗保健、金融和法律等领域,较小的模型通常更受青睐,因为它们的决策需要被医生或金融分析师等非专家容易理解。

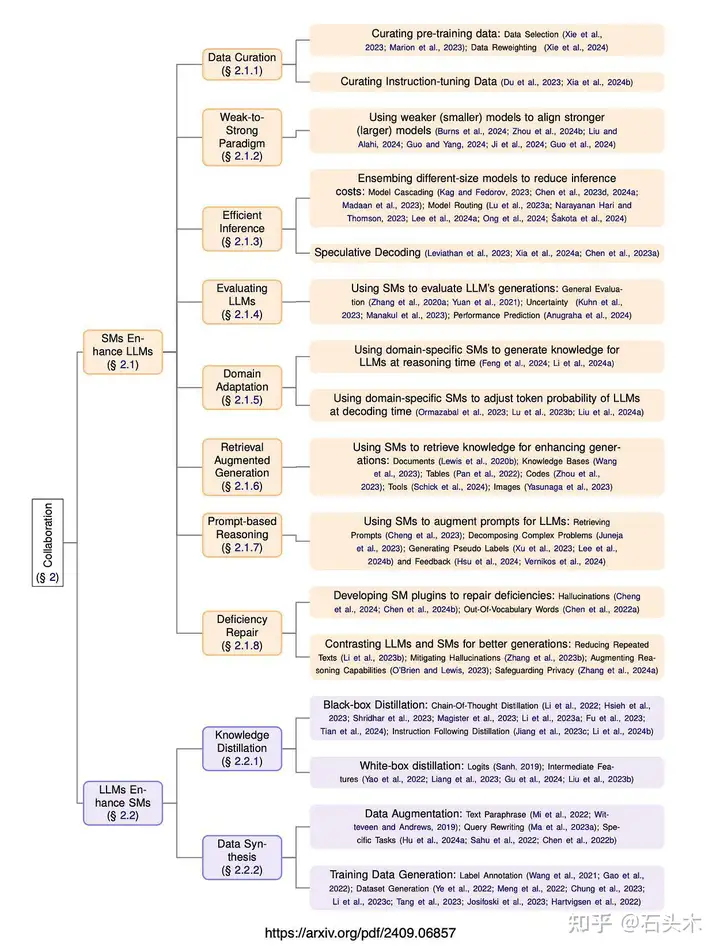

合作研究

下面是一个深刻的图形,说明了小型和大型语言模型之间的协作。

它强调了小模型如何经常支持或增强大模型的能力,展示了它们在提高效率、可伸缩性和性能方面的关键作用。

这些例子清楚地表明,在补充大型系统的同时,小型模型在优化资源使用方面发挥着至关重要的作用。

最后

协作潜力

LLM和较小的模型(SMs)可以一起工作以优化性能和效率。

特定场景竞争

SMs 在计算受限的环境和需要高可解释性的特定于任务的应用程序中表现更好。

SMs 优点

SMs 更简单,更经济,更容易理解,在专业领域很有价值。

权衡评估

在LLMs和 SMs 之间的选择取决于任务的资源需求、可解释性和复杂性。

标签:时代,模型,SMs,解释性,slm,特定,LLM From: https://www.cnblogs.com/little-horse/p/18438566