掌握BERT:从初学者到高级的自然语言处理(NLP)全面指南

本文是对该文的翻译,感谢 Rayyan Shaikh 在 Medium 论坛上的文章~

引言:

BERT(Bidirectional Encoder Representations from Transformers)是由Google开发的一种革命性的自然语言处理(NLP)模型。它改变了语言理解任务的格局,使机器能够理解语言的上下文和细微差别。在本博客中,我们将带领您从BERT的基础知识到高级概念,全面解释、示例和代码片段一应俱全。

目录

1. BERT简介

- BERT是什么?

- BERT为何重要?

- BERT如何工作?

2. 为BERT预处理文本

- 分词(Tokenization)

- 输入格式化

- 掩码语言模型(MLM)目标

3. 针对特定任务微调BERT

- BERT的架构变体(BERT-base, BERT-large等)

- NLP中的迁移学习

- 下游任务和微调

- 示例:使用BERT进行文本分类

4. BERT的注意力机制

- 自注意力(Self-Attention)

- 多头注意力(Multi-Head Attention)

- BERT中的注意力

- 注意力权重的可视化

5. BERT的训练过程

- 预训练阶段

- 掩码语言模型(Masked Language Model,MLM)目标

- 下一句预测(Next Sentence Prediction,NSP)目标

6. BERT嵌入

- 词嵌入与上下文词嵌入

- WordPiece分词

- 位置编码

7. BERT的高级技术

- 微调策略

- 处理词汇表外(OOV)单词

- 使用BERT进行领域适应

- BERT的知识蒸馏

8. 近期发展和变体

- RoBERTa(更强的基线)

- ALBERT(轻量级BERT)

- DistilBERT(紧凑版本)

- ELECTRA(高效学习编码器)

9. BERT用于序列到序列任务

- BERT用于文本摘要

- BERT用于语言翻译

- BERT用于对话AI

10. 常见挑战与缓解措施

- BERT的计算需求

- 处理长序列

- 克服BERT中的偏见

11. BERT在NLP的未来方向

- OpenAI的GPT模型

- BERT在预训练语言模型中的作用

- BERT应用中的伦理考虑

12. 使用Hugging Face Transformers库实现BERT

- 安装Transformers

- 加载预训练的BERT模型

- 分词和输入格式化

- 针对自定义任务微调BERT

第一章:BERT简介

什么是BERT?

在不断发展的自然语言处理(NLP)领域,一项名为BERT的突破性创新已成为改变游戏规则的存在。BERT,即Bidirectional Encoder Representations from Transformers,不仅仅是机器学习术语海洋中的另一个缩写。它代表了机器理解语言方式的转变,使它们能够理解构成人类交流丰富而有意义的复杂细微差别和上下文依赖关系。

BERT为何重要?

想象一个句子:“She plays the violin beautifully.”传统的语言模型会从左到右处理这个句子,忽略了乐器(“violin”)的身份对整个句子解释的关键事实。然而,BERT理解到上下文驱动的词间关系在推导意义中起着关键作用。它捕捉了双向性的本质,允许它考虑围绕每个词的完整上下文,从而彻底改变了语言理解的准确性和深度。

BERT如何工作?

BERT的核心是由一种强大的神经网络架构——Transformer驱动的。这种架构包含了一种称为自注意力的机制,使BERT能够根据上下文(前后文)来衡量每个词的重要性。这种上下文感知赋予BERT生成上下文化词嵌入的能力,即考虑句子中词义的词表示。这就像BERT反复阅读句子以深入理解每个词的作用。

考虑句子:“The ‘lead’ singer will ‘lead’ the band.”传统模型可能难以处理“lead”这个词的歧义。然而,BERT轻松地区分出第一个“lead”是名词,而第二个是动词,展示了其在消除语言结构歧义方面的能力。

在接下来的章节中,我们将展开一段旅程,揭开BERT的神秘面纱,带您从其基础概念到高级应用。您将探索如何利用BERT进行各种NLP任务,了解其注意力机制,深入其训练过程,并见证其对重塑NLP领域的影响。

当我们深入BERT的复杂性时,您会发现它不仅仅是一个模型;它是机器理解人类语言本质的一个范式转变。因此,系好安全带,我们将踏上这段关于BERT世界的启蒙之旅,在那里,语言理解超越了平凡,达到了非凡。

第二章:为BERT预处理文本

掩码语言模型(MLM)

在BERT对文本施展魔法之前,需要以一种它能理解的方式准备和结构化文本。在本章中,我们将探讨为BERT预处理文本的关键步骤,包括分词、输入格式化和掩码语言模型(MLM)目标。

分词:将文本分解为有意义的块

想象一下,您正在教BERT读一本书。您不会一次性递交整本书;您会将其分解成句子和段落。同样,BERT需要将文本分解成称为token的小单元。但这里有个转折:BERT使用WordPiece分词。它将单词拆分成更小的部分,比如将“running”变成“run”和“ning”。这有助于处理棘手的单词,并确保BERT不会迷失在不熟悉的单词中。

示例:原始文本:“ChatGPT非常迷人。” WordPiece Tokens:[“Chat”, “##G”, “##PT”, “is”, “fascinating”, “.”]

输入格式化:给BERT提供上下文

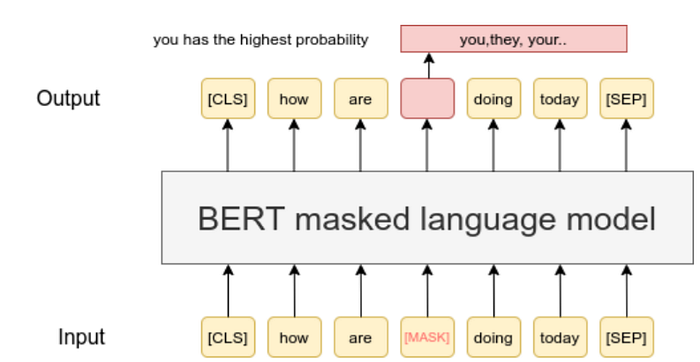

BERT喜欢上下文,我们需要以BERT能理解的方式提供给它。为此,我们将token格式化为BERT能理解的形式。我们在开头添加特殊token如[CLS](代表分类),在句子之间添加[SEP](代表分隔)。如图所示(机器语言模型)。我们还分配段嵌入来告诉BERT哪些token属于哪个句子。

示例:原始文本:“ChatGPT is fascinating.” 格式化Tokens:[“[CLS]”, “Chat”, “##G”, “##PT”, “is”, “fascinating”, “.”, “[SEP]”]

掩码语言模型(MLM)目标:教BERT理解上下文

BERT的秘密在于其理解双向上下文的能力。在其训练过程中,一些单词在句子中被掩码(替换为[MASK]),BERT学习从上下文中预测这些单词。这有助于BERT理解单词如何相互关联,无论是在之前还是之后。

示例:原始句子:“The cat is on the mat.” 掩码句子:“The [MASK] is on the mat.”

代码片段:使用Hugging Face Transformers进行分词

from transformers import BertTokenizertokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

text = "BERT预处理是必不可少的。"

tokens = tokenizer.tokenize(text)

print(tokens)

这段代码使用Hugging Face Transformers库,通过BERT分词器对文本进行分词。

在下一章中,我们将深入探讨针对特定任务微调BERT的迷人世界,并探索其注意力机制如何使其成为语言理解的高手。敬请期待更多内容!

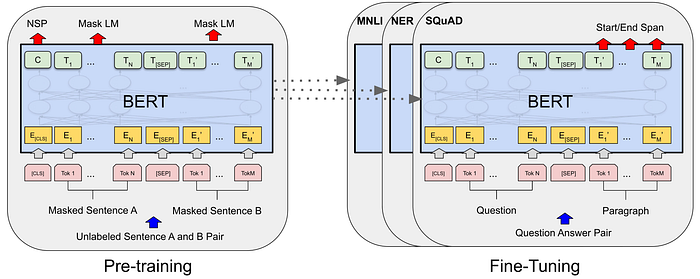

第3章:针对特定任务微调BERT

在理解了BERT的工作原理后,现在是时候将其神奇之处应用于实际任务了。在本章中,我们将探讨如何针对特定语言任务微调BERT。这涉及将预训练的BERT模型适应于文本分类等任务。让我们深入了解!

BERT的架构变体:寻找合适的模型

BERT有不同的变体,如BERT-base、BERT-large等。这些变体具有不同的模型大小和复杂性。选择取决于您的任务需求和您拥有的资源。较大的模型可能表现更好,但它们也需要更多的计算能力。

自然语言处理中的迁移学习:基于预训练知识的构建

将BERT想象成一个已经阅读了大量文本的语言专家。我们不是从头开始教它一切,而是在特定任务上对其进行微调。这就是迁移学习的魔力——利用BERT的预先知识并针对特定任务进行定制。这就像有一个知识渊博的家教,只需要一些特定科目的指导。

下游任务和微调:适应BERT的知识

我们为BERT微调的任务称为“下游任务”。示例包括情感分析、命名实体识别等。微调涉及使用特定任务的数据更新BERT的权重。这有助于BERT在不从头开始的情况下专门化这些任务。

示例:使用BERT进行文本分类

from transformers import BertForSequenceClassification, BertTokenizer

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

text = "This movie was amazing!"

inputs = tokenizer(text, return_tensors='pt')

outputs = model(**inputs)

predictions = torch.argmax(outputs.logits, dim=1)

print(predictions)

这段代码演示了使用Hugging Face Transformers库中的预训练BERT模型进行文本分类。

在这个代码片段中,我们加载了一个专为文本分类设计的预训练BERT模型。我们对输入文本进行分词,将其传递给模型,并获取预测结果。

针对特定任务微调BERT使其能够在实际应用中大放异彩。在下一章中,我们将揭示BERT注意力机制的内部工作原理,这是其上下文理解的关键。敬请期待,揭开更多秘密!

第4章:BERT的注意力机制

自注意力机制

既然我们已经看到了如何将BERT应用于任务,让我们深入了解BERT如此强大的原因——其注意力机制。在本章中,我们将探讨自注意力、多头注意力以及BERT的注意力机制如何使其掌握语言的上下文。

自注意力:BERT的超能力

想象一下阅读一本书并突出显示对你来说最重要的单词。自注意力就像这样,但对BERT来说。它查看句子中的每个单词,并根据其重要性决定应该给予其他单词多少注意力。这样,BERT可以关注相关单词,即使它们在句子中相距甚远。

多头注意力:团队合作的技巧

BERT不仅仅依赖一个视角;它使用多个“头”的注意力。将这些头想象成专注于句子不同方面的不同专家。这种多头方法帮助BERT捕捉单词之间的不同关系,使其理解更丰富和更准确。

BERT中的注意力:上下文的魔力

BERT的注意力不仅限于一个单词之前或之后的单词。它考虑两个方向!当BERT读取一个单词时,它不是孤立的;它意识到它的邻居。这样,BERT生成的嵌入考虑了单词的整个上下文。这就像理解一个笑话不仅通过笑点,还通过铺垫。

代码片段:可视化注意力权重

import torch

from transformers import BertModel, BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

text = "BERT's attention mechanism is fascinating."

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs, output_attentions=True)

attention_weights = outputs.attentions

print(attention_weights)

在这段代码中,我们使用Hugging Face Transformers库可视化BERT的注意力权重。这些权重显示了BERT在句子中对不同单词的关注程度。

BERT的注意力机制就像一束聚光灯,帮助它聚焦于句子中最重要的事物。在下一章中,我们将深入探讨BERT的训练过程,以及它是如何成为语言大师的。敬请期待更多见解!

第5章:BERT的训练过程

理解BERT如何学习是欣赏其能力的关键。在本章中,我们将揭示BERT训练过程的复杂性,包括其预训练阶段、掩码语言模型(MLM)目标和下一句预测(NSP)目标。

预训练阶段:知识基础

BERT的旅程始于预训练,它从大量文本数据中学习。想象一下向BERT展示数百万个句子,让它预测缺失的单词。这个练习帮助BERT建立对语言模式和关系的坚实理解。

掩码语言模型(MLM)目标:填空游戏

在预训练期间,BERT被给予一些单词被掩码(隐藏)的句子。然后它尝试根据上下文预测那些掩码单词。这就像语言版本的填空游戏。通过猜测缺失的单词,BERT学习单词之间的关系,实现其上下文的卓越性。

下一句预测(NSP)目标:掌握句子流

BERT不仅理解单词;它掌握句子的流程。在NSP目标中,BERT被训练来预测一个句子是否跟随另一个句子。这帮助BERT理解句子之间的逻辑联系,使其成为理解和处理段落和更长文本的大师。

示例:预训练和MLM

from transformers import BertForMaskedLM, BertTokenizer

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForMaskedLM.from_pretrained('bert-base-uncased')

text = "BERT is a powerful language model."

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True, add_special_tokens=True)

outputs = model(**inputs, labels=inputs['input_ids'])

loss = outputs.loss

print(loss)

这段代码演示了BERT的掩码语言模型(MLM)的预训练。模型在训练过程中预测掩码单词,同时最小化预测误差。

BERT的训练过程就像通过填空和句子对理解练习来教它语言规则。在下一章中,我们将深入探讨BERT的嵌入,以及它们如何为其语言能力做出贡献。继续学习!

第6章:BERT嵌入

BERT的力量在于它能够以捕捉特定上下文中单词意义的方式表示单词。在本章中,我们将揭示BERT的嵌入,包括其上下文词嵌入、WordPiece分词和位置编码。

词嵌入与上下文词嵌入

将词嵌入想象成单词的代码词。BERT通过上下文词嵌入更进一步。与每个单词只有一个代码词不同,BERT根据单词在句子中的上下文创建不同的嵌入。这样,每个单词的表示更加细致,并受周围单词的影响。

WordPiece分词:处理复杂词汇

BERT的词汇就像由称为子词的小块组成的拼图。它使用WordPiece分词将单词分解成这些子词。这对于处理长而复杂的单词以及处理BERT以前未见过的单词特别有用。

位置编码:导航句子结构

由于BERT以双向方式读取单词,它需要知道句子中每个单词的位置。位置编码被添加到嵌入中,以给BERT这种空间意识。这样,BERT不仅知道单词的含义,还知道它们在句子中的位置。

代码片段:使用Hugging Face Transformers提取词嵌入

from transformers import BertTokenizer, BertModel

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

text = "BERT embeddings are fascinating."

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True, add_special_tokens=True)

outputs = model(**inputs)

word_embeddings = outputs.last_hidden_state

print(word_embeddings)

这段代码展示了如何使用 Hugging Face Transformers 提取词嵌入。模型为输入文本中的每个单词生成上下文嵌入。

BERT 的嵌入就像一个语言游乐场,单词在其中获得了基于上下文的独特身份。在下一章中,我们将探索微调 BERT 和将其适应于各种任务的高级技巧。继续学习并实验吧!

第7章:BERT 的高级技巧

随着你对 BERT 的熟练掌握,是时候探索能够最大化其潜力的高级技巧了。在本章中,我们将深入探讨微调策略、处理词汇表外单词、领域适应以及从 BERT 中进行知识蒸馏的策略。

微调策略:掌握适应性

微调 BERT 需要仔细考虑。你不仅可以微调最终的分类层,还可以微调中间层。这使得 BERT 能更有效地适应你的特定任务。尝试不同的层和学习率,找到最佳组合。

处理词汇表外(OOV)单词:驯服未知

BERT 的词汇量并非无限,因此它可能会遇到不认识的单词。处理 OOV 单词时,可以使用 WordPiece 分词法将其拆分为子词。或者,可以用特殊标记(如“[UNK]”)替换它们。平衡 OOV 策略是一项随着实践而提高的技能。

BERT 的领域适应:让 BERT 成为你的

尽管 BERT 强大,但在每个领域中可能不会表现最佳。领域适应涉及在特定领域的数据上微调 BERT。通过让 BERT 接触领域特定的文本,它学会了理解该领域的独特语言模式。这可以大大提高其在专业任务中的性能。

从 BERT 进行知识蒸馏:传递智慧

知识蒸馏涉及训练一个较小的模型(学生)来模仿较大的预训练模型(教师)如 BERT 的行为。这个紧凑模型不仅学习教师的预测,还学习其信心和推理。这种方法在资源受限的设备上部署 BERT 时特别有用。

代码片段:使用 Hugging Face Transformers 微调中间层

from transformers import BertForSequenceClassification, BertTokenizer

import torchtokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

text = "Advanced fine-tuning with BERT."

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs, output_hidden_states=True)

intermediate_layer = outputs.hidden_states[6] # 第7层

print(intermediate_layer)

这段代码展示了如何使用 Hugging Face Transformers 微调 BERT 的中间层。提取中间层可以帮助更有效地微调 BERT 以适应特定任务。

随着你探索这些高级技巧,你正在逐步掌握 BERT 的适应性和潜力。在下一章中,我们将深入探讨 BERT 的最新发展和变体,这些进一步提升了 NLP 领域。保持好奇心,继续创新!

第8章:最新发展和变体

随着自然语言处理(NLP)领域的发展,BERT 也在不断进化。在本章中,我们将探索最近的发展和变体,这些使 BERT 的能力更上一层楼,包括 RoBERTa、ALBERT、DistilBERT 和 ELECTRA。

RoBERTa:超越 BERT 的基础

RoBERTa 就像是 BERT 的聪明兄弟。它采用更彻底的训练方法,包括更大的批次、更多的数据和更多的训练步骤。这种增强的训练方案使得 RoBERTa 在各种任务中具有更好的语言理解和性能。

ALBERT:轻量级 BERT

ALBERT 代表“A Lite BERT”。它旨在高效,使用参数共享技术来减少内存消耗。尽管体积较小,ALBERT 仍保持了 BERT 的强大功能,在资源有限时特别有用。

DistilBERT:紧凑而知识丰富

DistilBERT 是 BERT 的蒸馏版本。它被训练来模仿 BERT 的行为,但参数较少。这使得 DistilBERT 更轻巧、更快,同时仍保留了 BERT 性能的大部分。在速度和效率至关重要的应用中,这是一个很好的选择。

ELECTRA:高效学习 BERT

ELECTRA 引入了有趣的训练方式。它不是预测被屏蔽的单词,而是通过识别替换的单词是真实还是人工生成的来进行训练。这种高效的方法使得 ELECTRA 成为训练大型模型而不需要全部计算成本的有前景的方法。

代码片段:使用 RoBERTa 和 Hugging Face Transformers

from transformers import RobertaTokenizer, RobertaModel

import torchtokenizer = RobertaTokenizer.from_pretrained('roberta-base')

model = RobertaModel.from_pretrained('roberta-base')

text = "RoBERTa is an advanced variant of BERT."

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs)

embeddings = outputs.last_hidden_state

print(embeddings)

这段代码展示了如何使用 RoBERTa,一个 BERT 的变体,通过 Hugging Face Transformers 生成上下文嵌入。

这些最新发展和变体展示了 BERT 的影响如何波及 NLP 领域,激发了新的和增强的模型。在下一章中,我们将探索 BERT 如何用于序列到序列任务,如文本摘要和语言翻译。敬请期待 BERT 更多令人兴奋的应用!

第9章:BERT 用于序列到序列任务

在本章中,我们将探索 BERT 如何适应更复杂的序列到序列任务。我们将深入探讨文本摘要、语言翻译,甚至它在对话式 AI 中的潜力。

BERT 用于文本摘要:浓缩信息

文本摘要涉及将较长文本的精髓提炼成较短的版本,同时保留其核心意义。尽管 BERT 并非专为此设计,但它仍可以通过提供上下文理解来有效地使用原始文本生成简明摘要。

BERT 用于语言翻译:弥合语言鸿沟

语言翻译涉及将文本从一种语言转换为另一种语言。虽然 BERT 本身不是翻译模型,但其上下文嵌入可以提高翻译模型的质量。通过理解单词的上下文,BERT 可以帮助在翻译过程中保留原文的细微差别。

BERT 在对话式 AI 中的应用:理解对话

对话式 AI 需要理解不仅仅是单个句子,还有对话的流程。BERT 的双向上下文在这里派上用场。它可以分析并生成上下文一致的响应,使其成为创建更吸引人的聊天机器人和虚拟助手的宝贵工具。

代码片段:使用 BERT 进行文本摘要和 Hugging Face Transformers

from transformers import BertTokenizer, BertForSequenceClassification

import torchtokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

original_text = "Long text for summarization..."

inputs = tokenizer(original_text, return_tensors='pt', padding=True, truncation=True)

summary_logits = model(**inputs).logits

summary = tokenizer.decode(torch.argmax(summary_logits, dim=1))

print("Summary:", summary)

这段代码展示了如何使用 BERT 进行文本摘要,通过 Hugging Face Transformers 生成输入文本的最相关部分。

随着你探索 BERT 在序列到序列任务中的能力,你将发现其适应各种应用的能力超出了其原始设计。在下一章中,我们将解决使用 BERT 时的常见挑战以及如何有效应对。敬请期待 BERT 项目中克服障碍的见解!

第10章:常见挑战与缓解措施

尽管 BERT 功能强大,但它并非没有挑战。在本章中,我们将深入探讨在使用 BERT 时可能遇到的一些常见问题,并提供克服它们的策略。从处理长文本到管理计算资源,我们为你提供全面指导。

挑战1:处理长文本

BERT 对输入有最大标记限制,长文本可能会被截断。为了缓解这个问题,你可以将文本分成可管理的块并分别处理。你需要仔细管理这些块之间的上下文,以确保有意义的结果。

代码片段:使用 BERT 处理长文本

max_seq_length = 512 # BERT 的最大标记限制

text = "Long text to be handled..."

text_chunks = [text[i:i + max_seq_length] for i in range(0, len(text), max_seq_length)]for chunk in text_chunks:

inputs = tokenizer(chunk, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs)

# 处理每个块的输出

挑战2:资源密集型计算

BERT 模型,尤其是较大的模型,可能会计算密集。为了解决这个问题,你可以使用混合精度训练,这减少了内存消耗并加快了训练速度。此外,你可能考虑使用较小的模型或云资源来处理繁重的任务。

代码片段:使用 BERT 进行混合精度训练

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

with autocast():

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs)

loss = outputs.loss

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

挑战 3:领域适应

虽然 BERT 具有通用性,但在某些领域可能无法达到最佳性能。为了解决这个问题,可以在特定领域的数据上对 BERT 进行微调。通过让它接触目标领域的文本,BERT 将学会理解该领域的细微差别和术语。

代码片段:使用 BERT 进行领域适应

domain_data = load_domain_specific_data() # 加载特定领域的数据集

domain_model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

train_domain(domain_model, domain_data)

应对这些挑战可以确保你能够有效地利用 BERT 的能力,无论遇到何种复杂情况。在最后一章中,我们将回顾这一旅程并探讨语言模型领域的潜在未来发展。继续推动 BERT 所能实现的边界!

第 11 章:BERT 在 NLP 中的未来方向

随着我们对 BERT 的探索结束,让我们展望未来,一窥自然语言处理(NLP)即将迎来的激动人心的方向。从多语言理解到跨模态学习,以下是一些有望塑造 NLP 格局的趋势。

多语言和跨语言理解

BERT 的力量不仅限于英语。研究人员正在将其扩展到多种语言。通过在多种语言上训练 BERT,我们可以增强其在不同语言中理解和生成文本的能力。

代码片段:使用 Hugging Face Transformers 的多语言 BERT

from transformers import BertTokenizer, BertModel

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-multilingual-cased')

model = BertModel.from_pretrained('bert-base-multilingual-cased')

text = "BERT 理解多种语言!"

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs)

embeddings = outputs.last_hidden_state

print(embeddings)

跨模态学习:超越文本

BERT 的上下文理解不仅限于文本。新兴研究正在探索将其应用于其他形式的数据,如图像和音频。这种跨模态学习有望通过连接来自多个来源的信息来获得更深入的洞察。

终身学习:适应变化

BERT 的当前训练涉及静态数据集,但未来的 NLP 模型可能会适应不断变化的语言趋势。终身学习模型持续更新其知识,确保随着语言和上下文的演变保持相关性。

代码片段:使用 BERT 进行终身学习

from transformers import BertForSequenceClassification, BertTokenizer

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

new_data = load_latest_data() # 加载更新后的数据集

for epoch in range(epochs):

train_lifelong(model, new_data)

聊天机器人的量子飞跃:更人性化的对话

NLP 模型如 GPT-3 的进步已经展示了与 AI 进行更自然对话的潜力。未来,随着 BERT 对上下文和对话理解的持续改进,我们将看到更加逼真的交互。

NLP 的未来是一幅创新和可能性的织锦。当你拥抱这些趋势时,请记住 BERT 作为语言理解基石的遗产将继续塑造我们与技术及彼此互动的方式。保持好奇心,探索前方的新领域!

第 12 章:使用 Hugging Face Transformers 库实现 BERT

现在你已经对 BERT 有了扎实的理解,是时候将你的知识付诸实践了。在本章中,我们将深入探讨使用 Hugging Face Transformers 库进行实际实现,这是一个强大的工具包,用于处理 BERT 和其他基于 Transformer 的模型。

安装 Hugging Face Transformers

首先,你需要安装 Hugging Face Transformers 库。打开你的终端或命令提示符并使用以下命令:

pip install transformers

加载预训练的 BERT 模型

Hugging Face Transformers 使得加载预训练的 BERT 模型变得容易。你可以从各种模型大小和配置中进行选择。让我们加载一个用于文本分类的基本 BERT 模型:

from transformers import BertForSequenceClassification, BertTokenizer

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

文本的标记化和编码

BERT 以标记化的形式处理文本。你需要使用 tokenizer 对文本进行标记化并为其编码:

text = "BERT 太神奇了!"

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

进行预测

一旦你编码了文本,就可以使用模型进行预测。例如,让我们进行情感分析:

outputs = model(**inputs)

predicted_class = torch.argmax(outputs.logits).item()

print("预测的情感类别:", predicted_class)

微调 BERT

针对特定任务微调 BERT 涉及加载预训练模型,将其适应你的任务并在你的数据集上进行训练。以下是一个简化的文本分类示例:

from transformers import BertForSequenceClassification, BertTokenizer, AdamW

import torch

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

text = "用于训练的示例文本。"

label = 1 # 假设为正面情感

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = model(**inputs, labels=torch.tensor([label]))

loss = outputs.loss

optimizer = AdamW(model.parameters(), lr=1e-5)

loss.backward()

optimizer.step()

探索更多任务和模型

Hugging Face Transformers 库提供了广泛的模型和任务供探索。你可以微调 BERT 进行文本分类、命名实体识别、问答等更多任务。

当你使用 Hugging Face Transformers 库进行实验时,你会发现它是一个在项目中实现 BERT 和其他基于 Transformer 模型的宝贵工具。享受将理论转化为实际应用的旅程!

结论:释放 BERT 的力量

在这篇博文中,我们踏上了一段关于 BERT(Transformer 的双向编码器表示)变革世界的启蒙之旅。从其诞生到实际应用,我们探索了 BERT 对自然语言处理(NLP)及更广泛领域的影响。

我们深入探讨了在现实场景中使用 BERT 所面临的挑战,并揭示了应对诸如处理长文本和管理计算资源等问题的策略。我们对 Hugging Face Transformers 库的探索为你提供了在个人项目中利用 BERT 强大功能的实用工具。

当我们展望未来时,我们瞥见了 NLP 领域无尽的可能性——从多语言理解到跨模态学习,以及语言模型的持续演进。

我们的旅程并未在此结束。BERT 为语言理解的新时代奠定了基础,缩小了机器与人类交流之间的差距。当你踏入动态的 AI 世界时,请记住 BERT 是通向进一步创新的垫脚石。探索更多,学习更多,创造更多,因为技术的边界不断扩展。

感谢你与我们一起探索 BERT。在你继续学习之旅时,愿你的好奇心引导你揭开更大的奥秘,并为 AI 和 NLP 的变革景观做出贡献。

标签:BERT,上下文,NLP,text,模型,单词,初学者,文本 From: https://www.cnblogs.com/IcyFeather/p/18291576