过去10年AI的算力增加了100万倍,未来10年,英伟达还会把深度学习的计算能力再提高100万倍,让AI计算设备不断训练、推理、学习、应用,并持续改进,未来不断将超级 AI 转变为现实,NVIDIA英伟达CEO黄仁勋表示,未来不断推动技术进步,将计算的边际成本降低到接近零,让更多人使用上AI算力。

当前的计算方式是基于信息的检索,所有的文字、视频、声音都是由某个人编写和创建的,基本上是预先录制的。每次用户触摸手机,都有人为之编写并存储在一个位置。所有的模态都是事先录制好的。未来,随着AI能够实事接入全球最新新闻等信息,这种基于检索的方式将变得更加普遍。

这意味着AI将理解问题的上下文,从而生成准确的信息。当用户咨询经济时,用户可能说的并不是完全的一件事情,这时候AI就能根据上下文为用户提供正确的信息。这就是计算高度依赖生成的能力,也叫做生成式人工智能AIGC。

今天,所有内容都是预先录制的,但未来几乎所有内容都将是生成式。这将改变未来的计算形态,这也是英伟达计算的推理方式。

目前无论是使用ChatGPT、Co-pilot、Service Now、Mid-Journey还是Adobe的Firefly,背后几乎都是基于NVIDIA的GPU进行推理,几乎所有的推理都需要用到NVIDIA 显卡。

这意味着AI将理解问题的上下文,从而生成准确的信息。当用户咨询经济时,用户可能说的并不是完全的一件事情,这时候AI就能根据上下文为用户提供正确的信息。这就是计算高度依赖生成的能力,也叫做生成式人工智能AIGC。

今天,所有内容都是预先录制的,但未来几乎所有内容都将是生成式。这将改变未来的计算形态,这也是英伟达计算的推理方式。

目前无论是使用ChatGPT、Co-pilot、Service Now、Mid-Journey还是Adobe的Firefly,背后几乎都是基于NVIDIA的GPU进行推理,几乎所有的推理都需要用到NVIDIA 显卡。

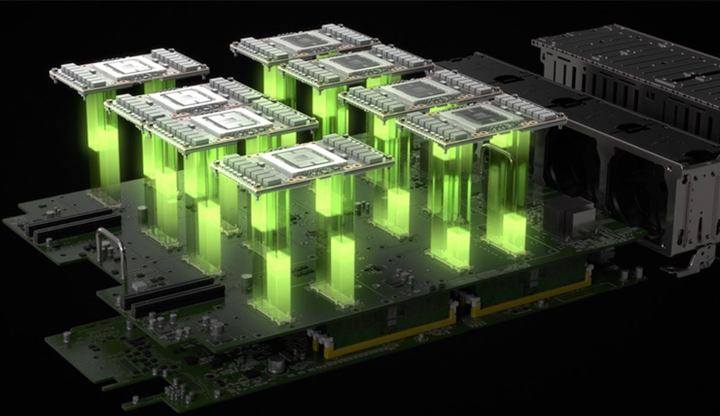

NVIDIA H100 GPU作为目前超高性能著称的算力,内存速度非常快,能够进行高性能计算和大规模数据处理,从而降低运行推理和训练任务的时间成本。尤其在训练能力上面,更多数量的H100 GPU能更好地拓展并提供更快的训练速度,方便快速启动训练和改进模型。

但如果只考虑推理任务的话,RTX 4090服务器更具性价比。

4090服务器在性能上并不差,在大多数推理任务上完全足够,而且4090服务器的价格相对较低。英智未来目前推出8卡4090服务器,256G整机租赁价格在1.3万元/月,需要快速推理和分析应用程序,4090 GPU租赁是一个不错的选择。

NVIDIA H100 GPU作为目前超高性能著称的算力,内存速度非常快,能够进行高性能计算和大规模数据处理,从而降低运行推理和训练任务的时间成本。尤其在训练能力上面,更多数量的H100 GPU能更好地拓展并提供更快的训练速度,方便快速启动训练和改进模型。

但如果只考虑推理任务的话,RTX 4090服务器更具性价比。

4090服务器在性能上并不差,在大多数推理任务上完全足够,而且4090服务器的价格相对较低。英智未来目前推出8卡4090服务器,256G整机租赁价格在1.3万元/月,需要快速推理和分析应用程序,4090 GPU租赁是一个不错的选择。

英智未来推出的BayStone.ai平台,聚集全球不同规格的先进GPU服务器,包括H100、4090、A800等,以调度租赁的方式提供给企业使用,满足企业不同阶段不同任务的使用需求,即租即用!

英智未来推出的BayStone.ai平台,聚集全球不同规格的先进GPU服务器,包括H100、4090、A800等,以调度租赁的方式提供给企业使用,满足企业不同阶段不同任务的使用需求,即租即用!