2024.3.10 Word2Vec+下游任务

word2vec

也是一种神经网络语言模型---->主要目的就是为了得到词向量

这类神经网络模型主要分为两个小类

CBOW 和 Skip-gram

CBOW

主要作用:给出一个词的上下文,得到一个词

Skip-gram

主要作用:给出一个词,得到词的上下文

NNLM和Word2Vec的区别

NNLM----->重点是预测下一个词。主要是双层感知机softmax(w2(tanh(w1(xQ)+b1))+b2)

Word2Vec----->CBOW和Skip-gram的两种架构的重点都是得到一个Q矩阵。softmax(w1(xQ)+b1)

1.CBOW:一个老师告诉多个学生,Q矩阵怎么变

2.Skip:多个老师告诉一个学生,Q矩阵怎么变

Word2Vec的缺点

得到的词向量不能实现一词多义的功能

ELMO:可以解决一词多义

下游任务

Word2Vec模型是不是预训练模型?------>是

什么是预训练?

给出两个任务A和B,任务A已经做出了模型A,任务B无法解决(可以通过使用模型A,加快任务的解决)

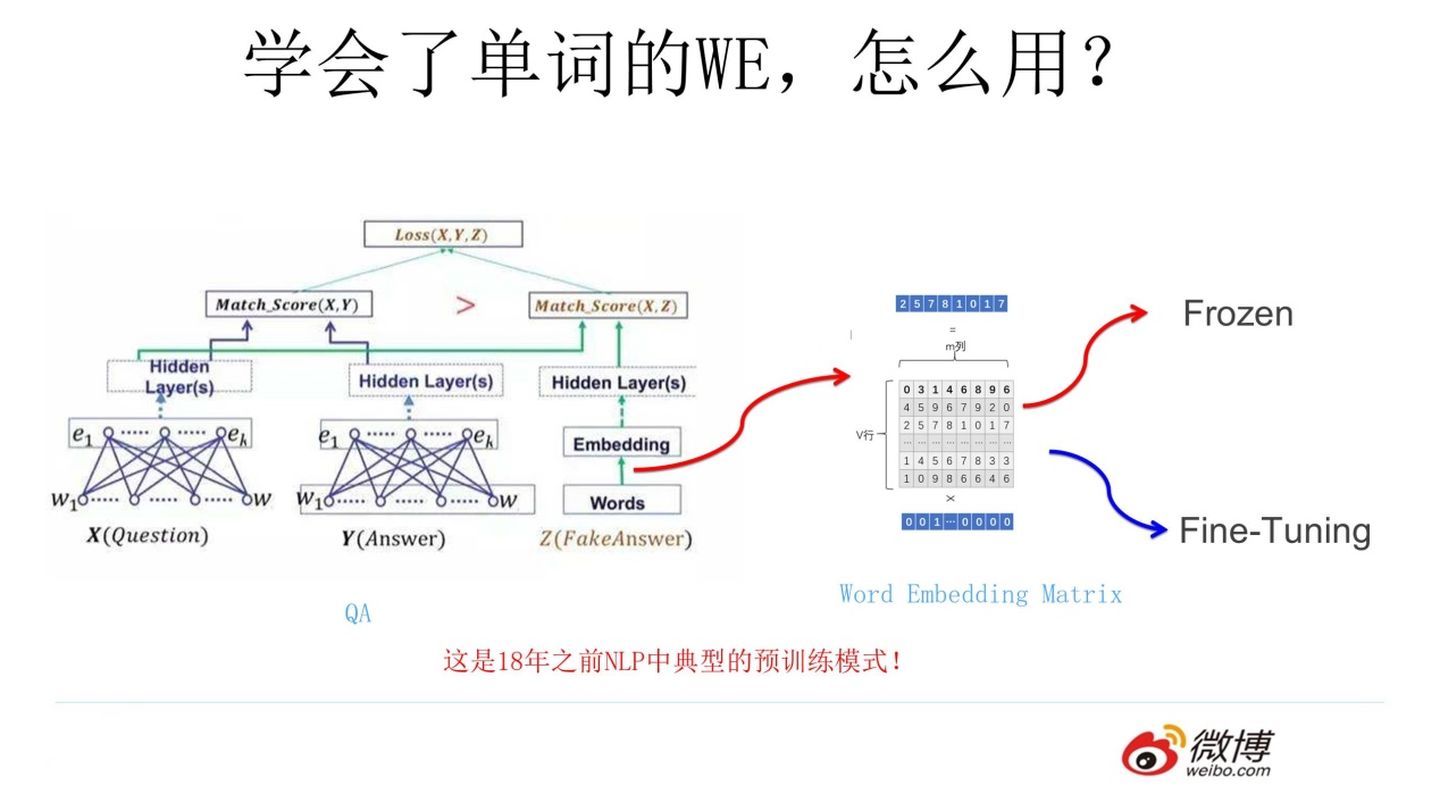

例如:给你一个NLP(自然语言处理)里面的任务,给出一个问题X(Ni+ck),给出一个回答Y(handsome)

预训练语言模型终于出来了(给出一句话,我们使用独热编码(一一对应的一种表查询,不算预训练),再使用Word2Vec预训练好的Q矩阵直接得到词向量,然后进行接下来的任务)

1.冻结:可以不改变Q矩阵

2.微调:随着任务的改变,改变Q矩阵

标签:Word2Vec,Skip,模型,矩阵,任务,CBOW,下游 From: https://www.cnblogs.com/adam-yyds/p/18064789