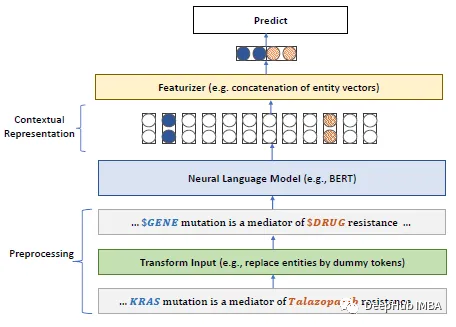

今年大语言模型的快速发展导致像BERT这样的模型都可以称作“小”模型了。Kaggle LLM比赛LLM Science Exam 的第四名就只用了deberta,这可以说是一个非常好的成绩了。所以说在特定的领域或者需求中,大语言模型并不一定就是最优的解决方案,“小”模型也有一定的用武之地,所以今天我们来介绍PubMedBERT,它使用特定领域语料库从头开始预训练BERT,这是微软研究院2022年发布在ACM的论文。

论文的主要要点如下:

对于具有大量未标记文本的特定领域,如生物医学,从头开始预训练语言模型比持续预训练通用领域语言模型效果显著。提出了生物医学语言理解与推理基准(BLURB)用于特定领域的预训练。

https://avoid.overfit.cn/post/02c09a271dd246f4b04421794d87c679

标签:训练,模型,领域,PubMedBERT,特定,生物医学,自然语言 From: https://www.cnblogs.com/deephub/p/17858523.html