这是微软在11月最新发布的一篇论文,题为“Everything of Thoughts: Defying the Law of Penrose Triangle for Thought Generation”,介绍了一种名为XOT的提示技术,它增强了像GPT-3和GPT-4这样的大型语言模型(llm)解决复杂问题的潜力。

当前提示技术的局限性

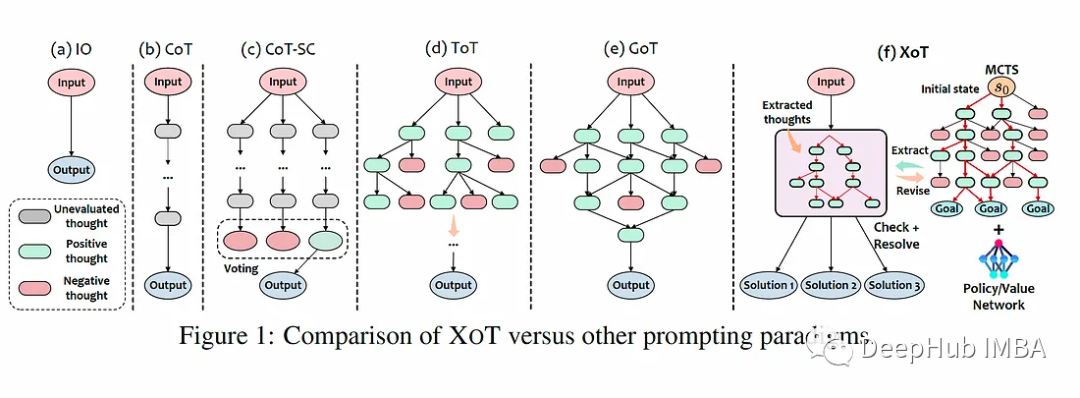

LLM的最新进展通过将复杂的问题分解成更易于管理的“思想”,然后通过自然语言提示表达出来,从而实现了解决问题的新方法。但是大多数现有的提示技术都有局限性:

输入-输出(IO)提示仅适用于具有单步解决方案的简单问题,缺乏灵活性。

思维链(CoT)能够逐步解决问题,但仅限于线性思维结构,限制了灵活性。

思维树(ToT)和思维图(GoT)允许更灵活的思维结构,如树或图。但是它们需要LLM本身来评估中间思想,通过多个LLM调用产生大量的计算成本。

从本质上讲,当前的提示技术面临着“彭罗斯三角”约束——它们最多可以实现两个属性(性能、效率、灵活性),但不能同时实现这三个属性。

https://avoid.overfit.cn/post/491c60ff00884f06adff77b0025e162d

标签:思维,XoT,提示,模型,技术,LLM,GPT From: https://www.cnblogs.com/deephub/p/17826777.html