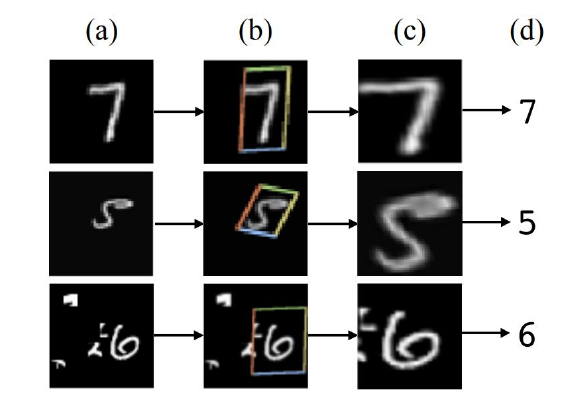

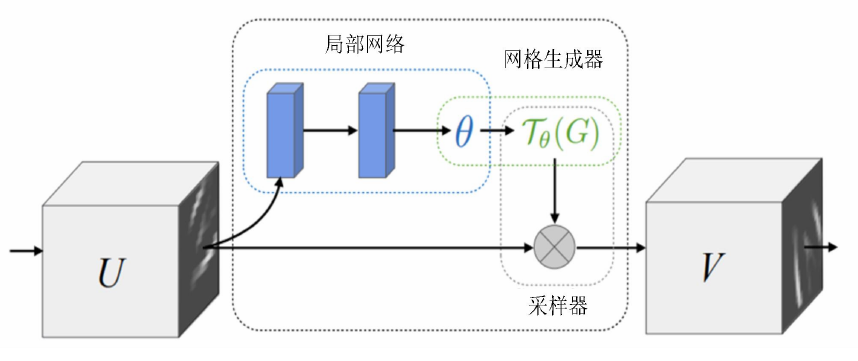

空间注意力机制

针对图片中不同的位置,不同的权重,即对不同位置的图像进行仿射变换,来得到输出以后进行分类。

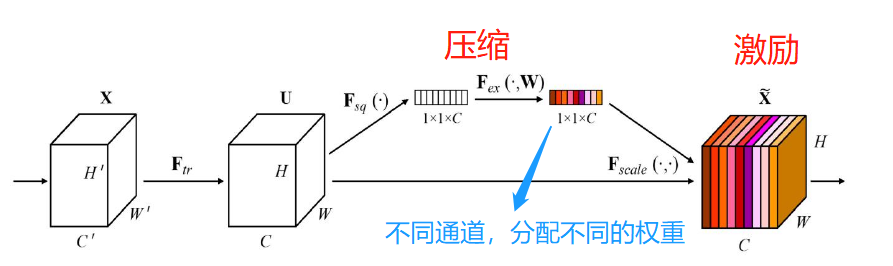

通道注意力机制

首先使用全局池化,将H\times W\times C变为1\times 1\times C,然后每个通道对齐进行权重的调整。

时间注意力机制

在处理序列数据,如时间序列或文本数据时,时间注意力机制使模型能够关注输入序列的特定时间步。

自注意力机制

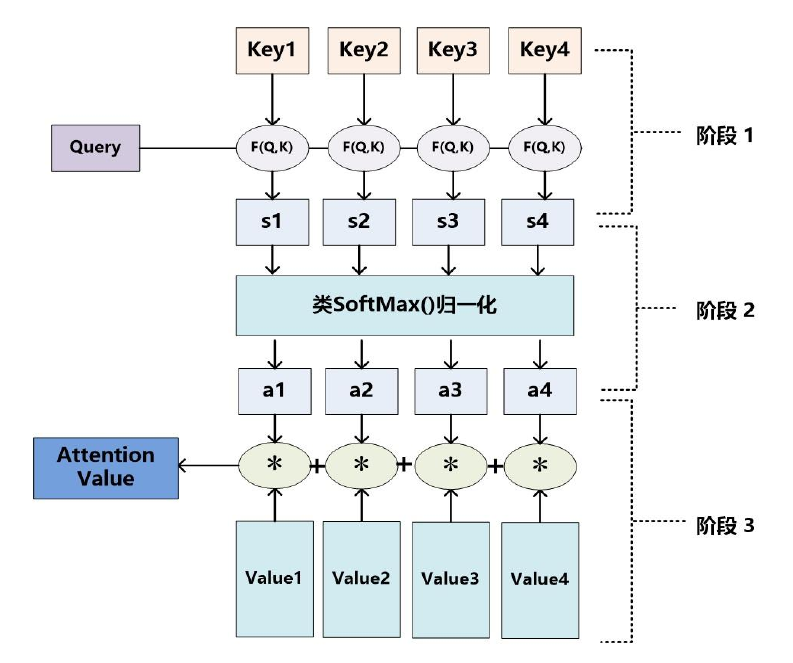

Transformer Attention

首先对Q和K计算不同的注意力分数,随后进行归一化,最后将不同K的注意力分数进行累加,得到最后的注意力分数。

参考:https://guo-pu.blog.csdn.net/article/details/126881984?utm_relevant_index=1

标签:总结,分数,不同,times,序列,机制,注意力 From: https://www.cnblogs.com/KarryChiang/p/17751960.html