说到后期处理板块,大家第一印象就是图像放大,快速且高效。但是今天要讲的后期处理当中,肯定还有一些是你不知道的事儿。

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【

保证100%免费】

# 放大算法

首先是关于放大算法,如果大家用的都是秋叶大佬的整合包的话,算法总共应该就是这些。常用的就是“R-ESRGAN 4x+”做写实图片,“R-ESRGAN 4x+

Anime6B”做二次元图片。

但是经常去C站,copy一些别人的作品却老是发现他们用的放大算法是什么“4x-UltraSharp”之类的高级货。

那就是因为,这些高端的放大算法,你还没下载。

所以,我在这里整理了四款更厉害的放大算法,分别是:“4x-UltraSharp”、“8x_NMKD-

Superscale_150000_G”、“8x_NMKD-

Typescale_175k”、“16xPSNR”。并将它们放在了云盘里,大家下载之后,将这四款放大算法放入“……\sd-webui-

aki-v4.2\models\ESRGAN”这个路径之中,然后重启软件。

就可以看到这四款新的放大算法了。

我们以这张图作为例子来测试一下,这张图片现在分辨率是512*512。

我将这张图发送到后期处理,分别使用一个传统算法“Lanczos”、一个常用算法“R-ESRGAN 4x+ Anime6B”,和刚才下载的四个算法做一个对比。

图片太小,大家可能看不清细节,我直接来做一下总结。

传统放大算法Lanczos对原图没有任何优化,仅仅只是放大像素,直接pass。

曾经的王者“R-ESRGAN 4x+ Anime6B”表现蛮好的,放大之后,图片有了更多的细节和更清晰的轮廓。

但是和新晋放大器“4x-UltraSharp”比起来,还是弱了一些,“4x-UltraSharp”拥有更清晰的细节,而且没有过度锐化的部分。

随着前面数字的增加,8x、16x系列的放大器,拥有了更真实的处理细节,不仅仅只追求把人物还原得光滑好看,而是增加了很多噪点和毛孔细节,让人物看起来更加真实可信。

这四个新算法呢,正常情况下推荐“4x-UltraSharp”效果相当好,“8x_NMKD-

Superscale_150000_G”色调相当偏冷一些,“8x_NMKD-

Typescale_175k”,比4x的放大器皮肤噪点更多,如何取舍就取决于你需要多高的真实度了,至于“16xPSNR”,生图速度有点慢,效果相对于8x而言没有明显提升,不建议使用。

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【

保证100%免费】

# 面部修复

我们接着来看一下这个GFPGAN面部修复,我找一张模糊人像来修复一下。

其他参数不变,直接将GFPGAN参数拉到1,就可以了。

看一下面部修复效果,宛如重生。当然这个功能只能修复脸部,所以头发、衣服、背景等没有变化。

# 背景去除

这个功能需要再安装一个插件REMBG,安装地址是https://github.com/AUTOMATIC1111/stable-diffusion-

webui-rembg.git 。

安装好之后重启,就有这个选项框了。

使用这张图测试一下,模型就选第一个u2net,直接点击生成。

抠图效果还是蛮不错的,边缘轮廓有些黑边,用时2.86秒。

如何去掉这个黑边呢,需要点击后面的Alpha matting,来调整一些参数。它们分别控制抠图边缘尺寸,前景阈值、背景阈值。

通过一系列测试,推荐给大家一套比较通用的参数设置——Erode size:6、Foreground threshold:143、Background

threshold:187。

通过这个参数,我们就能一键得到没有黑边的图像了。

另外,点击这个按钮,还可以直接生成蒙版。

这里还有一个专门做服装抠图的模型,可以一键识别出模特的服装。

这就非常方便我们做换装的处理了。

还有一个专门给动漫抠图的模型。

我们使用这张图测试一下。

抠图效果还是可以的,可能是背景比较复杂,用时19秒。

文章使用的大模型、Lora模型、SD插件、示例图片等,都已经上传到我整理的 Stable Diffusion 绘画资源中。有需要的小伙伴文末扫码自行获取。

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【

保证100%免费】

提示词

Stable Diffusion 最强提示词手册

- Stable Diffusion介绍

- OpenArt介绍

- 提示词(Prompt) 工程介绍

- …

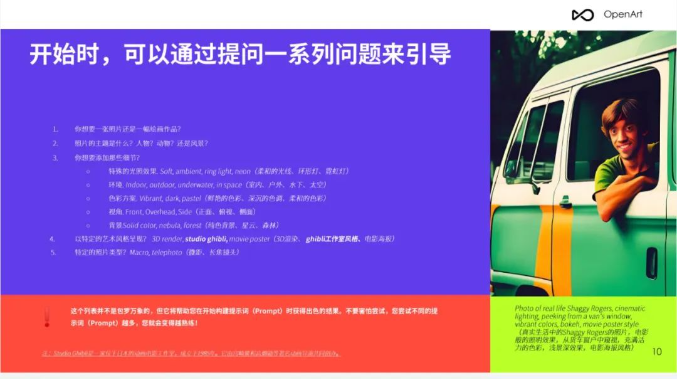

第一章、提示词格式

- 提问引导

- 示例

- 单词的顺序

- …

有需要的朋友,可以点击下方卡片免费领取!

第二章、修饰词(Modifiers)

- Photography/摄影

- Art Mediums/艺术媒介

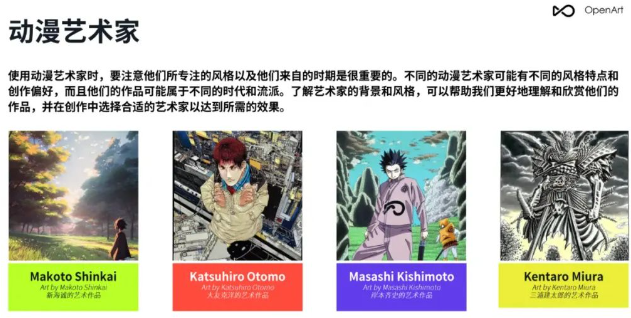

- Artists/艺术家

- Illustration/插图

- Emotions/情感

- Aesthetics/美学

- …

第三章、 Magic words(咒语)

- Highly detailed/高细节

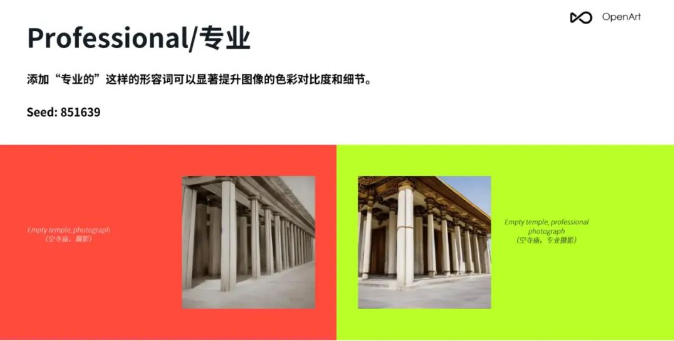

- Professional/专业

- Vivid Colors/鲜艳的颜色

- Bokeh/背景虚化

- Sketch vs Painting/素描 vs 绘画

- …

第四章、Stable Diffusion参数

- Resolution/分辨率

- CFC/提词相关性

- Step count/步数

- Seed/种子

- Sampler/采样

- 反向提示词(Prompt)

第5章 img2img(图生图),in/outpainting(扩展/重绘)

- 将草图转化为专业艺术作品

- 风格转换

- lmg2lmg 变体

- Img2lmg+多个AI问题

- lmg2lmg 低强度变体

- 重绘

- 扩展/裁剪

- …

第6章 重要提示

- 词语的顺序和词语本身一样重要

- 不要忘记常规工具

- 反向提示词(Prompt)

- …

第7章 OpenArt展示

-

提示词 (Prompt)

-

案例展示

-

…

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【

保证100%免费】