引言

随着 AI 技术的飞速发展,图像生成与编辑的门槛不断降低,尤其在人像视频生成领域取得了令人瞩目的成就。快手可灵大模型团队开源的 LivePortrait 框架,以其出色的性能与创新的设计,引领了 AI 生成的新浪潮。LivePortrait 不仅能够将静态图像转换为动态视频,还能精确控制面部细节,如眼睛和嘴唇的运动,实现前所未有的表现力。

突破传统的创新框架

相比当前主流的基于扩散模型的方法,LivePortrait 采用了全新的基于隐式关键点的框架。这样的设计不仅大幅提高了模型的计算效率,还提升了其对生成视频的可控性。通过 69M 高质量的训练帧与视频-图片混合训练策略,LivePortrait 能够更好地泛化,适应各种输入数据。

其核心亮点在于隐式关键点的运用,类似于面部混合变形 (Blendshape) 的有效隐式表示。贴合 (stitching) 和重定向 (retargeting) 模块的引入,更使得生成视频过程中的每一帧都能无缝过渡,确保动作流畅自然,尤其是当驱动多个角色时,模型的表现尤为出色。

性能与可扩展性

在实际应用中,LivePortrait 的速度令人惊艳。即便在 RTX 4090 GPU 上,单帧生成仅需 12.8 毫秒,未来通过 TensorRT 优化,预计能缩短至 10 毫秒以下,这样的速度远超现有的许多基于扩散模型的方案。这使得 LivePortrait 能够用于实时应用场景,如直播、虚拟偶像等领域,满足高效且灵活的需求。

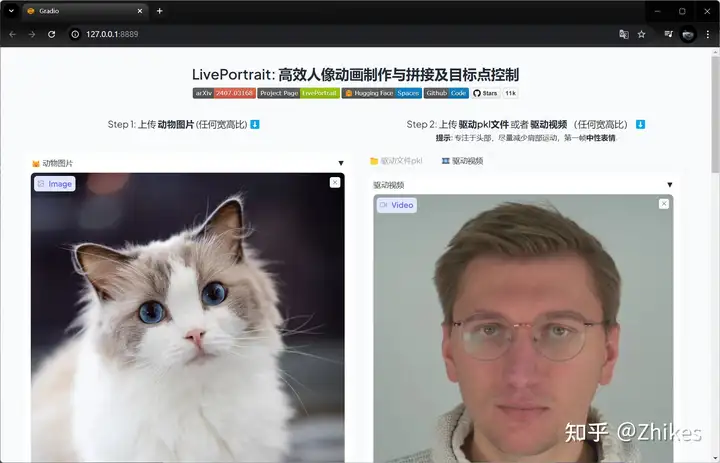

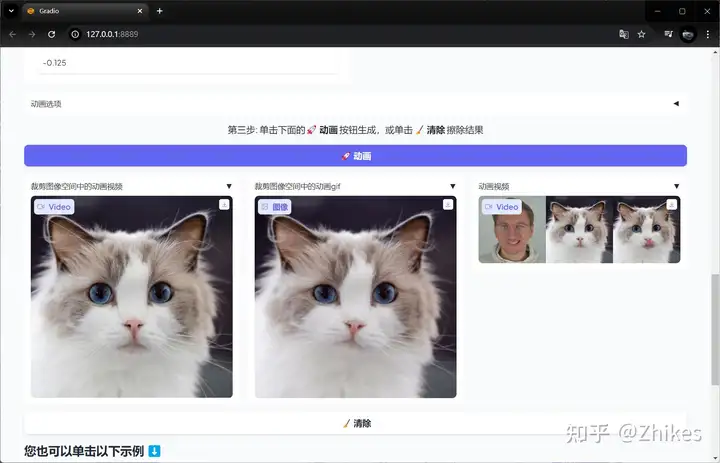

除了生成人像,LivePortrait 还能处理更多复杂场景,如多人合照的无缝动作驱动,甚至可以让动物模仿人类的表情,拓宽了其在娱乐、教育、影视等多个领域的应用空间。

技术架构的双阶段训练

LivePortrait 的训练过程分为两个阶段。第一阶段是基础模型的训练,通过大规模高质量的数据集(如 Voxceleb、MEAD、RAVDESS)进行改进,结合风格化图片数据集的应用,模型在各种输入场景下表现优异。第二阶段则是贴合与重定向模块的训练。通过轻量 MLP 网络,LivePortrait 能够将隐式关键点映射到实际动作中,确保动作的自然过渡和极高的生成控制力。

获取指南

- 一键启动:无需复杂配置,下载后解压直接点击 一键启动.exe,即可启动程序。

- 下载速度取决于您的网速,无需开通会员。

- 公众哪个号嘞 InnoTechX

发送 “LP” 即可获取一键整合包。

前置条件

此一键包用于win10、win11,并且需要配备至少6GB显存及以上的独立 NVIDIA 显卡 可用。cuda版本需要大于等于11.1,如果cuda版本小于11.1,可以按照教程按装指定版本的cuda[--------------]https://www.zhisk.com/1154.html。

cuda版本查询cmd指令

nvcc –version

或:

nvidia-smi

(注意:在 Windows 系统上,某些较高版本的 CUDA(例如 12.4、12.6 等)可能会导致未知问题。您可以考虑将 CUDA 降级到版本 11.8 以确保稳定性。)

使用教程

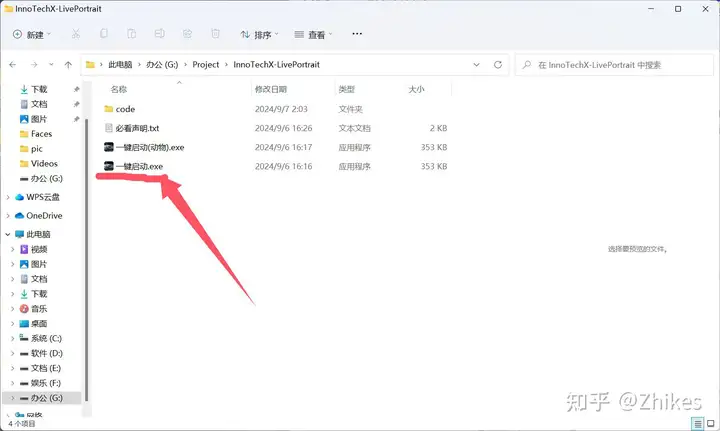

- 下载并解压整合包到本地目录 本地目录(全路径)不要带中文或者特殊符号。

- 进入目录后,点击 一键启动.exe 启动程序。如果是人物图片或者视频,使用一键启动.exe。猫狗动物就用一键启动(动物).exe

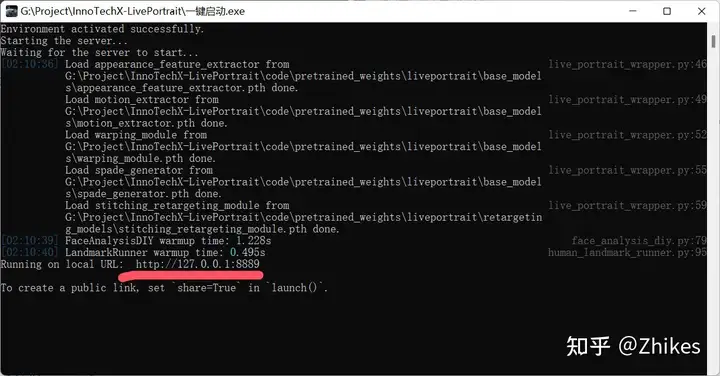

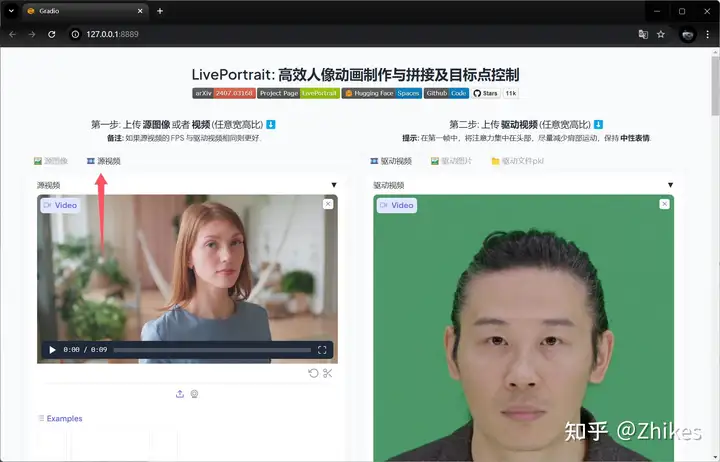

3.注意:程序运行期间,请勿关闭 CMD 命令窗口。点击启动后会自动打开网页跳转到 http://127.0.0.1:8889 没有就自行复制到浏览器打开

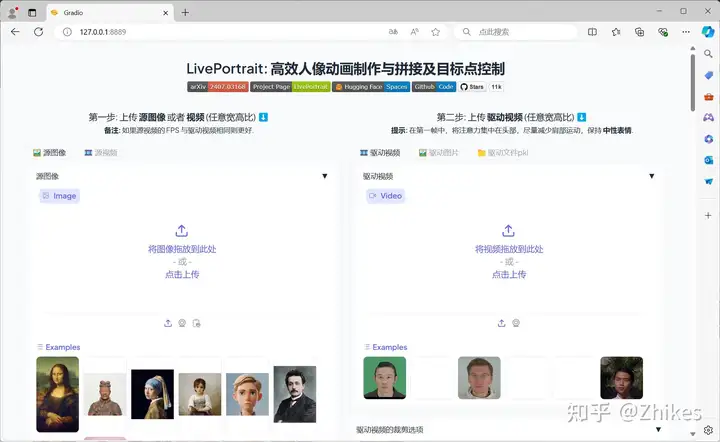

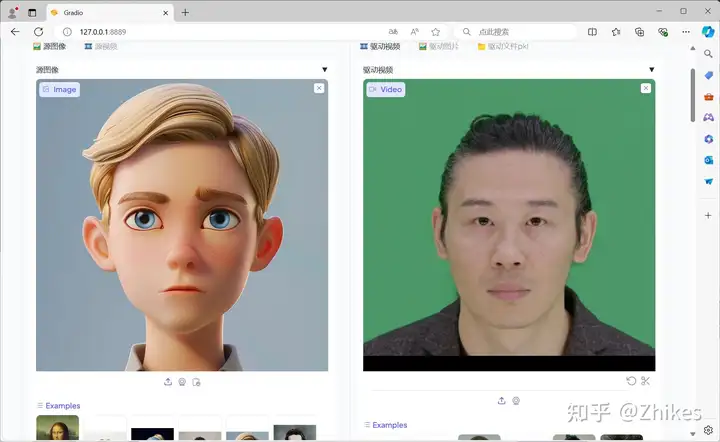

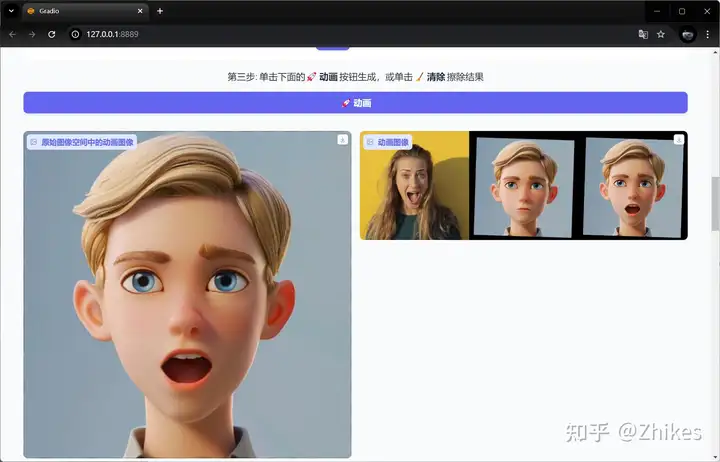

表情驱动

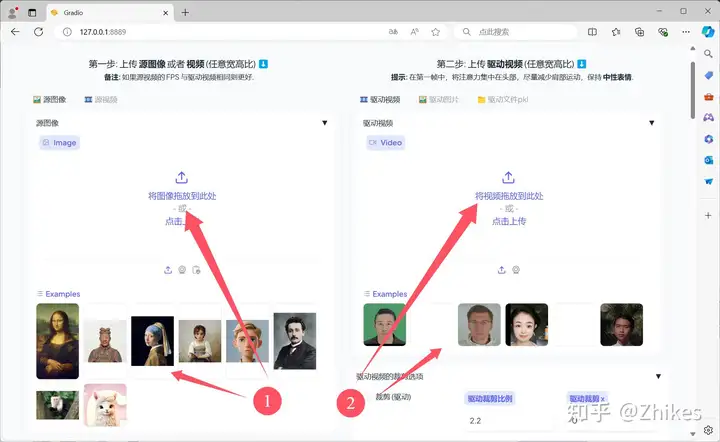

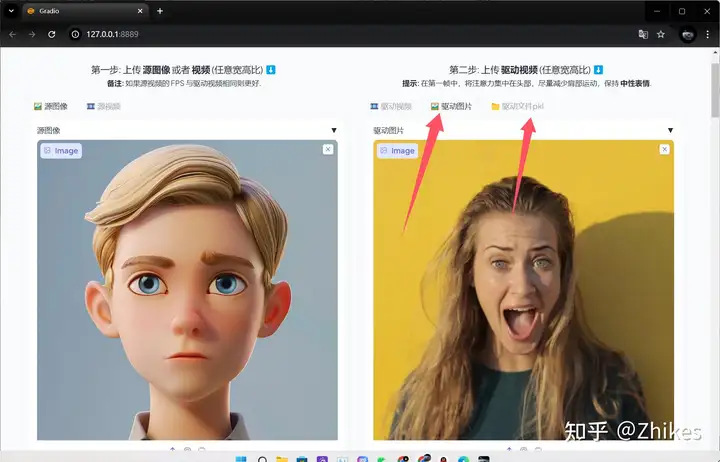

- 1.可以在源图像中把你需要处理的图片表情拖拽进来,也可以点击下面的示例Examples,便于演示,我直接选择下面的Example。

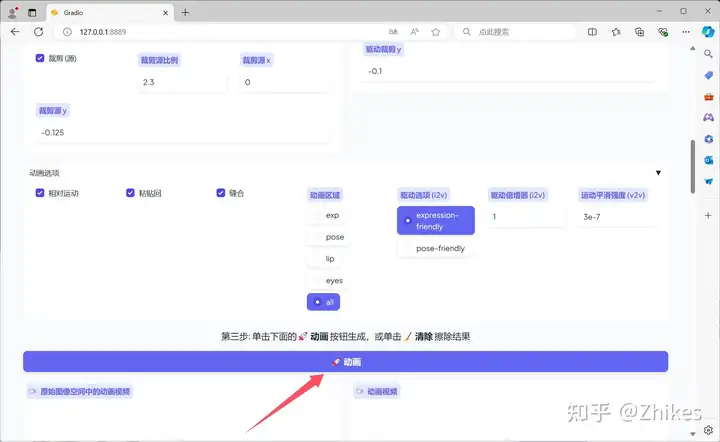

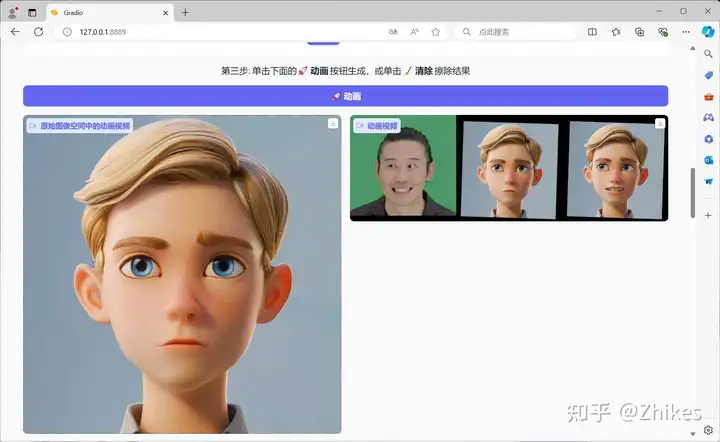

- 2.下拉网页,找到第三步,点击动画,等待程序执行即可,执行结果可以直接在第三步区域下方预览

- 3.你也可以使用驱动图片,和驱动文件pkl去驱动,具体效果自行测试

- 4.视频表情控制和上述操作基本一样,选择源视频上传你的视频即可,需要注意的是,生成的视频长度,以驱动视频的长度为准。

- 5.猫狗动物操作与之前基本一样

快去试试吧,非常好玩儿。

标签:视频,教程,启动,一键,生成,驱动,LivePortrait From: https://www.cnblogs.com/zhikes/p/18404142