onnx 无法使用GPU加速 加速失败 解决方法【非常详细】

应该是自目前以来最详细的加速失败解决方法GPU加速,收集了各方的资料。引用资料见后文

硬件配置:

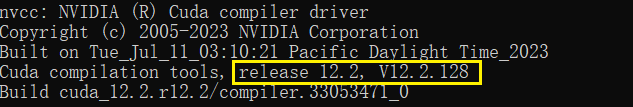

GPU CUDA版本:12.2

客户架构:window10

输入: nvcc --version

onnxruntime版本后文提供

1 先检测是否无法使用GPU加速

检测代码如下,记得把模型换成你模型的地址

import onnxruntime

print(onnxruntime.__version__)

print(onnxruntime.get_device() ) # 如果得到的输出结果是GPU,所以按理说是找到了GPU的

ort_session = onnxruntime.InferenceSession("your_onnx_module_path.onnx",

providers=['CUDAExecutionProvider'])

print(ort_session.get_providers())

explain:

-

如果print(onnxruntime.version)输出成功,应该包就安装成功了

-

如果没有,见后文的

onnxruntime版本匹配

-

-

如果print(onnxruntime.get_device() )输出成功的话,大概率是能够获取到你的gpu了

-

如果没有获取成功的话,则参见后文的配置

cudann

-

-

如果print(ort_session.get_providers()),应该是没什么问题了

-

如果有问题的话,有蛮多情况导致的,我遇到的一个情况与版本有关

-

2.1 版本匹配

我的报错问题就与版本匹配有关,其他全部都是正确的,且这个关系到onnxruntime的包安装,固直接放到2.1来说明,你的硬件版本很重要,我这个是解决cuda12的,如果是cuda11可能不一样,或者也能给你们提供一点灵感也不错。

-

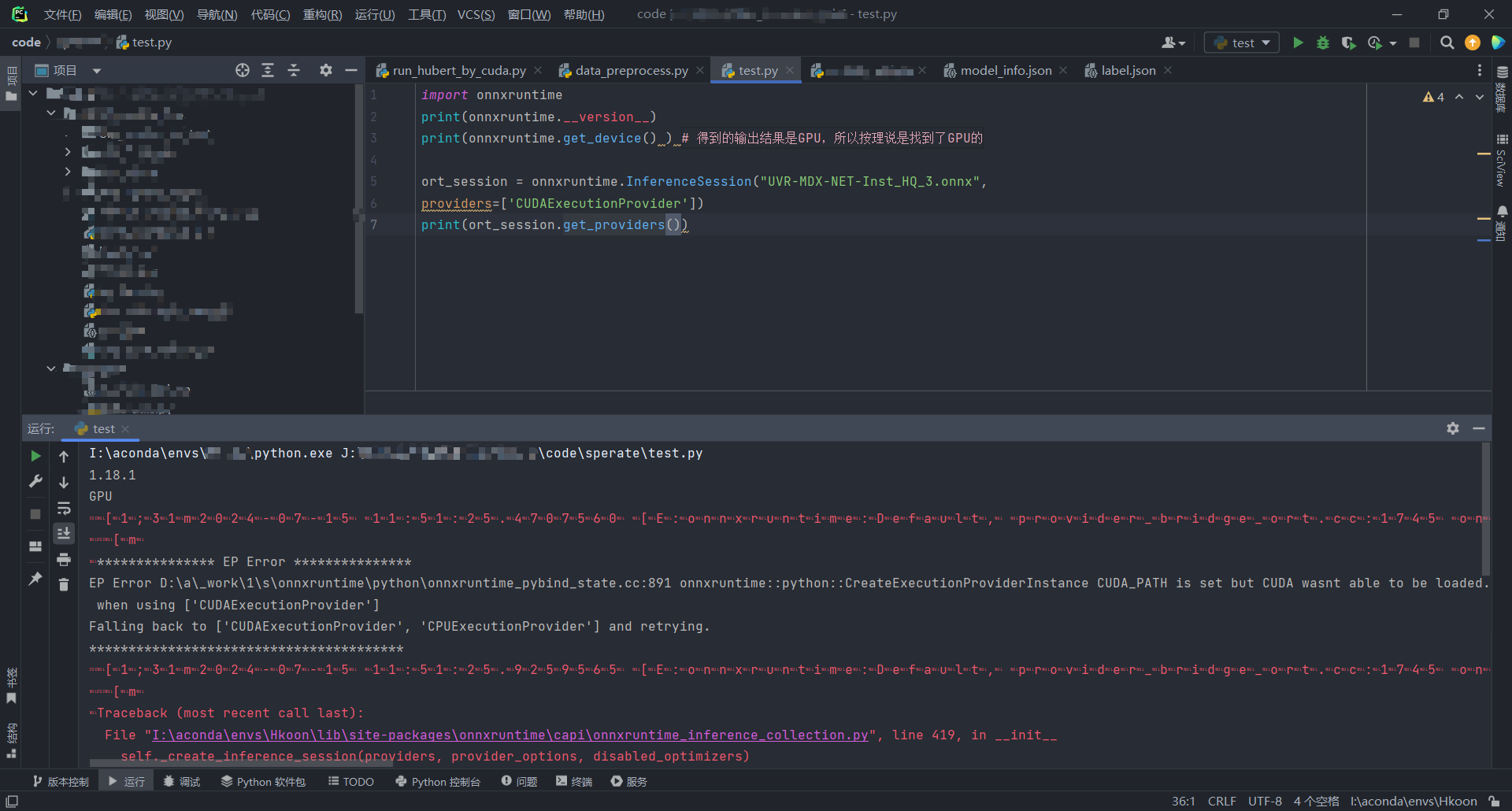

问题描述

报错信息大致是:

CreateExecutionProviderInstance CUDA_PATH is set but CUDA wasn't able to be loaded. Please install the correct version of CUDA andcuDNN as mentioned in the GPU requirements page

翻译出来就是,CUDA_PATH 路径已经设置了,但是 CUDA 不能被读取【也就说理论上环境变量没问题】,但保险起见,各位也可以检查一下你们的环境变量(后文cudann安装说明)

-

问题处理

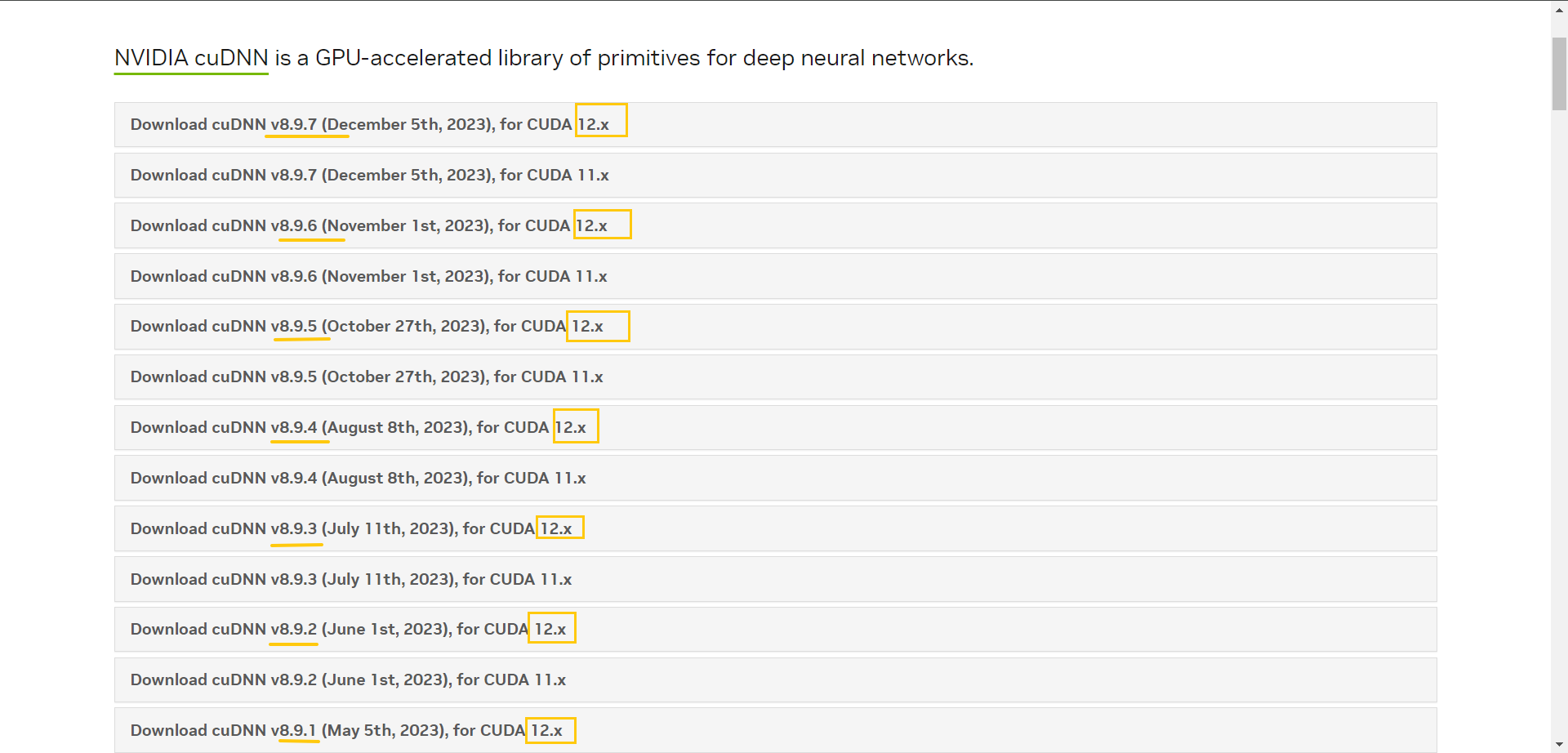

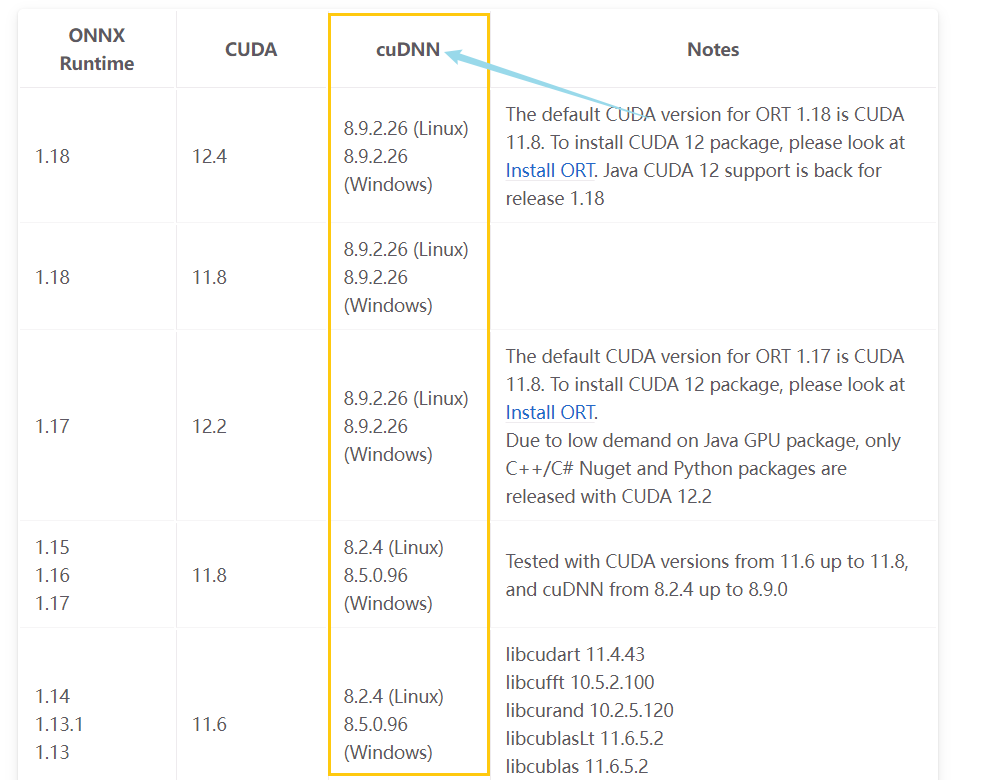

找到官方提供的

onnx与cuda的官方文档

当初没想到这里那么多坑

-

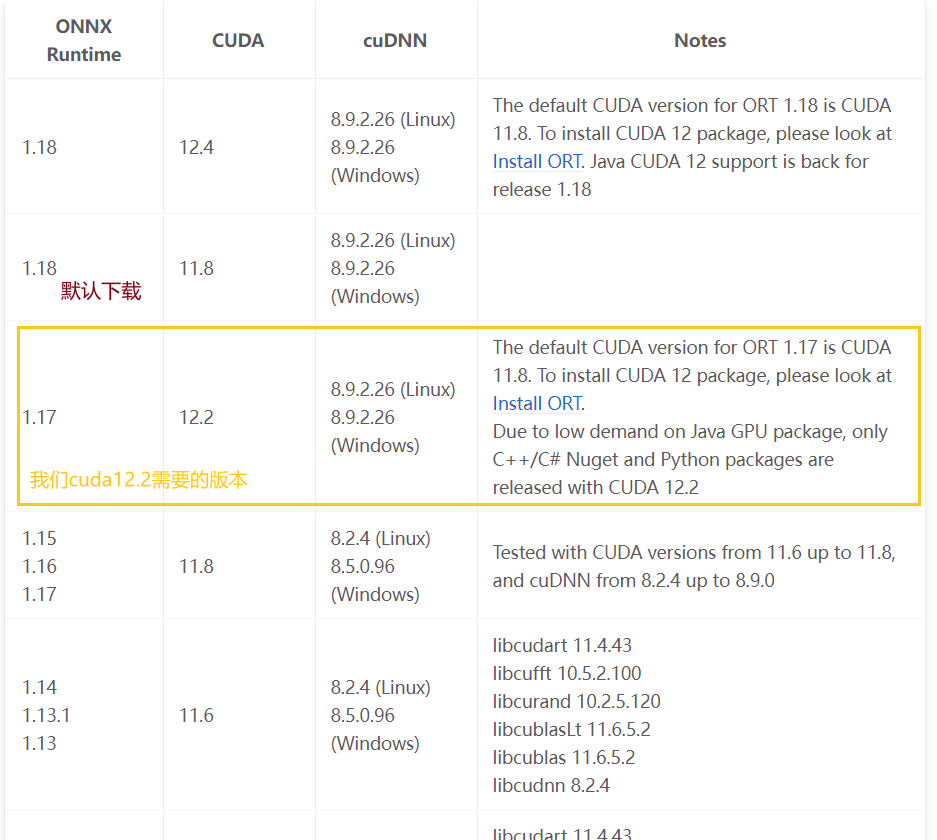

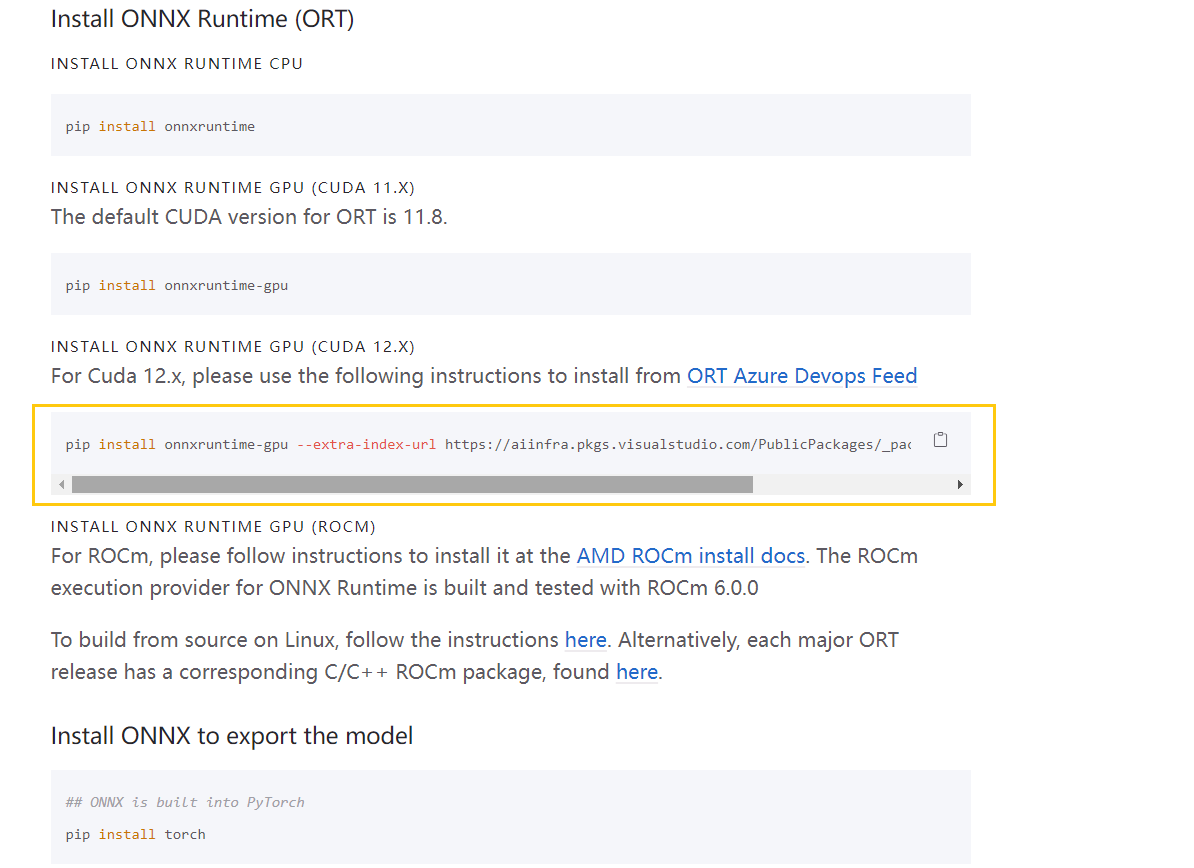

坑1【直接pip安装onnxruntime-gpu】

默认下载的是最新的且是针对11.8的版本,因此你直接

pip install onnxruntime-gpu实际上安装的版本是onnxruntime-gpu=1.18[ 即最新版 ,而且默认是cuda11的] -

坑2【使用官方提供的ort但不指定版本】:

-

点进去官方的对12.x的指示

-

使用官方的命令也会留有后患,因为官方确实是对12.x进行适配了,但默认还是version--1.18,适配cuda12.4,但!他不向下兼容版本,就是说你可能cuda版本是12.2,安装了最新的1.18 ,CUDA版本的12.4就不能使用了,因此需要在安装的时候添加你cuda版本对应的ORT的版本

pip install onnxruntime-gpu==what_you_want_version --extra-index-url https://aiinfra.pkgs.visualstudio.com/PublicPackages/_packaging/onnxruntime-cuda-12/pypi/simple/

-

将

what_you_want_version换成你需要的版本,对应上图。 -

问题解决了,程序有输出了

-

-

-

总结,如果没有遇到上述问题或者cuda版本不是12.x的,也可以对应图片通过pip安装即可,cuda12.x的话就要注意多一点,以免踩坑

2.2 安装cuda nn失败、缺失dll

可以参考这位博主的心路历程:

为什么在使用onnxruntime-gpu下却没有成功调用GPU?

在linux系统上可以参考这位博主:

大致需要排查的是:

-

是否已经安装cuda

-

是否已经将cudaNN对应的库放入cuda的文件中

-

cudaNN版本与cuda版本是否匹配

记得你的cudaNN版本要与ORT【onnxruntime版本匹配】

按照那位博主或者其他博主的教程安装好对应cudaNN就好,90%的用户都是这个模块出问题了

-

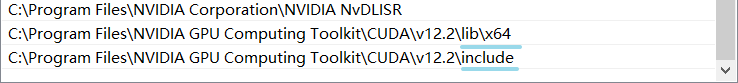

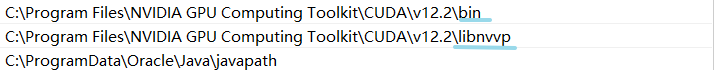

检查你的cuda、cudaNN是否设置环境变量成功

在你开发的虚拟环境中运行如下命令查看ORT需要设置的环境变量是否成功设置【默认应该是ok的】

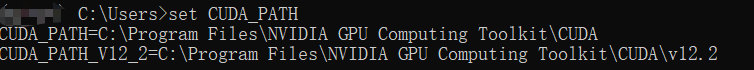

set CUDA_PATH

正常输出如下图所示:

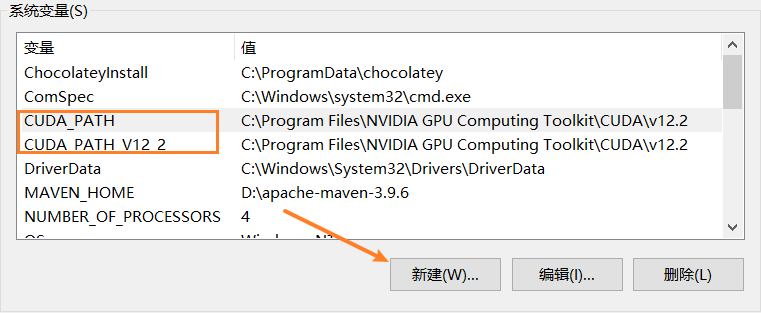

如果没有怎么办?去环境变量里面设置即可

如果没有的话,按照我这个变量新建即可,地址根据自己安装cuda地址填【因为我的cudaNn是嵌入进去的 ,公用一个文件夹】

-

3 疑难杂症

如果上述两个都解决不了你的问题,那确实是少有的疑难杂症了,我抛砖引玉一下吧,但我不是通过这个思路解决的

-

来源于ORT的官方issue:Windows CUDA_PATH 已设置,但 CUDA 无法载入

其中有这样一段话让我围绕了这个思路进行思考:

-

“The

D:\part just points to the source file on a build box, so it had nothing to do with your machine. You might want to check if those CUDA folders are present in thePATHof your Conda environment. Easy way to check is to usewherecommand in CMD.” -

大意就是:第一是检查一下cuda在不在环境变量PATH中,有没有可能在conda环境中无法访问到PATH的路径

-

但这个毕竟不是我解决的方法,如果上面两个问题都无法解决,无妨去看看issue

-

4 参考资料

鸣谢:为什么在使用onnxruntime-gpu下却没有成功调用GPU?,这位大佬的分享让我初期解决这个问题的时候有了一定参考

标签:onnxruntime,CUDA,版本,gpu,GPU,加速,cuda From: https://www.cnblogs.com/io-T-T/p/18304208