长话短说

NVIDIA 拥有数十个 GPU,可以为不同大小的 ML 模型提供服务。但了解这些不同卡的性能和成本(更不用说保持名称正确)是一个挑战。每个 GPU 的名称是一个字母数字标识符,传达有关其架构和规格的信息。本指南可帮助您浏览 NVIDIA 数据中心 GPU 系列并将其映射到您的模型服务需求。

每个人都希望拥有强大、经济高效的硬件来运行生成式 AI 工作负载和 ML 模型推理。但选择数据中心 GPU 并不像走进 Apple 商店挑选一台新笔记本电脑那么简单,那里只有几个选项和明确的升级路径。这更像是购买汽车,您的预算和用例会指导您在具有不同功能、价格和可用性的一系列车型和车型年份中做出决定。

本文首先将指导您解读 NVIDIA 数据中心 GPU 的命名方案,以识别卡的架构和层级。然后,它提供了清晰、直接比较不同 GPU 的方法,以及模型训练、微调和服务中常用的几种卡的关键规格表。

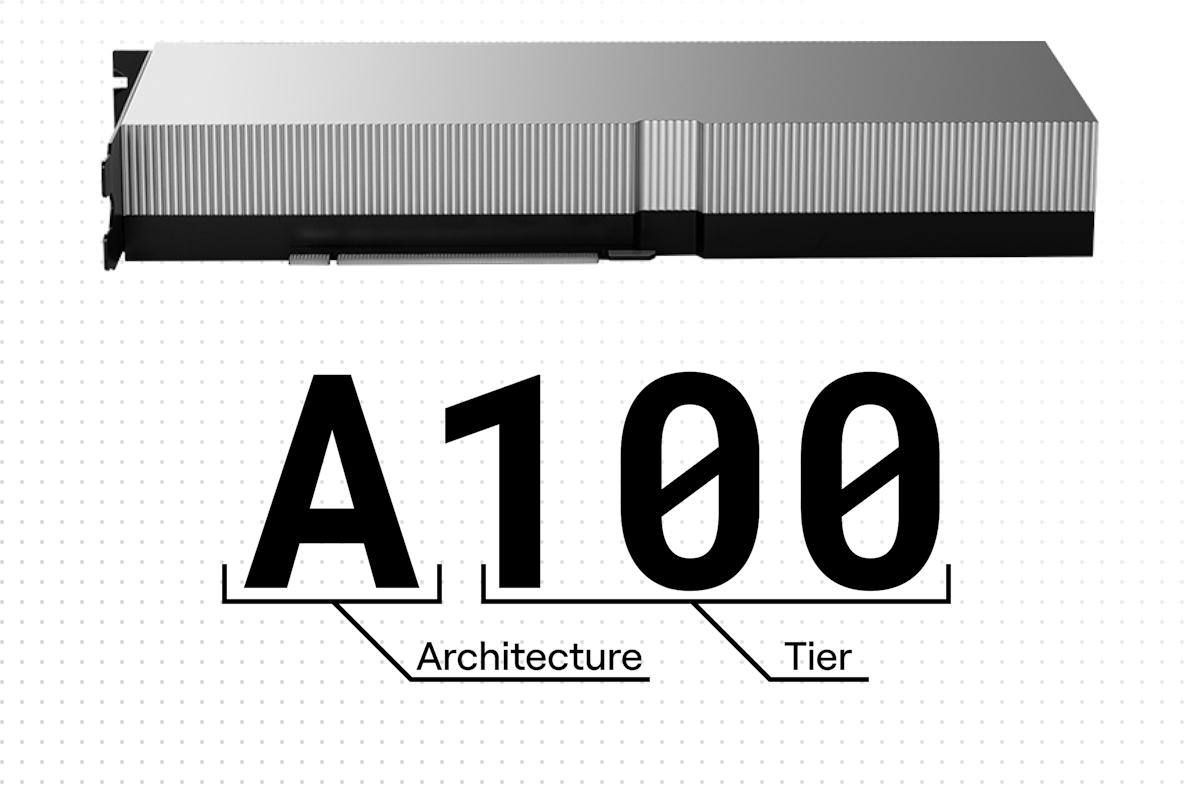

分解 GPU 名称

数据中心 GPU 的名称可能相当晦涩难懂:K80、T4、A100、L40。但这些不仅仅是字母和数字的随机集合。它们对有关 GPU 规格和性能的重要信息进行编码。

信件:卡片架构

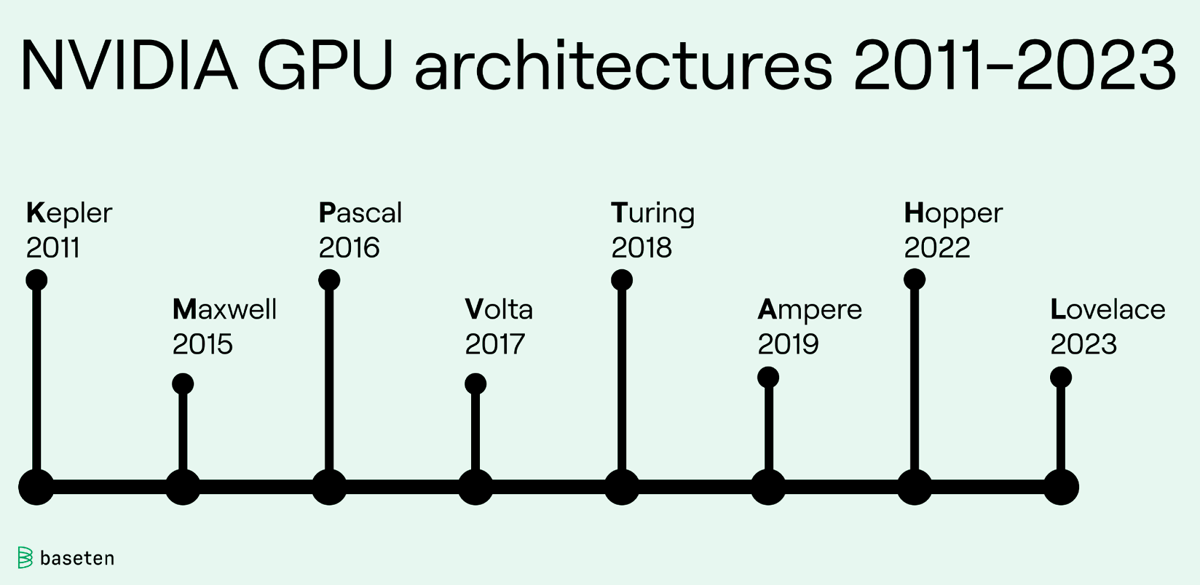

GPU 名称中的字母指的是该 GPU 的架构。每隔几年,NVIDIA 都会针对消费类和数据中心产品的 GPU 发布新的微架构。新的微架构通过更新的指令集提高了性能和功效,并且通常利用更小的工艺节点将更多的晶体管封装到每个芯片上。每个新的微架构都意味着更快、更优化的 GPU。

在 GPU 的名称中,该字母是架构名称的第一个字母。例如,A 代表安培,L 代表洛夫莱斯。NVIDIA GPU 架构以著名科学家的名字命名。

GPU 架构的时间表

GPU 架构的时间表

数量:卡层

对于每种架构,NVIDIA 都会生产多种具有不同价格、性能和功耗目标的 GPU。数字越大,GPU 的功能就越强大,价格也就越昂贵。

不同级别的 GPU 针对不同的计算工作负载进行了优化。最近几代的等级包括:

-

4:一代中最小的 GPU,4 层卡能耗低,最适合经济高效地调用中等大小的模型。

-

10:针对 AI 推理进行优化的中端 GPU。

-

40:最适合虚拟工作站、图形和渲染的高端 GPU。

-

100:一代中最大、最昂贵、最强大的 GPU。它具有最高的核心数量和最多的 VRAM,专为大型模型的推理以及训练和微调新模型而设计。

比较示例

有了这两个因素,我们就可以使用 GPU 名称中的字母和数字组合来推断有关该卡的一些事实。

示例:T4 和 L4 有什么区别?

L4 是 T4 的下一代替代品。L4 使用 Lovelace 架构并于 2023 年发布,而 T4 使用 Turing 架构并于 2018 年发布。这些卡属于同一级别 - 它们使用相似的功率并且设计用于相似的用例 - 但更新的卡L4 拥有越来越强大的核心和 24 GB 的 VRAM,而 T4 则为 16 GB。

示例:A10 和 A100 有什么区别

A100 是 A10 的更大、更强大、更昂贵的版本。两种卡具有相同的架构,但 A100 具有更多的内核和 VRAM,并且消耗更多的电量,因此它可以运行更大的模型并运行得更快。

示例:如何比较 K80 和 T4?

不同架构和不同层的任意两张卡之间的比较是复杂的。K80 使用已有十年历史的开普勒架构,而 T4 采用更现代的图灵架构。因此,对于许多机器学习任务来说,T4 每分钟的运行成本更低(由于其功耗较低),同时由于其更强大的内核,其速度也比 K80 快得多。

示例:T4 和 A10 可以提供哪些型号的服务?

示例:T4 和 A10 可以提供哪些型号的服务?

有关详细分类,请查看此比较文章。

refer : https://www.baseten.co/blog/understanding-nvidias-datacenter-gpu-line/

标签:数据中心,架构,示例,T4,NVIDIA,GPU From: https://www.cnblogs.com/tongai/p/18054276