视觉和语言模型的交叉导致了人工智能的变革性进步,使应用程序能够以类似于人类感知的方式理解和解释世界。大型视觉语言模型(LVLMs)在图像识别、视觉问题回答和多模态交互方面提供了无与伦比的能力。

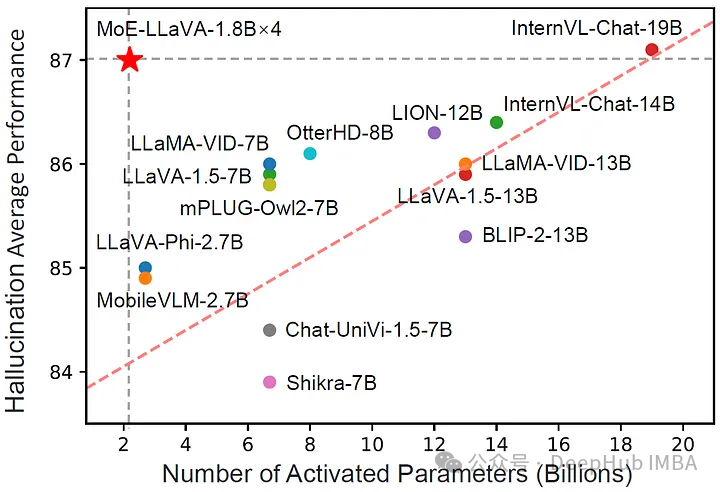

MoE-LLaVA利用了“专家混合”策略融合视觉和语言数据,实现对多媒体内容的复杂理解和交互。为增强LVLMs提供了更高效、更有效的解决方案,而不受传统缩放方法的典型限制。

lvlm及其挑战

大型视觉语言模型(LVLMs)代表了人工智能和机器学习领域的重大突破。这些模型旨在理解和解释视觉和语言数据之间复杂的相互作用,从而能够更深入地理解多媒体内容。它们的重要性在于处理和分析大量数据类型的能力,包括图像和文本,这对于图像识别、自然语言处理和自动推理等人工智能应用的进步至关重要。

但是扩展lvlm带来了巨大的挑战。随着这些模型的规模不断扩大,它们需要的计算资源也呈指数级增长。这种规模和复杂性的增加导致更高的成本和更大的能源消耗。更大的模型可能变得更容易出错和效率低下,因为管理和训练它们变得越来越困难。

https://avoid.overfit.cn/post/2b965fa8f73647c19679f1611fd37af2

标签:语言,缩放,模型,LLaVA,视觉,MoE From: https://www.cnblogs.com/deephub/p/18010723