大型语言模型(llm)已经彻底改变了自然语言处理领域。随着这些模型在规模和复杂性上的增长,推理的计算需求也显著增加。为了应对这一挑战利用多个gpu变得至关重要。

所以本文将在多个gpu上并行执行推理,主要包括:Accelerate库介绍,简单的方法与工作代码示例和使用多个gpu的性能基准测试。

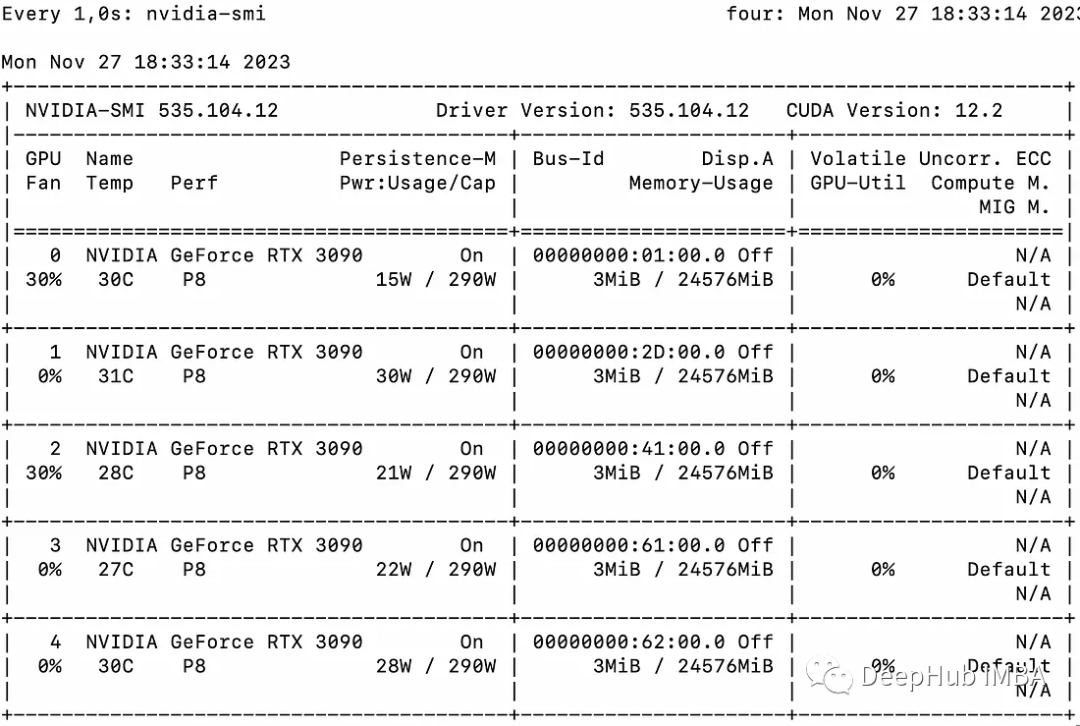

本文将使用多个3090将llama2-7b的推理扩展在多个GPU上

https://avoid.overfit.cn/post/8210f640cae0404a88fd1c9028c6aabb

标签:多个,Accelerate,LLM,gpu,GPU,推理 From: https://www.cnblogs.com/deephub/p/17863892.html