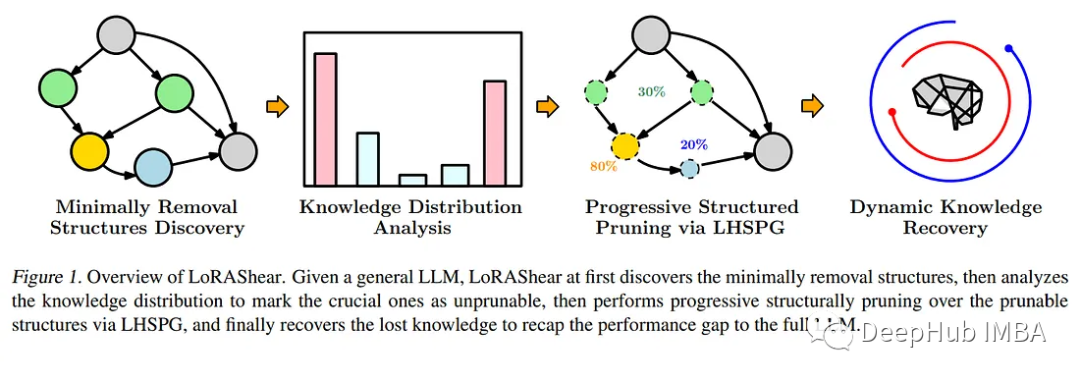

LoRAShear是微软为优化语言模型模型(llm)和保存知识而开发的一种新方法。它可以进行结构性修剪,减少计算需求并提高效率。

LHSPG技术( Lora Half-Space Projected Gradient)支持渐进式结构化剪枝和动态知识恢复。可以通过依赖图分析和稀疏度优化应用于各种llm。

LoRAPrune将LoRA与迭代结构化修剪相结合,实现参数高效微调。在LLAMA v1上的实现即使进行了大量的修剪也能保持相当的性能。

在不断发展的人工智能领域,语言模型模型(llm)已经成为处理大量文本数据、快速检索相关信息和增强知识可访问性的关键工具。它们的深远影响跨越了各个领域,从增强搜索引擎和问答系统到启用数据分析,研究人员、专业人员和知识寻求者都从中获益。

https://avoid.overfit.cn/post/8597a41beae546be95fb165c32ef0605

标签:修剪,LLM,微软,模型,知识,llm,LoRAShear From: https://www.cnblogs.com/deephub/p/17825699.html