前言 来自新加坡南洋理工大学的研究者们定义了一个名为广义引用分割(Generalized Referring Expression Segmentation,GRES)的新任务,将经典的引用分割扩展到允许表达式指代任意数量的目标对象。同时,文章还构建了第一个大规模的GRES数据集gRefCOCO,其同时包含多目标、无目标和单目标表达式。

本文转载自将门创投

作者 | Henghui Ding

仅用于学术分享,若侵权请联系删除

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

论文地址:https://arxiv.org/abs/2306.00968

项目主页:https://henghuiding.github.io/GRES/

RES在图形编辑、视频制作、人机交互和机器人等众多应用领域具有巨大潜力。目前,大多数现有方法都遵循在知名数据集ReferIt和RefCOCO中定义的RES规则,并在近年来取得了巨大进展。然而,大多数经典的引用分割方法对任务有预定义的强约束:

- 传统的RES不考虑无目标表达式,即在图像中没有匹配对象的自然表达语句。这意味着如果语句描述的目标在输入图像中不存在,现有的RES方法的行为是未定义的。在这种假设下,输入表达式必须与图像中的某个对象匹配,否则会不可避免地出现错误。

- 大多数现有数据集,例如最流行的RefCOCO,几乎不包含多目标表达式,即在一句话中同时指向多个目标物体的表达式。这意味着如果需要同时查找多个目标,用户需要分多次键入查询指令且每次只能指向一个目标物体。

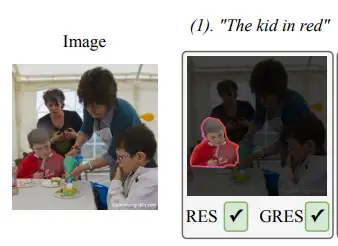

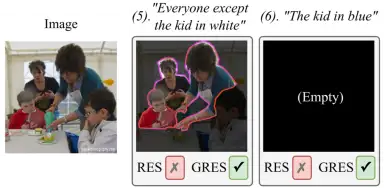

图1:引用分割的实例,使用“The kid in red”来指示并分割图片中的红衣服小男孩

一、新任务:广义引用表达式分割

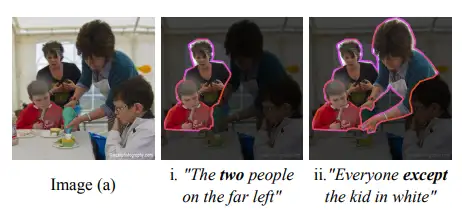

在文章中,为了解决传统RES存在的问题,研究者们提出了一个名为广义引用表达分割(Generalized Referring Expression Segmentation,简称GRES或广义引用分割) 的新任务,允许表达式指向任意数量的目标对象。与经典的RES类似,GRES接受一张图像和一句自然语言表达式作为输入。但与传统RES不同,GRES进一步支持了多目标表达式,即在单个表达式中指定多个目标对象,例如图2中的“Everyone except the kid in white”,以及无目标表达式,即表达式没有指向图像中的任何对象,例如图2中的“the kid in blue”。GRES为输入表达式提供了更大的灵活性,可以更好地支撑引用分割的实际应用。

图2:多目标表达式和无目标表达式示例二、新数据集:gRefCOCO

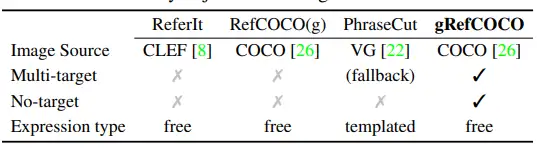

然而,现有的几个引用表达数据集,如RefCOCO系列,几乎不包含多目标表达式或无目标表达式样本,只有单目标表达式样本,如表1所示。

表1:gRefCOCO与其他引用表达式数据集的比较

为了促进对GRES的研究工作,本文构建了新的大规模引用分割数据集gRefCOCO。它进一步包含多目标表达式和无目标表达式。该数据集共有278,232个表达式,其中包括80,022个多目标表达式和32,202个无目标表达式,涉及19,994张图像中的60,287个不同物体。

gRefCOCO数据集的多目标表达式主要有以下难点:

- 计数表达式:处理包含计数的表达式,需要区分基数词和序数词,如“two”和“second”,并具备对象计数能力。

- 复合句结构:理解复合句结构中的多个元素之间的关系,包括“A and B”、“A except B”和“A with B or C”。如图3中的第一个表达式。

- 属性的范围:要处理多目标表达式中的不同目标之间的属性共享或差异,需深入理解各个属性以及它们与相应对象之间的关系。

- 复杂关系:多目标表达式中的关系描述更复杂,需要理解并推断目标之间的关系,例如通过关键词“and”来指示目标数量。模型需对图像和表达式中的所有实例及其相互作用有深入理解。如图3中的第二个表达式,使用了复杂的句子来表达目标与非目标之间的关系。

图3:gRefCOCO样本示例

无目标表达式的构建主要遵循两个原则:

- 表达式不能与图像完全无关。例如,给定图1中的图像,“the kid in blue”是可以接受的,因为图像中确实存在“kid”和“blue”,但没有一个“kind in blue”。但是像"狗"、“汽车”、"河流"等与该图像中的任何内容都完全无关的表达式是不可接受的。

- 如果规则1中所要求的表达式很难想出,标注员可以选择从RefCOCO同一split中的其他图像中选取具有迷惑性的表达式。

三、新模型:ReLA

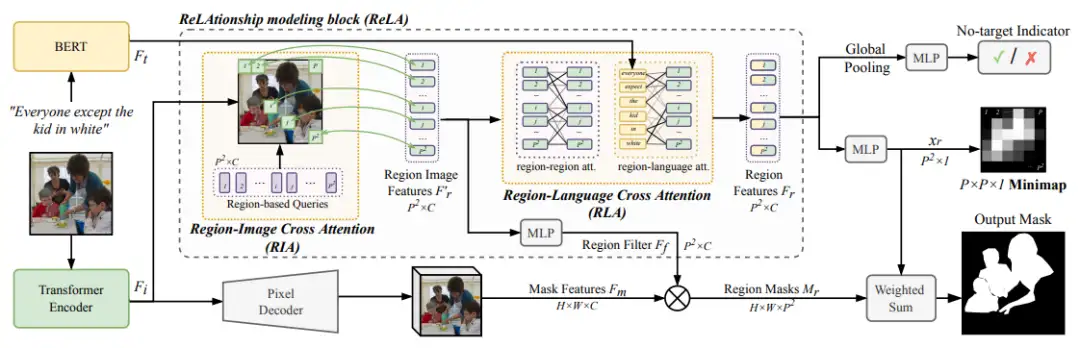

GRES中多目标表达式中的关系和属性描述更加复杂。与经典的引用分割(RES)相比,对于广义引用表达分割(GRES)来说,更具挑战性的是对图像中区域之间的复杂交互关系进行建模,并捕捉所有对象的细粒度属性。本文提出了一个新的基准模型ReLA,明确地对图像的不同部分和表达式中的不同单词进行信息交换和相互作用,以分析它们之间的依赖关系。通过这种方式,能够更好地理解图像和表达式之间的复杂交互。

所提出的关系(ReLAtionship)建模方法具有两个主要模块,即区域-图像交叉注意力(Region-Image Cross Attention,RIA)和区域-语言交叉注意力(Region-Language Cross Attention,RLA)。RIA模块灵活地收集区域图像特征,而RLA模块则捕捉区域之间的关系以及区域与语言之间的依赖关系。通过这两个模块,能够更好地建模图像和表达式之间的复杂交互,并提高引用表达分割的性能。

四、实验

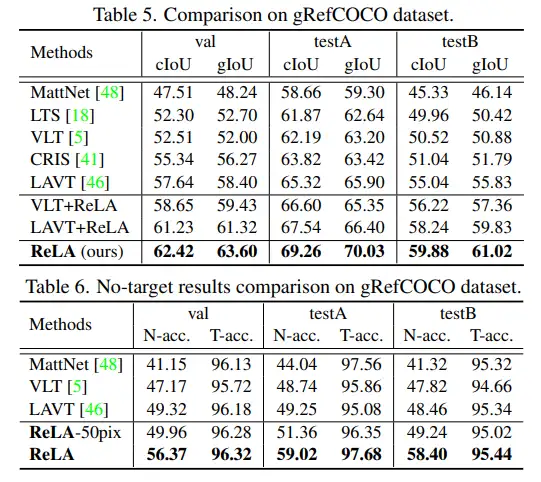

根据GRES任务的特性,文章提出了新的测评指标:gIoU、N-acc、T-acc,分别用来衡量整体分割性能、正确识别无目标表达式的性能、和无目标表达式对引用分割的影响。

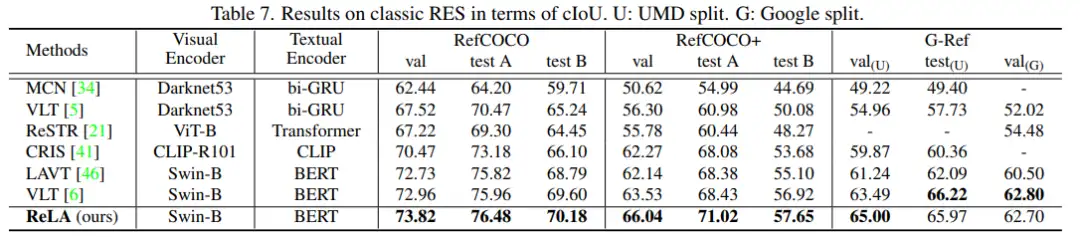

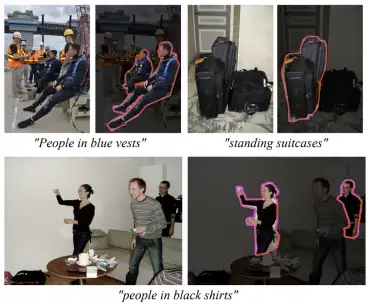

提出的基准方法ReLA在GRES和传统单目标RES上均取得了最佳性能。这证明了显式建模不同图像区域和词语之间的关系对引用分割的有效性。对多目标表达式的分割结果可视化如下:

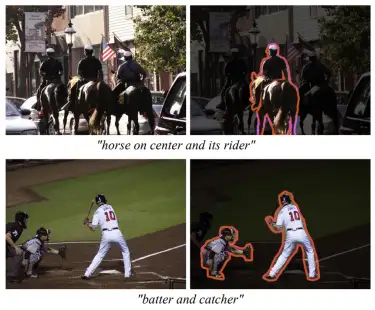

对无目标表达式的分割结果可视化如下:

五、 总结

本文分析并解决了经典引用分割(RES)任务的局限性,即无法处理多目标和无目标表达式。基于此,本文定义了一个名为广义引用表达分割(GRES)的新任务,允许表达式中包含任意数量的目标。

为支持GRES的研究,本文构建了一个大规模的数据集gRefCOCO、提出了基准方法ReLA,用于显式建模不同图像区域和词语之间的关系。该方法在经典的RES任务和新提出的GRES任务上取得了最佳结果。GRES降低了对自然语言输入的限制,扩大了引用分割的应用范围,如多实例和无正确对象的情况,期待GRES能够打开了新的应用领域。

更多细节,敬请参考论文原文。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

ICLR2023 | 扩散生成模型新方法:极度简化,一步生成

小内存有救了!Reversible ViT:显存减少15倍,大模型普及曙光初现!

此「错」并非真的错:从四篇经典论文入手,理解Transformer架构图「错」在何处

CVPR 2023 | 即插即用!SQR:对于训练DETR-family目标检测的探索和思考

CVPR 2023 Highlight | 西湖大学提出一种全新的对比多模态变换范式

libtorch教程(一)开发环境搭建:VS+libtorch和Qt+libtorch

NeRF与三维重建专栏(三)nerf_pl源码部分解读与colmap、cuda算子使用

NeRF与三维重建专栏(二)NeRF原文解读与体渲染物理模型

BEV专栏(一)从BEVFormer深入探究BEV流程(上篇)

可见光遥感图像目标检测(三)文字场景检测之Arbitrary

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

标签:分割,GRES,NTU,目标,CVPR23,引用,图像,表达式 From: https://www.cnblogs.com/wxkang/p/17496959.html