大侠幸会,在下全网同名「算法金」 0 基础转 AI 上岸,多个算法赛 Top 「日更万日,让更多人享受智能乐趣」

今日 216/10000

- 神经网络设计与选择

- 参数初始化与优化

- 学习率调整与正则化

- 数据预处理与标准化

- 训练过程与监控

- 特定模型技巧

- 其他训练技巧

1. 神经网络设计与选择

网络结构选择 多层感知器(MLP)是最基本的神经网络结构,由输入层、若干隐藏层和输出层组成。每一层的神经元与前一层的神经元全连接。这种结构适用于各种一般性任务,但对于图像和序列数据效果较差

循环神经网络(RNN)适用于处理序列数据,如时间序列和自然语言处理。RNN的特点是拥有记忆能力,通过隐状态(hidden state)传递信息,使其能够捕捉序列中的时序关系。然而,传统的RNN存在梯度消失和梯度爆炸问题,需要通过长短期记忆(LSTM)和门控循环单元(GRU)来改进

卷积神经网络(CNN)专为处理图像数据设计,通过卷积层、池化层和全连接层的组合,能够自动提取图像的空间特征。卷积层利用卷积核对输入图像进行局部感知,池化层则减少特征图的尺寸和参数数量,提高计算效率。CNN在计算机视觉任务中表现出色,如图像分类、目标检测和图像分割

激活函数选择 Sigmoid和Tanh是传统的激活函数,适用于简单的网络结构。Sigmoid将输入映射到0到1之间,Tanh则将输入映射到-1到1之间。这些激活函数在反向传播过程中容易导致梯度消失,影响网络训练效果

ReLU(修正线性单元)及其变种(如Leaky ReLU、Parametric ReLU)解决了梯度消失问题,提高了训练速度和效果。ReLU将输入大于零的部分直接输出,小于零的部分输出为零。Leaky ReLU在小于零部分引入一个较小的斜率,避免神经元完全失活

隐藏层设计 网络深度和隐藏层神经元数量是设计神经网络的重要因素。增加网络深度可以提高模型的表达能力,但同时也增加了训练难度和过拟合风险。选择合适的深度需要结合具体任务和数据情况

隐藏层中神经元的数量同样需要慎重选择。过少的神经元可能导致模型欠拟合,而过多的神经元则可能导致过拟合。通常可以通过交叉验证等方法来确定最佳的神经元数量

2. 参数初始化与优化

参数初始化

权重初始化方法对神经网络的训练效果有着重要影响。常见的权重初始化方法包括Xavier初始化和He初始化。Xavier初始化将权重设置为服从均值为0、方差为 2/(a_in+b_out) 的正态分布,其中 a_in 和 b_out 分别是输入和输出层的神经元数量。这种方法适用于Sigmoid和Tanh激活函数。He初始化则将权重设置为服从均值为0、方差为 2/a_in 的正态分布,适用于ReLU及其变种激活函数

Bias初始化方法通常将偏置(Bias)初始化为零。这样做的原因是,在训练开始时,所有的神经元有相同的激活输入,且不会因偏置不同而产生差异

优化算法 Mini-batch SGD(随机梯度下降)是常用的优化算法,通过每次更新一小部分样本的梯度来加速训练并减少内存使用。相比于全量数据的梯度下降,Mini-batch SGD在训练大数据集时更为高效

对于大数据集,Adam(自适应矩估计)优化算法是一种常用选择。Adam结合了动量和RMSProp的优点,能够自适应地调整学习率,提高训练稳定性和速度。对小数据集,RMSProp和AdaGrad也常被使用,因其能够根据梯度的历史信息调整每个参数的学习率

自适应学习率方法 Adagrad是一种自适应学习率方法,通过对每个参数的梯度平方和进行累加,调整每个参数的学习率。Adagrad适用于稀疏特征数据,但在后期学习率可能变得过小

其他自适应方法如RMSProp和Adam改进了Adagrad。RMSProp通过引入衰减系数,限制了累积的梯度平方和,避免学习率过小的问题。Adam则结合了动量和RMSProp的优点,计算每个参数的动量和二阶矩估计,自适应调整学习率,提高了训练的稳定性和速度

参数初始化和优化是神经网络训练中的关键步骤,合理的初始化和优化算法选择能够显著提升模型性能和训练效率。

点击 ↑ 领取

3. 学习率调整与正则化

学习率调整 固定学习率是最简单的学习率设置方式,在整个训练过程中保持不变。然而,固定学习率可能导致训练过程不稳定,难以找到最优解

动态学习率方法则通过在训练过程中调整学习率,提高训练效果。常见的动态学习率方法包括学习率衰减和自适应学习率。学习率衰减方法中,常见的有指数衰减和分段常数衰减,通过逐步减小学习率,避免训练后期的震荡现象。自适应学习率方法如Adam和RMSProp,通过自适应调整每个参数的学习率,进一步提高训练的稳定性和效率

正则化方法 减小模型大小是最直接的正则化方法之一,通过减少模型参数数量,降低过拟合风险。选择合适的网络结构和隐藏层神经元数量可以有效控制模型复杂度

L1/L2正则化是常用的正则化方法,通过在损失函数中加入参数的L1或L2范数,限制参数的大小,从而减少模型的复杂度。L1正则化倾向于产生稀疏参数,有助于特征选择;L2正则化则倾向于均匀缩小参数,防止过拟合

Early Stopping是一种简单有效的正则化方法,通过在验证误差不再下降时提前停止训练,避免模型在训练集上过拟合。设置适当的早停条件和验证集,可以显著提升模型的泛化能力

Dropout是另一种常用的正则化方法,通过在训练过程中随机丢弃一定比例的神经元,减少神经元间的共适应性,增强模型的鲁棒性。训练时丢弃神经元,预测时使用所有神经元的缩放输出,能够有效防止过拟合

通过合理的学习率调整和正则化方法,可以显著提高神经网络的训练效果和泛化能力。

4. 数据预处理与标准化

数据预处理 确保数据的一致性和连续性是数据预处理的关键步骤之一。对于缺失数据,可以使用插值法或填补法进行处理。对于分类数据,可以使用独热编码(One-Hot Encoding)将其转换为数值形式。数据的一致性还包括处理异常值、平滑数据和消除重复数据等

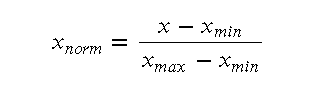

数据归一化和标准化也是预处理的重要步骤。归一化(Normalization)通常将数据缩放到[0,1]范围内,常用的公式为:

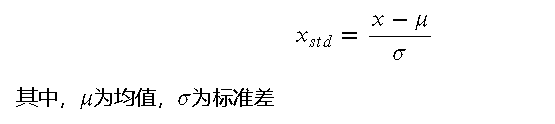

标准化(Standardization)则将数据调整为均值为0、方差为1的分布,公式为:

标准化(Normalization) 输入/输出标准化是提高神经网络训练效果的关键步骤。对于输入数据,通过标准化可以使不同特征的数据在同一尺度上,避免某些特征对训练过程的过度影响。输出数据的标准化则有助于模型更好地拟合目标值,特别是在回归任务中

常见的标准化方法包括Z-score标准化和Min-Max归一化。Z-score标准化通过调整数据的均值和方差,使其符合标准正态分布。Min-Max归一化则将数据缩放到指定的范围内,通常为[0,1]或[-1,1]

数据预处理和标准化能够显著提高模型的训练效率和效果,是神经网络训练中的重要步骤。

抱个拳,送个礼

点击 ↑ 领取

5. 训练过程与监控

梯度检查(Gradient Check) 梯度检查是一种确保反向传播算法正确性的重要方法。通过数值梯度和解析梯度的对比,可以验证反向传播实现是否正确。具体步骤如下: