过去5年,媒体行业一直都在进行着信息化建设向融媒体平台建设的转变。一些融媒体的建设演变总结如下:

- 新闻终端的端侧内容矩阵建设,如App新闻端,社交平台上的官方媒体等

- 新闻+本地生活双旗舰客户端,兼顾主流媒体核心宣传,同时也在推进探索本地民生经营新平台

- 重塑融媒体用户增长链路,以技术带动用户的体验和服务,在多媒体终端,基于用户生命周期挖掘用户价值

AI元年开始,也是融媒到智媒的开始

拥抱新技术,产品才有可能破圈出海。内卷下的媒体,以怎样的方式创新,是让自身服务“出圈”的关键。 2013年,市场倒逼传统媒体和新兴媒体融合发展,充分运用新技术新应用创新媒体传播方式,占领信息传播制高点。 转眼十年。2023年,以AIGC(人工智能生产内容)为代表的人工智能技术加速迭代演进,媒体融合进入媒体智能化快速发展新时代。 如何运用好人工智能技术为媒体深度融合提供强有力支撑?这一备受关注的课题。 纵观这两年,传媒企业一直在探索AI+内容的服务或体验优化,甚至说是营收变现的新路径。一些常见的创新探索类目包括:

纵观这两年,传媒企业一直在探索AI+内容的服务或体验优化,甚至说是营收变现的新路径。一些常见的创新探索类目包括:

1、AI生成内容(AIGC)

有别于以往内容生产模式在PGC(专业生成内容)+ UGC(用户生成内容),AIGC(人工智能生成内容)是新的内容生产渠道。例如:新京报贝壳财经积极尝试新技术,目前部分财经快讯来自AI写作。新京报动新闻作为专业的动画新闻栏目,也在研究尝试新的数字化技术,包括虚拟数字人IP的打造和应用、VR全景视频的尝试和探索以及虚拟制片的接触和探索。2、AR/XR技术赋能虚拟数字人的升级迭代

AI技术爆发前,虚拟数字人的发展非常缓慢。2023年AI算法、算力的主推下,5G、虚拟增强技术、智能硬件等技术的升级,数字人得到的空前的技术支撑和爆发。 例如,新华智云文化数字操作系统,扫描二维码就能走进画中与汤显祖、王安石等古人“对话”,体验一场“穿越时空”。“我们结合大模型、AIGC、数字人等先进技术的文化数字操作系统,深度挖掘地方文化地标、历史名人大数据,智能生产AI文旅产品,能够更快更广地传播中华优秀传统文化。”据相关负责人介绍,该技术应用已经服务全国300多家文旅机构,赋能京杭大运河、江西滕王阁等知名文化遗产。3、AI助手实现人机高效协同

作为新一轮科技革命和产业变革的重要驱动力量,人工智能技术取得突破性进展,它正颠覆性地改变着传统新闻生产与传播流程,重塑着整个传媒业态。AI助手帮助企业员工提速的实践尤其多。 例如,芒果TV已经运用AIGC技术生成基于原创文本的有声剧、帮助策划撰写剧本。从效率提升延展至价值挖掘

从上面几个典型的AI相关的应用场景,除了虚拟数字人应用在to C用户服务以提升感官体验外,其他两个主要场景更多是在提高内部工作效率场景上,AI技术在用户价值挖掘和用户服务方面并没有太多的实践场景。1、构建超级APP的大背景

全球权威咨询机构Gartner于2022年10月19日发布企业机构在2023年需要探索的十大战略技术趋势,超级APP(Superapps)也在榜单之中。似乎不仅仅在中国,也不仅仅局限在业务应用和实践层面,扩展至全球技术层面,超级APP的构建也同样是闪亮的焦点。相比起2022年上榜的组装式应用,似乎更聚焦至智能设备(尤其是App)的快速构建技术上。 传媒行业也不例外。从融媒体向智媒体发展的路上,「融媒体超级APP」的理念应许而生:集合多个应用功能,除了满足媒体的新闻传播需求,与此同时,基于跨端开发框架,帮助融媒体平台成长为超级APP。 更进一步,传媒的超级APP 2.0时代,应该是探索与AI技术相融合,平台更通用、开放和融合的形态。2、超级跨端:小程序技术

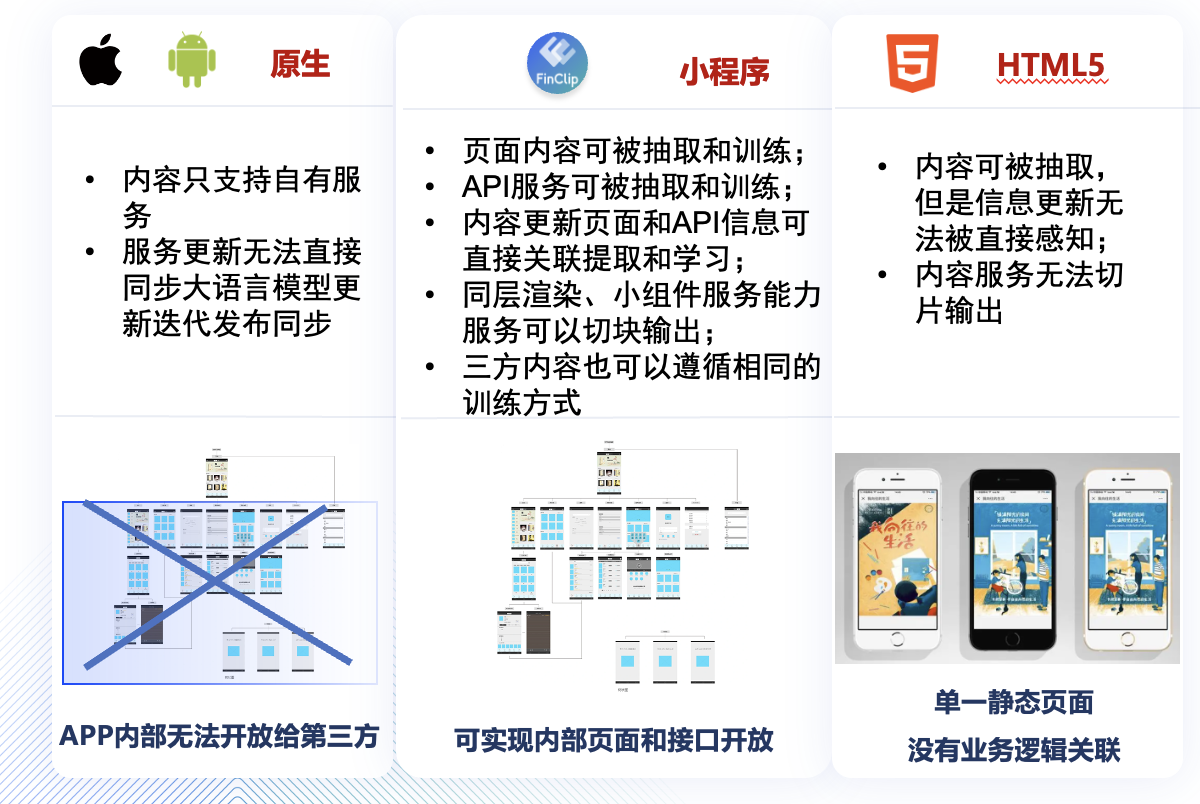

小程序技术近年来越来越重要:许多大厂都开始入局小程序,微信小程序场景生态已经超千万。市面上成熟的小程序容器技术(如:FinClip、mPass等),是企业构建超级APP的基础能力。当APP集成了小程序容器 SDK 之后,不论是 iPhone, Android, Flutter,React Native, 电脑、电视、车载或物联网设备, 都能够让不同的应用或终端设备快速具备运行小程序的能力,而且同一个小程序场景可以分发到不同终端中运行,不需要针对不同终端编写不同代码。 以FinClip为例,不仅仅提供IOS,andriod等SDK,还在中国信创化、鸿蒙化的国产浪潮下,推出了适配国产操作系统(如麒麟、UOS、HarmonyOS等)

3、LLM+小程序生态,双轮效应无限放大

微信小程序平台推出已经有7年的时间,小程序场景生态1000+万,场景非常的丰富,为传媒企业构建超级App奠定了坚实的市场生态基础。与此同时,小程序技术也是LLM服务结合的最佳语法:- 页面内容可被抽取和训练

- API服务可被抽取和训练

- 内容更新页面和API信息可直接关联提取和学习

- 同层渲染、小组件服务能力服务可以切块输出

- 三方内容也可以遵循相同的训练方式

常规App的场景构建,入口都是平铺式的图标,随着App内场景的逐渐丰富、甚至是爆炸式的增长,平台需要投入大量的运营人员,基于用户的综合行为进行“人工”推荐,且不说运营策略增长会有瓶颈,手工的数据挖掘很有可能会忽略用户的真实需求。

基于LLM的应用推荐,就不会有上述问题。App上的应用,通过推荐语料的关联,平台只需要基于大模型训练后的推荐,前端结合AI助手进行更智能的推荐,加上小程序技术天然可以将应用场景以定位到某个具体页面,甚至页面中组件的形态呈现在客户面前。

想象无限。

融媒体时代,小程序框架已经成为传媒企业不可或缺的工具。它不仅能够帮助企业快速构建移动应用,还能助力企业在AI实践下实现服务变现。通过小程序框架,传媒企业可以将传统媒体内容转化为可交互、可分享的数字化内容,并提供更加个性化的用户体验。同时,小程序框架还可以帮助企业打通数据壁垒,实现用户数据的深度挖掘和分析,从而为用户提供更加精准的营销服务。

展望未来,小程序框架必将继续发挥其重要作用,助力传媒企业在AI实践下实现服务变现。传媒企业应积极拥抱小程序框架,不断创新应用场景,为用户提供更加优质的服务。

标签:场景,媒到,从融,媒体,AI,APP,程序,技术,LLM

From: https://www.cnblogs.com/speedoooo/p/18193507

常规App的场景构建,入口都是平铺式的图标,随着App内场景的逐渐丰富、甚至是爆炸式的增长,平台需要投入大量的运营人员,基于用户的综合行为进行“人工”推荐,且不说运营策略增长会有瓶颈,手工的数据挖掘很有可能会忽略用户的真实需求。

基于LLM的应用推荐,就不会有上述问题。App上的应用,通过推荐语料的关联,平台只需要基于大模型训练后的推荐,前端结合AI助手进行更智能的推荐,加上小程序技术天然可以将应用场景以定位到某个具体页面,甚至页面中组件的形态呈现在客户面前。

想象无限。

融媒体时代,小程序框架已经成为传媒企业不可或缺的工具。它不仅能够帮助企业快速构建移动应用,还能助力企业在AI实践下实现服务变现。通过小程序框架,传媒企业可以将传统媒体内容转化为可交互、可分享的数字化内容,并提供更加个性化的用户体验。同时,小程序框架还可以帮助企业打通数据壁垒,实现用户数据的深度挖掘和分析,从而为用户提供更加精准的营销服务。

展望未来,小程序框架必将继续发挥其重要作用,助力传媒企业在AI实践下实现服务变现。传媒企业应积极拥抱小程序框架,不断创新应用场景,为用户提供更加优质的服务。

标签:场景,媒到,从融,媒体,AI,APP,程序,技术,LLM

From: https://www.cnblogs.com/speedoooo/p/18193507