多次重新初始化hadoop namenode -format后,DataNode或NameNode没有启动

在搭建完hadoop集群后,需要对主节点进行初始化(格式化)

其本质是清理和做一些准备工作,因为此时的HDFS在物理上还是存在的。

而且主节点格式化操作只能进行一次。

当我们不小心多次初始化,会导致启动hadoop集群时,主节点DataNode或NameNode无法启动

[root@node01 hadoop]# jps

6628 SecondaryNameNode

7412 Jps

6901 ResourceManager

7066 NodeManager

解决方法如下:

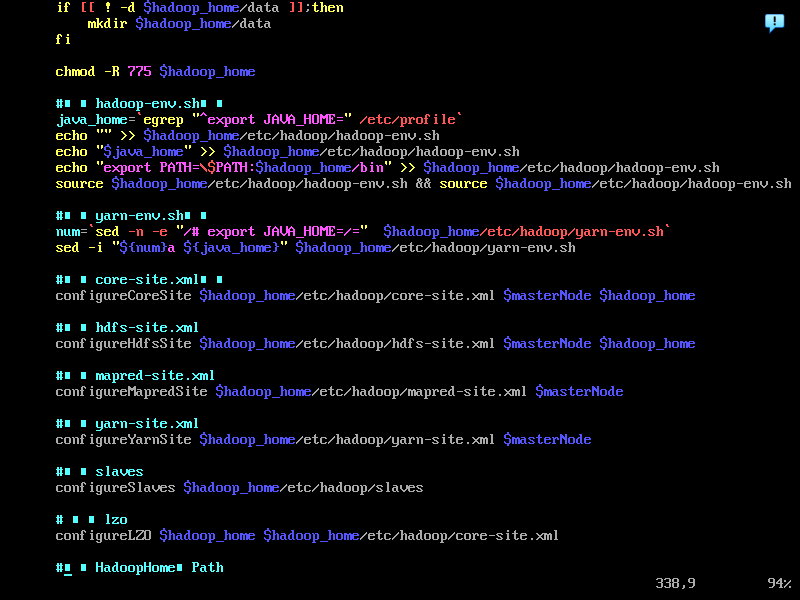

在重新初始化(格式化)前,

-

先在主节点上运行

stop-all.sh终止所有进程 (可以使用jps查看) -

删除配置文件core-site.xml 和hdfs-site.xml中指定目录下的文件

查找方法:查看配置文件里面是如何写的

示例:

$hadoop_home = /opt/app/hadoop-2.7.7- 首先找到指定目录

查看hdfs-site.xml文件

示例: $hadoop_home/etc/hadoop/hdfs-site.xml

<configuration>

.

.

.

<property>

<name>dfs.namenode.dir</name>

<value>file:/opt/app/hadoop-2.7.7/name</value>

</property>

<property>

<name>dfs.datanode.dir</name>

<value>file:/opt/app/hadoop-2.7.7/data</value>

</property>

.

.

.

</configuration>

查看core--site.xml

示例:$hadoop_home/etc/hadoop/core--site.xml

<configuration>

.

.

.

<property>

<name>dfs.tmp.dir</name>

<value>file:/opt/app/hadoop-2.7.7/tmp</value>

</property>

.

.

.

</configuration>

cd /opt/app/hadoop-2.7.7去看有哪些内容

- 删除 dfs.namenode.dir和dfs.datanode.dir所指目录里的文件

-

rm -rf name -

rm -rf data

- 删除logs日志文件和tmp缓存文件

rm -rf logsrm -rf tmp

- 最后重新初始化(格式化)

hadoop namenode - format

!!!注意:每个结点上都需要删除相应文件

废弃命令(不要执行):

标签:opt,xml,format,app,hadoop,site,DataNode,2.7 From: https://www.cnblogs.com/Oraer/p/17397251.htmlcd /opt/app/hadoop-2.7.7

cat /etc/hadoop/hdfs-site.xml

rm -rf /opt/app/hadoop-2.7.7/data

rm -rf /opt/app/hadoop-2.7.7/name