海外SRC信息收集

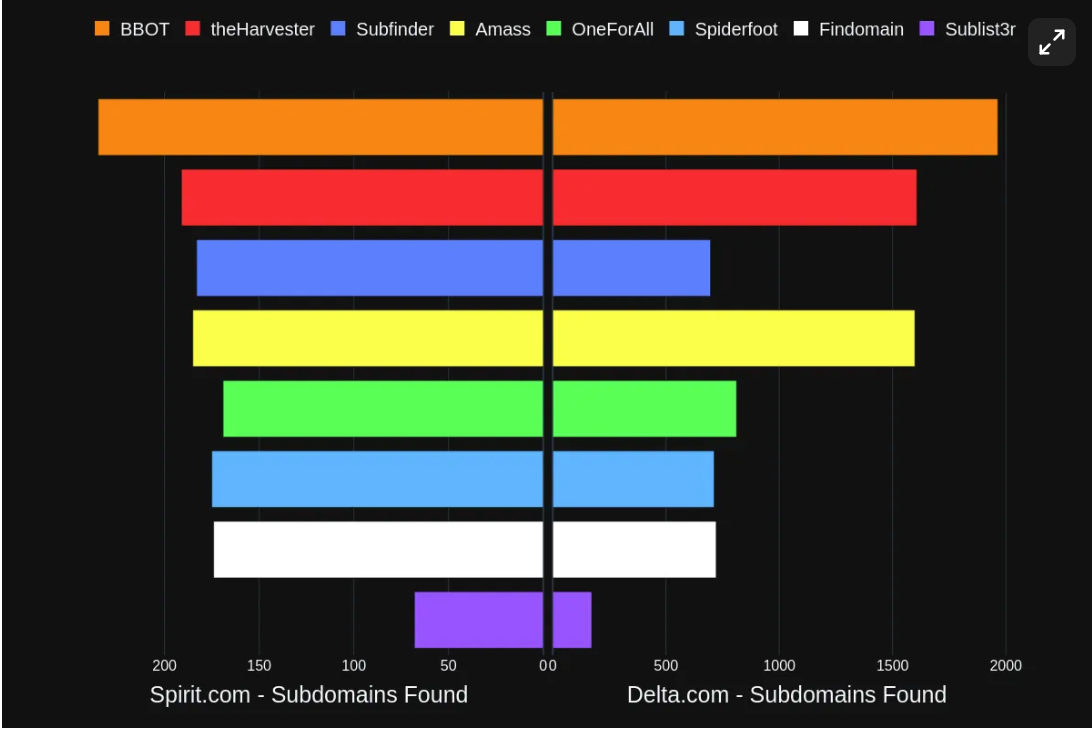

子域名爆破工具:bbot,subfinder

相关测评:https://blog.blacklanternsecurity.com/p/subdomain-enumeration-tool-face-off

bbot收集的子域名最多,subfinder跑的最快

bbot使用

api配置:vim ~/.config/bbot/secrets.yml (配置api辅助收集)

常用命令:

# 收集evilcorp.com的子域名,结果输出到evilcorp.txt文件中

bbot -t evilcorp.com -p subdomain-enum | grep '[DNS_NAME]' | cut -f2 | tee evilcorp.txt

# 提取子域名,输出到domain.txt中

cat evilcorp.txt | grep '[DNS_NAME]' | cut -f2 | tee domain.txt

# 只进行被动扫描

bbot --flags passive --targets evilcorp.com

subfinder使用

api配置:vim $HOME/.config/subfinder/provider-config.yaml(尽可能多api)

常用命令:

# 收集hackerone域名,结果保存为当前目录下hackerone2.txt

subfinder -d hackerone.com -all -silent | tee hackerone2.txt

amass使用

# 被动

amass enum --passive -d example.com -o example.txt

# DNS枚举

amass enum -brute -min-for-recursive 2 -d example.com

使用多个工具收集子域名保存为txt文件,再进行去重:

cat subdomain1.txt subdomain2.txt subdomain3.txt | anew allsubdomains.txt

cat subdomain1.txt subdomain2.txt subdomain3.txt | sort -u > allsubdomains.txt

模糊测试工具:ffuf

常用命令:

基本使用:

# 对hackerone.com进行fuzz,只输出结果

ffuf -w ./wordlist.txt -u https://hackerone.com/FUZZ -s

# 多个单词列表:

ffuf -w domains.txt:DOMAIN -w wordlist.txt:WORD -u 'https://DOMAIN/WORD'

# 过滤结果,后面加上

-mc 200,300-304,401-403

端口扫描工具:nmap

进行端口扫描得到一些隐藏信息

基本使用:

nmap -T4 -sV -sn target_ip

探测存活

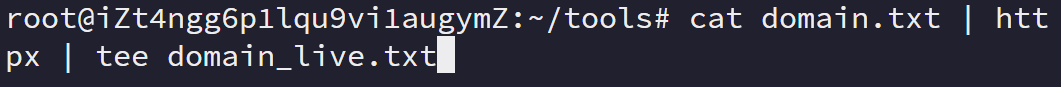

httpx:

详细:https://blog.csdn.net/u010062917/article/details/121878824

# sub.txt不带协议头,subs_live.txt带协议头

cat domain.txt | httpx | tee domain_live.txt

爬取URL

gau:

URL最多,脏数据也很多,建议过滤再去重

$ printf example.com | gau

$ cat domains.txt | gau --threads 5

$ gau example.com google.com

$ gau --o example-urls.txt example.com

$ gau --blacklist png,jpg,gif example.com

# 找到子域名后:

cat domain_live.txt | gau > gau_out.txt

waybackurls:

cat domains.txt | waybackurls > url1.txt

waymore:

找到比其他现有工具更多的链接

# 单个域名只获取 URL

waymore -i hackerone.com -mode U

# 批量获取,不下载

cat domain.txt | waymore -mode U | tee url2.txt

Hakrawler

用于收集 URL 和 JavaScript 文件位置的快速 golang 网络爬虫,

注意:传入的是URL,可以在子域名爆破后用httpx探测存活,再传入hakrawler

# 单个 URL

echo https://google.com | hakrawler

# 多个 URL

cat urls.txt | hakrawler -subs | tee url3.txt

katana

爬取URL

#

cat domain_live.txt | katana -sc -kf robotstxt,sitemapxml -jc -c 50 > url4.txt

来源:https://github.com/projectdiscovery/katana

gospider

用 Go 编写的快速网络蜘蛛

来源:https://github.com/jaeles-project/gospider

gospider -S subs_live.txt -o gospider_output -c 10 -d 2 --other-source --subs --sitemap --robots

paramspider(单独使用):

paramspider允许您从 Wayback 档案中获取与任何域或域列表相关的 URL。它会过滤掉“无聊”的 URL,让您专注于最重要的 URL(sql,xss等)

paramspider -d example.com

paramspider -l domains.txt

URL去重:

cat url1.txt url2.txt url3.txt | anew urls.txt

cat url1.txt url2.txt url3.txt | sort -u > urls.txt

目录扫描

字典(配合ffuf)

# 通用字典

https://github.com/danielmiessler/SecLists/blob/master/uzzing/403/403.md (403绕过)

https://github.com/danielmiessler/SecLists/blob/master/Fuzzing/fuzz-Bo0oM.txt(4k)

https://github.com/Bo0oM/fuzz.txt/blob/master/fuzz.txt (5k)

https://github.com/orwagodfather/WordList/blob/main/fuzz.txt(22k

https://github.com/thehlopster/hfuzz/blob/master/hfuzz.txt(18w)

https:/github.com/six2dez/OneListForAll

# 自定义字典(有时会有奇效) urls.txt是去重后的URL

获取路径字典

cat urls.txt | unfurl paths | sed 's/^.//' | sort -u | egrep -iv

"\.(jpg|swf|mp3|mp4|m3u8|ts|jpeg|gif|css|tif|tiff|png|ttf|woff|woff2|ico|pdf|svg|txt|js)" | tee paths.txt

获取参数字典

cat urls.txt | unfurl keys | sort -u | tee params.txt

dirsearch

# 不要404

python3 dirsearch.py -u https://target -x 404

# 指定字典

python3 dirsearch.py -u https://target -w /path/to/wordlist

# 递归

python3 dirsearch.py -u https://target -r

python3 dirsearch.py -u https://target -r --max-recursion-depth 3 --recursion-status 200-399

BBscan

# 从文件扫描

python BBScan.py -f urls.txt --api

# 从命令行扫描

python BBScan.py --host www.test.com

# 更多

https://github.com/lijiejie/BBScan

信息收集自动化工具

shuize:

python3 ShuiZe.py -d domain.com 收集单一的根域名资产

python3 ShuiZe.py --domainFile domain.txt 批量跑根域名列表

python3 ShuiZe.py -c 192.168.1.0,192.168.2.0,192.168.3.0 收集C段资产

python3 ShuiZe.py -f url.txt 对url里的网站漏洞检测

python3 ShuiZe.py --fofaTitle XXX大学 从fofa里收集标题为XXX大学的资产,然后漏洞检测

python3 ShuiZe.py -d domain.com --justInfoGather 1 仅信息收集,不检测漏洞

python3 ShuiZe.py -d domain.com --ksubdomain 0 不调用ksubdomain爆破子域名

绕过403

工具:https://github.com/iamj0ker/bypass-403

也可以ffuf模糊测试

标签:SRC,收集,--,cat,URL,https,工具,txt,com From: https://www.cnblogs.com/left-shoulder/p/18457306