1.导言

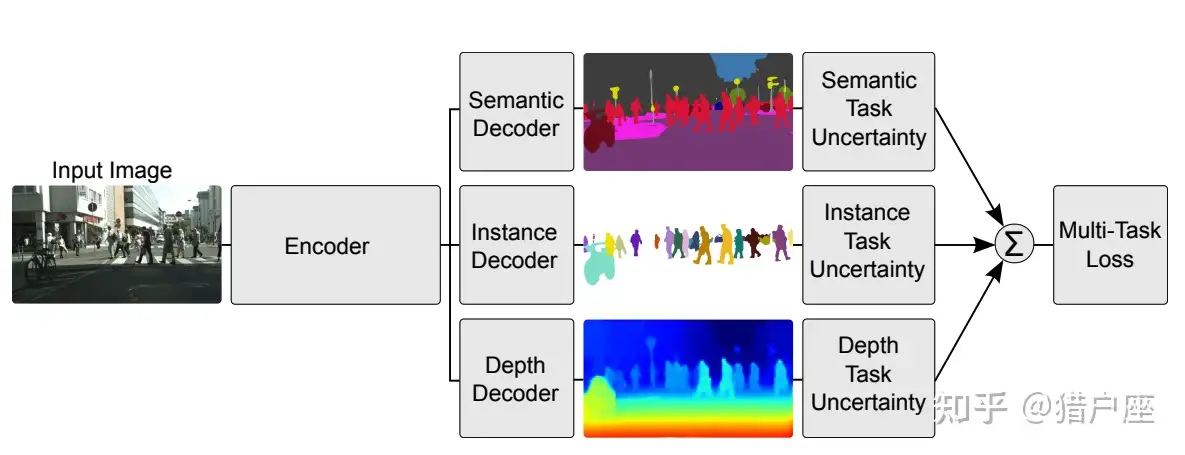

现在多任务学习根据实现方法可以粗略地被分为两种,一个是基于神经网络的多任务学习[1][2][3][4],这种多任务学习在CV和NLP取得了大量的应用。

基于神经网络的多任务学习

基于神经网络的多任务学习

然而我们最根溯源,其实多任务学习最开始并不是基于神经网络的,而是另一种经典的方法——基于正则表示的多任务学习,我们这篇文章也主要介绍后者。为什么在深度学习称为主流的今天,我们还需要了解过去的传统方法呢?

首先,经典的多任务学习和基于神经网络的多任务学习方法本质上都是基于知识共享的思想,而这种思想其他领域,比如联邦学习中得到了大量的应用(参见我的文章《分布式多任务学习及联邦学习个性化》)。而经典的基于正则表示的多任务学习更容易分布式化,因此大多数联邦多任务学习的论文灵感其实都来源于经典方法。我的研究领域主要是联邦学习,故我们下面主要介绍经典多任务学习。

2、多任务学习简介

2.1 多任务学习:迁移学习和知识表示的延伸

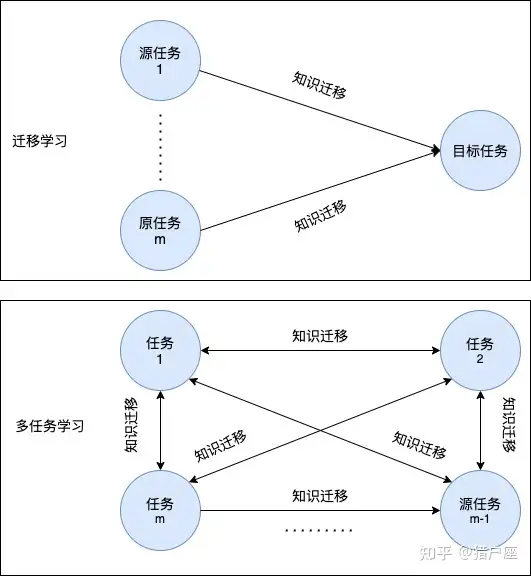

多任务学习(Multi-task Learning, MTL)近年来在CV、NLP、推荐系统等领域都得到了广泛的应用。类似于迁移学习,多任务学习也运用了知识迁移的思想,即在不同任务间泛化知识。但二者的区别在于:

- 迁移学习可能有多个源域;而多任务学习没有源域而只有多个目标域。

- 迁移学习注重提升目标任务性能,并不关心源任务的性能(知识由源任务 → 目标任务;而多任务学习旨在提高所有任务的性能(知识在所有任务间相互传递)。

下图从知识迁移流的角度来说明迁移学习和多任务学习之间的区别所示:

迁移学习和多任务学习

迁移学习和多任务学习

不严格地说,多任务学习的目标为利用多个彼此相关的学习任务中的有用信息来共同对这些任务进行学习。

2.2 多任务学习目前的两大主要实现方式

现在多任务学习根据数据的收集方式可以粗略地被分为两种,一个是集中化的计算方法,一种是分布式的计算方法,可以参见我的文章《多任务学习分布式化及联邦学习》。

3、基于正则化的多任务学习

3.1 基于正则化的多任务学习的形式表述

形式化地说,给定

标签:task,任务,学习,正则,learning,联邦,多任务 From: https://www.cnblogs.com/zhangxianrong/p/18440779