1、Hive的基本操作

1.1 Hive库操作

1.1.1 创建数据库

1)创建一个数据库,数据库在HDFS上的默认存储路径是/hive/warehouse/*.db。

create database testdb;

2)避免要创建的数据库已经存在错误,增加if not exists判断。(标准写法)

-- 中括号表示可以省略的内容

create database [if not exists] testdb;

create database if not exists testdb;

1.2.2 创建数据库和位置

create database if not exists hive_test location '/hive_test/hive_db';

数据库的名称和地址不一定一样,最终会由映射来反映出其数据库名

1.2.3 修改数据库

数据库的其他元数据信息都是不可更改的,包括数据库名和数据库所在的目录位置。

alter database dept set dbproperties('createtime'='20220531');

1.2.4 数据库详细信息

1)显示数据库(show)

show databases;

2)可以通过like进行过滤

show databases like 't*';

3)查看详情(desc)

desc database hive_test;

4)切换数据库(use)

use hive_db;

1.2.5 删除数据库

1)最简写法

drop database hive_db;

2)如果删除的数据库不存在,最好使用if exists判断数据库是否存在。否则会报错。

drop database if exists hive_db;

3)如果数据库不为空,使用cascade命令进行强制删除。报错信息如下FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. InvalidOperationException(message:Database db_hive is not empty. One or more tables exist.)

drop database if exists hive_db cascade;

1.2 Hive的数据类型

1.2.1 基础数据类型

| 类型 | Java数据类型 | 描述 |

|---|---|---|

| TINYINT | byte | 8位有符号整型。取值范围:-128~127。 |

| SMALLINT | short | 16位有符号整型。取值范围:-32768~32767。 |

| INT | int | 32位有符号整型。取值范围:-2 31 ~2 31 -1。 |

| BIGINT | long | 64位有符号整型。取值范围:-2 63 +1~2 63 -1。 |

| BINARY | 二进制数据类型,目前长度限制为8MB。 | |

| FLOAT | float | 32位二进制浮点型。 |

| DOUBLE | double | 64位二进制浮点型。 |

| DECIMAL(precision,scale) | 10进制精确数字类型。precision:表示最多可以表示多少位的数字。取值范围:1 <= precision <= 38。scale:表示小数部分的位数。取值范围: 0 <= scale <= 38。如果不指定以上两个参数,则默认为decimal(10,0)。 | |

| VARCHAR(n) | 变长字符类型,n为长度。取值范围:1~65535。 | |

| CHAR(n) | 固定长度字符类型,n为长度。最大取值255。长度不足则会填充空格,但空格不参与比较。 | |

| STRING | string | 字符串类型,目前长度限制为8MB。 |

| DATE | 日期类型,格式为yyyy-mm-dd。取值范围:0000-01-01~9999-12-31。 |

|

| DATETIME | 日期时间类型。取值范围:0000-01-01 00:00:00.000~9999-12-31 23.59:59.999,精确到毫秒。 | |

| TIMESTAMP | 与时区无关的时间戳类型。取值范围:0000-01-01 00:00:00.000000000~9999-12-31 23.59:59.999999999,精确到纳秒。说明 对于部分时区相关的函数,例如cast( as string),要求TIMESTAMP按照与当前时区相符的方式来展现。 | |

| BOOLEAN | boolean | BOOLEAN类型。取值:True、False。 |

1.2.2 复杂的数据类型

| 类型 | 定义方法 | 构造方法 |

|---|---|---|

| ARRAY | array<int>``array<struct<a:int, b:string>> |

array(1, 2, 3)``array(array(1, 2), array(3, 4)) |

| MAP | map<string, string>``map<smallint, array<string>> |

map(“k1”, “v1”, “k2”, “v2”)``map(1S, array(‘a’, ‘b’), 2S, array(‘x’, ‘y’)) |

| STRUCT | struct<x:int, y:int>struct<field1:bigint, field2:array<int>, field3:map<int, int>> named_struct(‘x’, 1, ‘y’, 2)named_struct(‘field1’, 100L, ‘field2’, array(1, 2), ‘field3’, map(1, 100, 2, 200)) |

Hive有三种复杂数据类型ARRAY、MAP 和 STRUCT。ARRAY和MAP与Java中的Array和Map类似,而STRUCT与C语言中的Struct类似,它封装了一个命名字段集合,复杂数据类型允许任意层次的嵌套。还有一个uniontype< 所有类型,所有类型… > 。

数组:array< 所有类型 >;

Map < 基本数据类型,所有数据类型 >;

struct < 名:所有类型[注释] >;

uniontype< 所有类型,所有类型… >

1.3 Hive表的相关操作

Hive的存储格式:

Hive没有专门的数据文件格式,常见的有以下几种:

TEXTFILE

SEQUENCEFILE

AVRO

RCFILE

ORCFILE

PARQUET

注意:加粗的几种格式较为重要

TextFile:

TEXTFILE 即正常的文本格式,是Hive默认文件存储格式,因为大多数情况下源数据文件都是以text文件格式保存(便于查看验数和防止乱码)。此种格式的表文件在HDFS上是明文,可用hadoop fs -cat命令查看,从HDFS上get下来后也可以直接读取。

TEXTFILE 存储文件默认每一行就是一条记录,可以指定任意的分隔符进行字段间的分割。但这个格式无压缩,需要的存储空间很大。虽然可结合Gzip、Bzip2、Snappy等使用,使用这种方式,Hive不会对数据进行切分,从而无法对数据进行并行操作。

一般只有与其他系统由数据交互的接口表采用TEXTFILE 格式,其他事实表和维度表都不建议使用。

RCFile:

Record Columnar的缩写。是Hadoop中第一个列文件格式。能够很好的压缩和快速的查询性能。通常写操作比较慢,比非列形式的文件格式需要更多的内存空间和计算量。 RCFile是一种行列存储相结合的存储方式。首先,其将数据按行分块,保证同一个record在一个块上,避免读一个记录需要读取多个block。其次,块数据`列式存储`,有利于数据压缩和快速的列存取。

ORCFile:

Hive从0.11版本开始提供了ORC的文件格式,ORC文件不仅仅是一种列式文件存储格式,最重要的是有着很高的压缩比,并且对于MapReduce来说是可切分(Split)的。因此,在Hive中使用ORC作为表的文件存储格式,不仅可以很大程度的节省HDFS存储资源,而且对数据的查询和处理性能有着非常大的提升,因为ORC较其他文件格式压缩比高,查询任务的输入数据量减少,使用的Task也就减少了。ORC能很大程度的节省存储和计算资源,但它在读写时候需要消耗额外的CPU资源来压缩和解压缩,当然这部分的CPU消耗是非常少的。

Parquet:

通常我们使用关系数据库存储结构化数据,而关系数据库中使用数据模型都是扁平式的,遇到诸如数组、Map和自定义Struct的时候就需要用户在应用层解析。但是在大数据环境下,通常数据的来源是服务端的埋点数据,很可能需要把程序中的某些对象内容作为输出的一部分,而每一个对象都可能是嵌套的,所以如果能够原生的支持这种数据,这样在查询的时候就不需要额外的解析便能获得想要的结果。Parquet的灵感来自于2010年Google发表的Dremel论文,文中介绍了一种支持嵌套结构的存储格式,并且使用了列式存储的方式提升查询性能。Parquet仅仅是一种存储格式,它是语言、平台无关的,并且不需要和任何一种数据处理框架绑定。这也是parquet相较于orc的仅有优势:支持嵌套结构。Parquet 没有太多其他可圈可点的地方,比如他不支持update操作(数据写成后不可修改),不支持ACID等.

SEQUENCEFILE:

SequenceFile是Hadoop API 提供的一种二进制文件,它将数据以<key,value>的形式序列化到文件中。这种二进制文件内部使用Hadoop 的标准的Writable 接口实现序列化和反序列化。它与Hadoop API中的MapFile 是互相兼容的。Hive 中的SequenceFile 继承自Hadoop API 的SequenceFile,不过它的key为空,使用value 存放实际的值, 这样是为了避免MR 在运行map 阶段的排序过程。SequenceFile支持三种压缩选择:NONE, RECORD, BLOCK。 Record压缩率低,一般建议使用BLOCK压缩。 SequenceFile最重要的优点就是Hadoop原生支持较好,有API,但除此之外平平无奇,实际生产中不会使用。

AVRO:

Avro是一种用于支持数据密集型的二进制文件格式。它的文件格式更为紧凑,若要读取大量数据时,Avro能够提供更好的序列化和反序列化性能。并且Avro数据文件天生是带Schema定义的,所以它不需要开发者在API 级别实现自己的Writable对象。Avro提供的机制使动态语言可以方便地处理Avro数据。最近多个Hadoop 子项目都支持Avro 数据格式,如Pig 、Hive、Flume、Sqoop和Hcatalog。

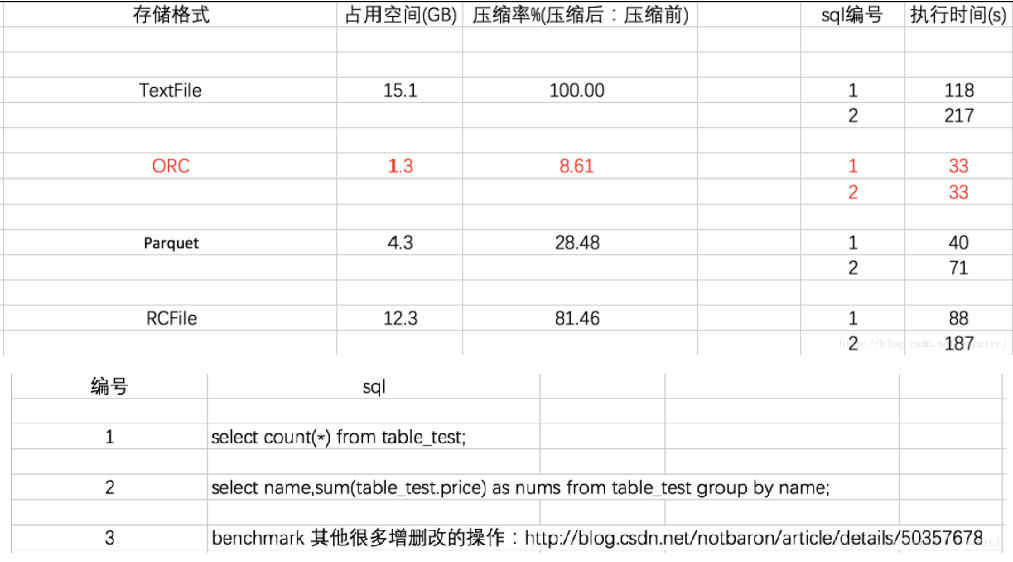

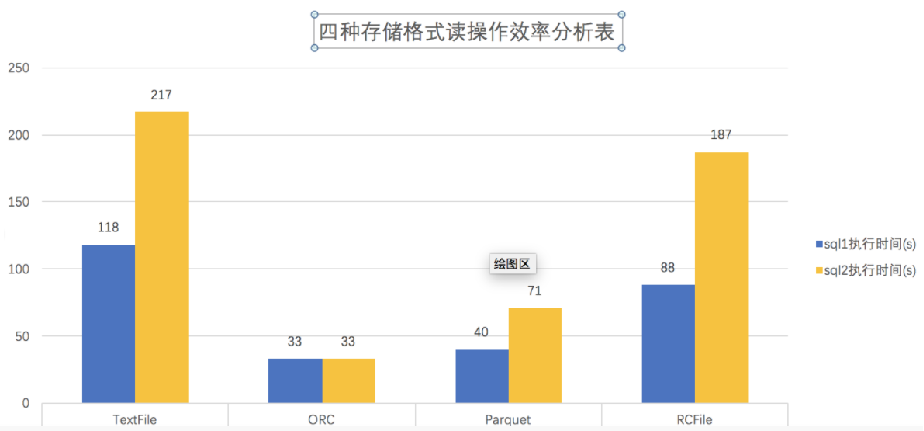

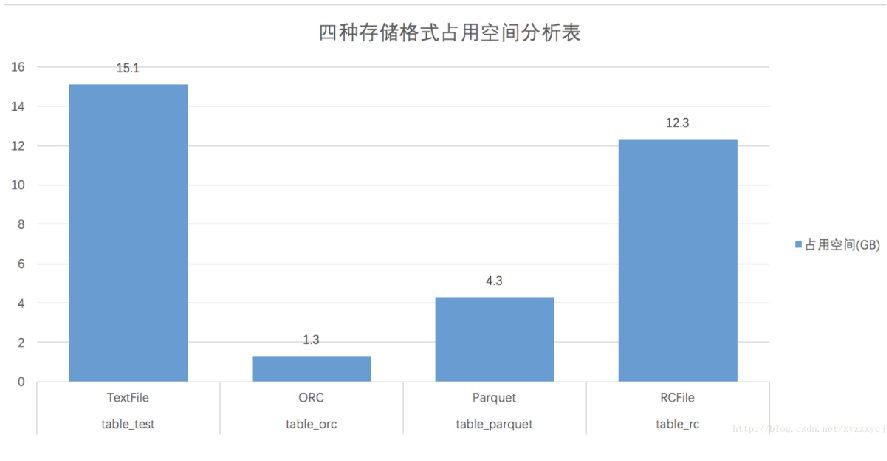

Hive的四大常用存储格式存储效率及执行速度对比

结论:ORCFILE存储文件读操作效率最高

耗时比较:ORC<Parquet<RC<Text

结论:ORCFILE存储文件占用空间少,压缩效率高

占用空间:ORC<Parquet<RC<Text

1.3.1 创建表

CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name

[(col_name data_type [COMMENT col_comment], ...)]

[COMMENT table_comment]

[PARTITIONED BY (col_name data_type [COMMENT col_comment], ...)]

[CLUSTERED BY (col_name, col_name, ...)

[SORTED BY (col_name [ASC|DESC], ...)] INTO num_buckets BUCKETS]

[ROW FORMAT row_format]

[STORED AS file_format]

[LOCATION hdfs_path]

字段解释说明:

- CREATE TABLE

创建一个指定名字的表。如果相同名字的表已经存在,则抛出异常;可以用 IF NOT EXISTS来忽略这个异常。

- EXTERNAL

关键字可以让用户创建一个外部表,在建表的同时指定一个指向实际数据的路径(LOCATION)

创建内部表时,会将数据移动到数据仓库指向的路径(默认位置);

创建外部表时,仅记录数据所在的路径,不对数据的位置做任何改变。在

删除表的时候,内部表的元数据和数据会被一起删除,而外部表只删除元数据,不删除数据。

- COMMENT:

为表和列添加注释。

- PARTITIONED BY

创建分区表

- CLUSTERED BY

创建分桶表

- SORTED BY

不常用

- ROW FORMAT

DELIMITED [FIELDS TERMINATED BY char] [COLLECTION ITEMS TERMINATED BY char] [MAP KEYS TERMINATED BY char] [LINES TERMINATED BY char] | SERDE serde_name [WITH SERDEPROPERTIES (property_name=property_value, property_name=property_value, ...)]

用户在建表的时候可以自定义SerDe或者使用自带的SerDe。

如果没有指定ROW FORMAT 或者ROW FORMAT DELIMITED,将会使用自带的SerDe。

在建表的时候,用户还需要为表指定列,用户在指定表的列的同时也会指定自定义的SerDe,Hive通过SerDe确定表的具体的列的数据。

SerDe是Serialize/Deserilize的简称,目的是用于序列化和反序列化。

- STORED AS指定存储文件类型

常用的存储文件类型:SEQUENCEFILE(二进制序列文件)、TEXTFILE(文本)、RCFILE(列式存储格式文件)

如果文件数据是纯文本,可以使用STORED AS TEXTFILE。

如果数据需要压缩,使用 STORED AS SEQUENCEFILE。

- LOCATION :

指定表在HDFS上的存储位置。

- LIKE

允许用户复制现有的表结构,但是不复制数据。

建表1:全部使用默认建表方式

create table students

(

id bigint,

name string,

age int,

gender string,

clazz string

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY '_'; // 必选,指定列分隔符

建表2:指定location (这种方式也比较常用)

create table IF NOT EXISTS students1

(

id bigint,

name string,

age int,

gender string,

clazz string

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY ','

// 使用这种方式建表,指定的HDFS上的路径就代表的是创建的数据库中的数据表

LOCATION '/hive_test/input1'; // 指定Hive表的数据的存储位置,一般在数据已经上传到HDFS,想要直接使用,会指定Location,通常Locaion会跟外部表一起使用,内部表一般使用默认的location

create table IF NOT EXISTS person_avg_counts

(

name string,

avg_count bigint

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t'

LOCATION '/hive_test/out4';

建表3:指定存储格式

create table IF NOT EXISTS test_orc_tb

(

id bigint,

name string,

age int,

gender string,

clazz string

)

ROW FORMAT DELIMITED FIELDS TERMINATED BY ','

STORED AS ORC

LOCATION '/hive_test/input2'; // 指定储存格式为orcfile,inputFormat:RCFileInputFormat,outputFormat:RCFileOutputFormat,如果不指定,默认为textfile,注意:除textfile以外,其他的存储格式的数据都不能直接加载,需要使用从表加载的方式。

建表4:create table xxxx as select_statement(SQL语句) (这种方式比较常用)

create table IF NOT EXISTS hive_test.students(id bigint,name string,age int,gender string,clazz string)ROW FORMAT DELIMITED FIELDS TERMINATED BY ',';

create table IF NOT EXISTS hive_test.xuqiu2(clazz string,number bigint)ROW FORMAT DELIMITED FIELDS TERMINATED BY ',';

insert into students3_1 values(1002,'张三',19,'男','hive训练营');

create table students4 as select * from students2;

建表5:create table xxxx like table_name 只想建表,不需要加载数据

create table students5 like students;

标签:存储,string,create,数据仓库,建模,hive,Hive,name From: https://www.cnblogs.com/shmil/p/18308463简单用户信息表创建:

create table t_user( id int, uname string, pwd string, gender string, age int ) row format delimited fields terminated by ',' lines terminated by '\n';1,admin,123456,男,18 2,zhangsan,abc123,男,23 3,lisi,654321,女,16复杂人员信息表创建:

create table IF NOT EXISTS t_person( name string, friends array<string>, children map<string,int>, address struct<street:string ,city:string> ) row format delimited fields terminated by ',' -- 列与列之间的分隔符 collection items terminated by '_' -- 元素与元素之间分隔符 map keys terminated by ':' -- Map数据类型键与值之间的分隔符 lines terminated by '\n'; -- 行与行之间的换行符songsong,bingbing_lili,xiao song:18_xiaoxiao song:19,beng bu_anhui yangyang,caicai_susu,xiao yang:18_xiaoxiao yang:19,he fei_anhui