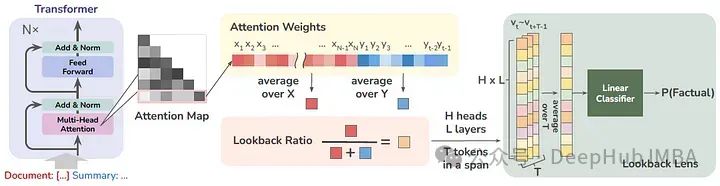

在总结文章或回答给定段落的问题时,大语言模型可能会产生幻觉,并会根据给定的上下文回答不准确或未经证实的细节,这也被称为情境幻觉。为了解决这个问题,这篇论文的作者提出了一个简单的幻觉检测模型,其输入特征由上下文的注意力权重与新生成的令牌(每个注意头)的比例给出。它被称为回看或基于回看比率的检测器。

该方法计算为给定上下文的注意力权重与新生成的令牌的比值。在每个时间步,计算每个注意头的回看率,并训练一个线性分类器,称之为Lookback Lens,根据回看率特征检测上下文幻觉,如下图所示

在解码过程中可以进一步整合该检测器,获得可减少幻觉的回看透镜引导解码策略

https://avoid.overfit.cn/post/0c18bed0b5b0466984c2ff8ec5a70283

标签:检测,Lookback,Lens,llm,幻觉,上下文,注意力 From: https://www.cnblogs.com/deephub/p/18297967