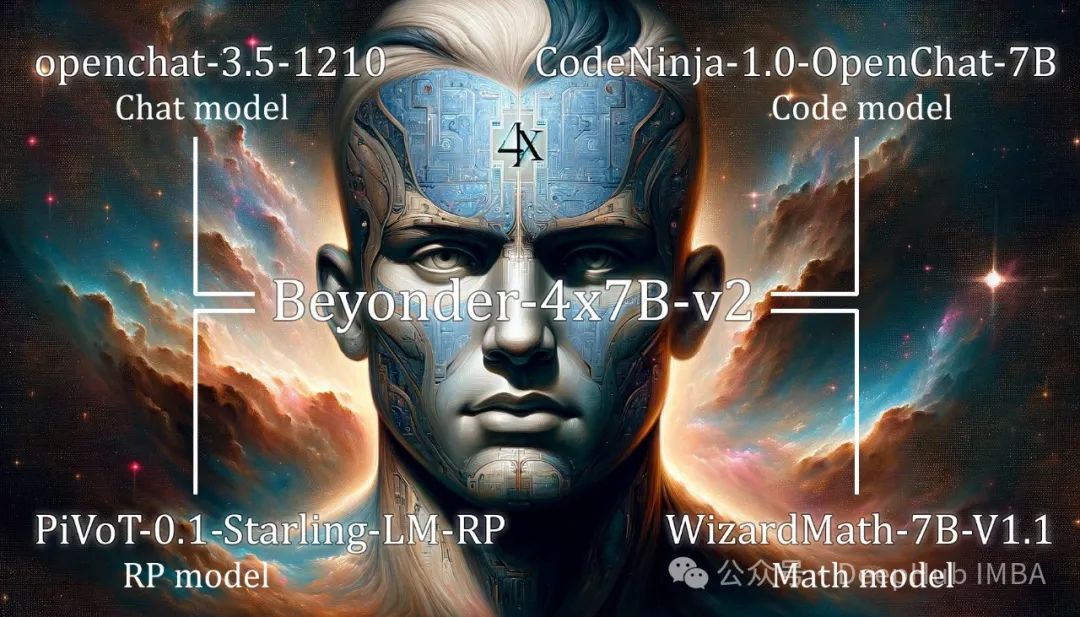

由于Mixtral的发布,专家混合(MoE)架构在最近几个月变得流行起来。虽然Mixtral和其他MoE架构是从头开始预训练的,但最近出现了另一种创建MoE的方法:Arcee的MergeKit库可以通过集成几个预训练模型来创建moe。这些人通常被称为frankenMoEs或MoErges,以区别于预先训练的MoEs。

在本文中,我们将详细介绍MoE架构是如何工作的,以及如何创建frankenmoe。最后将用MergeKit制作自己的frankenMoE,并在几个基准上对其进行评估。

https://avoid.overfit.cn/post/b3588f09e1794b3f8edde5a07b2c270a

标签:架构,创建,模型,MergeKit,Mixtral,MoE From: https://www.cnblogs.com/deephub/p/18103532