这是一篇2022由纽约州立大学布法罗分校和Meta AI发布的论文,它主要的观点如下:

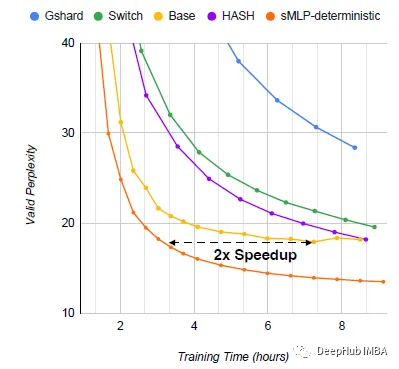

具有专家混合(MoEs)的稀疏激活mlp在保持计算常数的同时显着提高了模型容量和表达能力。此外gMLP表明,所有mlp都可以在语言建模方面与transformer相匹配,但在下游任务方面仍然落后。所以论文提出了sMLP,通过设计确定性路由和部分预测来解决下游任务方面的问题。

https://avoid.overfit.cn/post/92556271c70242719a322ad2788f4066

标签:高效,sMLP,语言,建模,稀疏,mlp From: https://www.cnblogs.com/deephub/p/17833149.html