大型语言模型(llm)在今年发展迅速,随着新一代模型不断地被开发,研究人员和工程师了解最新进展变得非常重要。本文总结9-10月期间发布了一些重要的LLM论文。

这些论文涵盖了一系列语言模型的主题,从模型优化和缩放到推理、基准测试和增强性能。最后部分讨论了有关安全训练并确保其行为保持有益的论文。

优化与扩展

Large Language Model Cascades with Mixture of Thoughts Representations for Cost-efficient Reasoning

https://arxiv.org/abs/2310.03094

像GPT-4这样的大型语言模型(llm)在各种任务中表现出了卓越的性能,但是这种强大的性能通常伴随着使用付费API服务的高昂费用。

在本文中,作者研究了构建LLM级联以节省使用LLM的成本,特别是用于执行推理(例如,数学,因果关系)任务。

级联管道遵循的理论是,简单的问题可以通过较弱但更实惠的LLM来解决,而只有具有挑战性的问题才需要更强大且更昂贵的LLM。

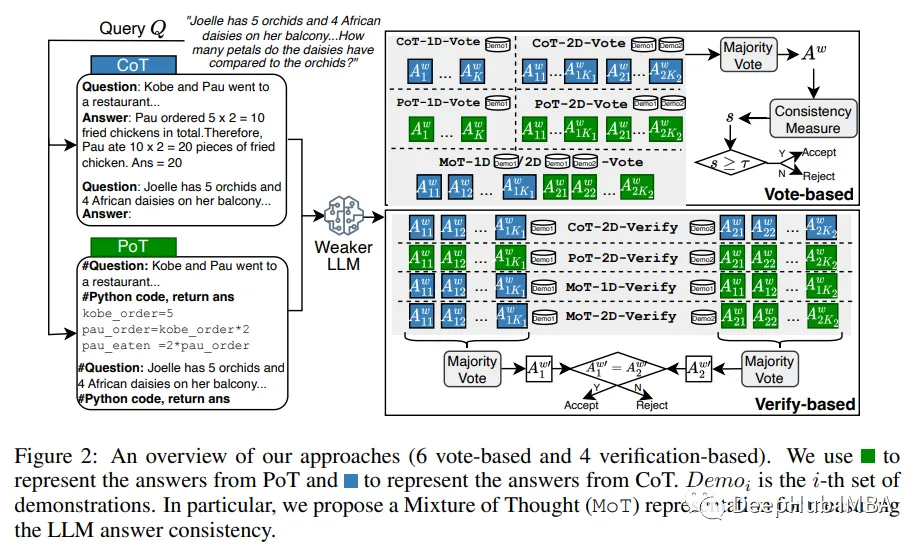

为了实现这一决策,他们将较弱LLM的“答案一致性”视为问题难度的信号,并提出了几种答案抽样和一致性检查方法,包括一种利用两种思维表示(即Chain-of-Thought 和 Program-of-Thought)的混合方法。

通过在六个推理基准数据集上的实验,分别使用gpt -3.5 turbo和GPT-4作为较弱和较强的LLM,证明提出的LLM级联可以达到与单独使用较强LLM相当的性能,而成本仅为其40%。

https://avoid.overfit.cn/post/fe5635accd16437aa7b4b6d7f2eea43f

标签:总结,级联,语言,模型,论文,LLM,推理 From: https://www.cnblogs.com/deephub/p/17765296.html