一、ELK日志分析系统简介

1、日志服务器的优缺点

优点: 提高安全性 集中存放日志 缺点: 对日志的分析困难

2、ELK

日志简化分析的管理工具,由Elasticsearch(ES)、Logstash、Kibana三个开源工具组成,官方网站: https://www.elastic.co/products

-

ES(nosql非关数据库):存储功能和索引

-

Logstash(收集日志):到应用服务器上拿取log,并进行格式转换后输出到es中 通过input功能来收集/采集log

-

filter过滤器:格式化数据

-

output输出:日志输出到es数据库内

-

Kibana(展示工具):将es内的数据在浏览器展示出来,通过UI界面展示(可以根据自己的需求对日志进行处理,方便查阅读取)

2.1Logstash管理包含四种工具

-

Packetbeat ( 搜集网络流量数据)

-

Topbeat(搜集系统、进程和文件系统级别的CPU和内存使用情况等数据)

-

Filebeat (搜集文件数据),相较于Logstash是轻量级工具

-

Winlogbeat (搜集Windows事件日志数据)

2.2、日志处理步骤

-

Logstash收集AppServer产生的Log,并将log进行集中化管理

-

将日志格式化(Logstash) 并存放到ElasticSearch集群中

-

对格式化后的数据进行索引|和存储( Elasticsearch)

-

Kibana则从Es集群中查询数据生成图表,再返回给browsers

3、Elasticsearch的基础核心概念

-

接近实时(NRT) elasticsearch是一个接近实时的搜索平台,这意味着,从索引一个文档直到这个文档能够被搜索到有一个轻微的延迟(通常是1秒)

-

集群(cluster) 一个集群就是由一个或多个节点组织在一起,它们共同持有整个的数据,并一起提供索引和搜索功能。其中一个节点为主节点,这个主节点是可以通过选举产生的,并提供跨节点的联合索引和搜索的功能。集群有一个唯一性标示的名字,默认是elasticsearch 集群名字很重要,每个节点是基于集群名字加入到其集群中的。因此,确保在不同环境中使用不同的集群名字。一个集群可以只有一个节点。强烈建议在配置elasticsearch时, 配置成集群模式。es 具有集群机制,节点通过集群名称加入到集群中,同时在集群中的节点会有一个自己的唯一 身份标识(自己的名称)

-

节点(node) 节点就是一台单一的服务器,是集群的一部分,存储数据并参与集群的索引和搜索功能。像集群一样,节点也是通过名字来标识,默认是在节点启动时随机分配的字符名。当然,你可以自己定义。该名字也很重要,在集群中用于识别服务器对应的节点。

-

索引 一个索引就是一个拥有积分相似特征的文档的集合,由一个名字来标识(必须全部是小写字母),索引相对于关系型数据库的库

-

类型 在一个索引种,可以定义一种或多种类型,一个类型是索引的一个逻辑上的分类/分区,其语义完全自定义。类型相对于关系型数据库的表

-

文档 一个文档是一个可被索引的基础信息单元,文档相对于关系型数据库的列

-

分片和副本 ①分片的主要原因 a:水平分割扩展、增大存储量 b:分布式并行分片操作,提高性能和吞吐量 ②副本的主要原因 a: 高可用性,以应对分片或节点故障 b: qps性能、增大吞吐量,搜索可以并行在所有副本上执行 ③分片和副本的数量可以在索引创建的时候指定,在索引创建之后,可以动态地改变副本的数量,但是不能改变分片的数量

4、logstash介绍

4.1 主要组件

-

Shipper:日志收集者 负责监控本地日志文件的变化,及时把日志文件的最新内容收集起来。通常,远程代理端(agent) 只需要运行这个组件

-

Indexer:日志存储者 负责接收日志并写入到本地文件

-

Broker:日志Hub 负责连接多个Shipper和多个Indexer

-

Searchandstorage 允许对事件进行搜索和存储

-

Web Interface 基于Web的展示界面

正是由于以上组件在LogStash架构中可独立部署,才提供了更好的集群扩展性

4.2 主机分类

-

代理主机(agent host) :作为事件的传递者(shipper),将各种日志数据发送至中心主机;只需运行Logstash 代理(agent)程序;

-

中心主机(central host) :可运行包括中间转发器(Broker)、索引器(Indexer) 、搜索和存储器(Search and Storage )

Web界面端“(Web Interface) 在内的各个组件,以实现对日志数据的接收、处理和存储

5、Kibana介绍

Kibana是一个 针对Elasticsearch的开源分析及可视化平台,用来搜索、查看交互存储在Elasticsearch索引中的数据。 使用Kibana,可以通过各种图表进行高级数据分析及展示。Kibana让海量数据更容易理解。它操作简单,基于浏览器的用户界面可以快速创建仪表板(dashboard) 实时显示Elasticsearch查询动态。设置Kibana非常简单。无需编写代码,几分钟内就可 以完成Kibana安装并启动Elasticsearch索引监测。

主要功能:

-

Elasticsearch无缝之集成。Kibana架构为Elast icsearch定制, 可以将任何结构化和非结构化数据加入Elast icsearch索引。Kibana还充分利用了Elasticsearch强大的搜索和分析功能。

-

整合你的数据。Kibana能够更好地处理海量数据,并据此创建柱形图、折线图、散点图、直方图、饼图和地图。

-

复杂数据分析。Kibana提升了Elasticsearch分析能力,能够更加智能地分析数据,执行数学转换并且根据要求对数据切割分块

-

让更多团队成员受益。强大的数据库可视化接口让各业务岗位都能够从数据集合受益。

-

接口灵活,分享更容易。使用Kibana可以更加方便地创建、保存、分享数据,并将可视化数据快速交流。

-

配置简单。Kibana的配置和启用非常简单,用户体验非常友好。Kibana自带Web服务器,可以快速启动运行。

-

可视化多数据源。Kibana可 以非常方便地把来自Logstash、ES-Hadoop、 Beats或第三方技术的数据整合到Elasticsearch,支持的第三方技术包括Apache Flume、 Fluentd等

-

简单数据导出。Kibana可以方便地导出感兴趣的数据,与其它数据集合并融合后快速建模分析,发现新结果。

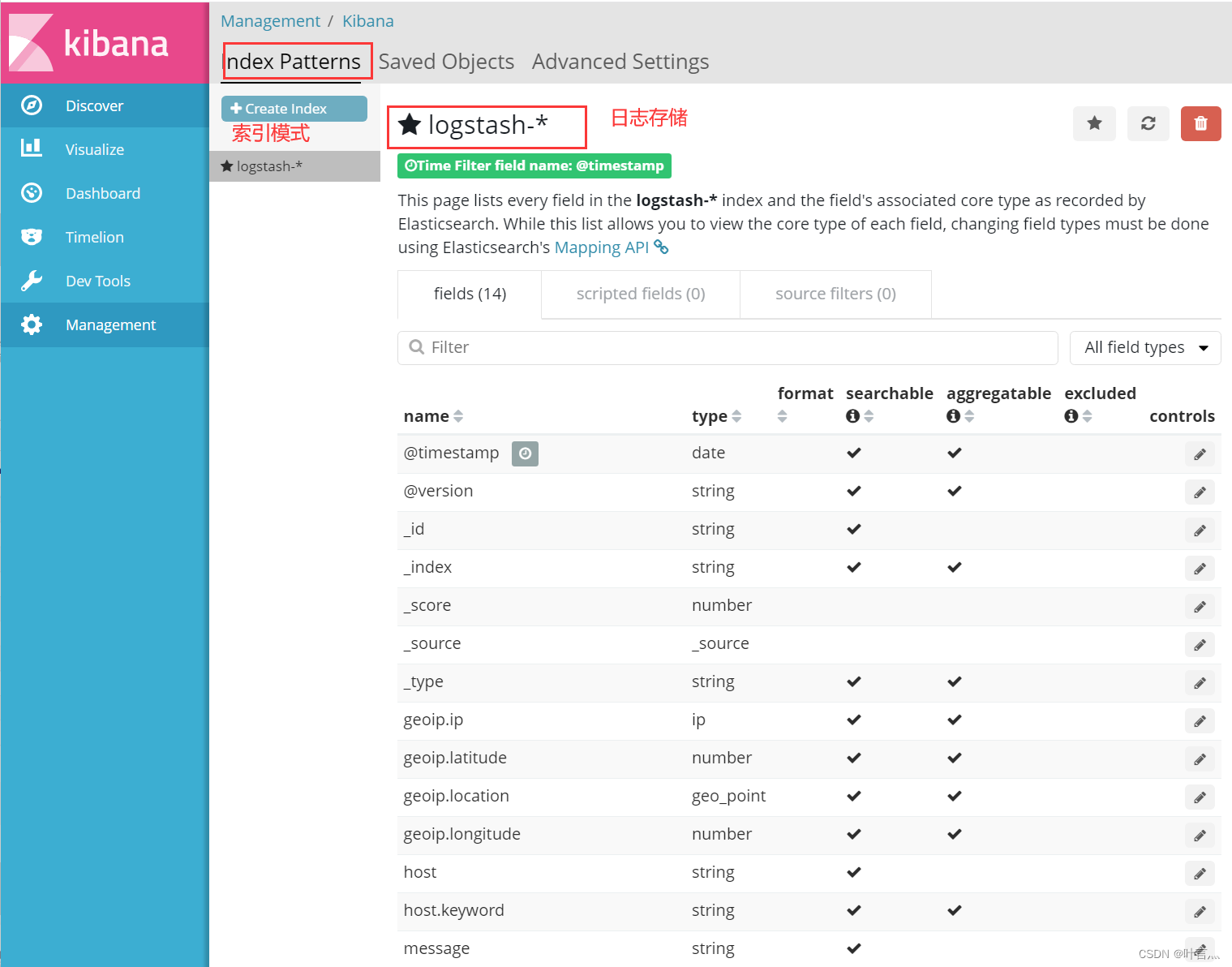

二、配置ELK日志分析系统

1、Elasticsearch集群部署(Node1上操作)

node1节点:192.168.127.130

node2节点:192.168.127.140

apache节点:192.168.127.199

Elasticsearch包下载地址

https://www.elastic.co/cn/downloads/past-releases/elasticsearch-5-5-0

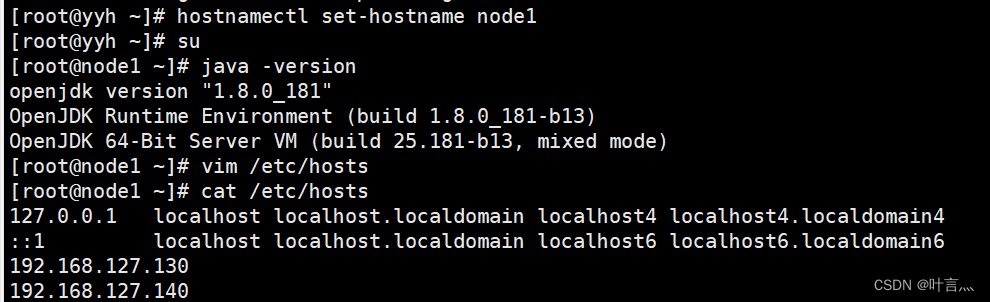

1.1准备环境

更改主机名,,配置域名解析,查看java环境

hostnamectl set-hostname node1

bash

systemctl stop firewalld

setenforce 0

vim /etc/hosts

192.168.127.130 node1

192.168.127.140 node2

java –version

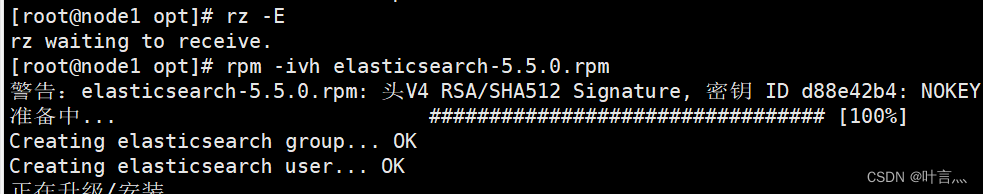

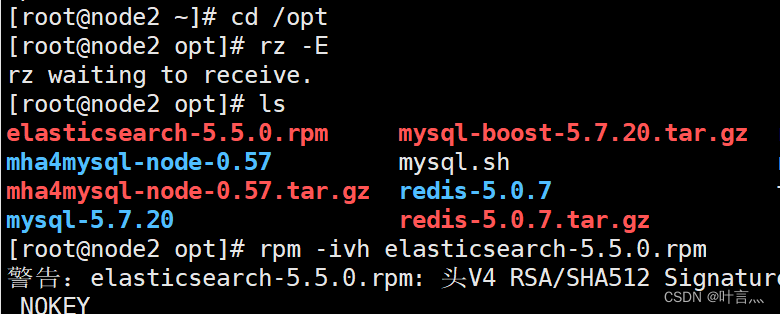

1.2、部署安装Elasticsearch组件

rpm -ivh elasticsearch-5.5.0.rpm

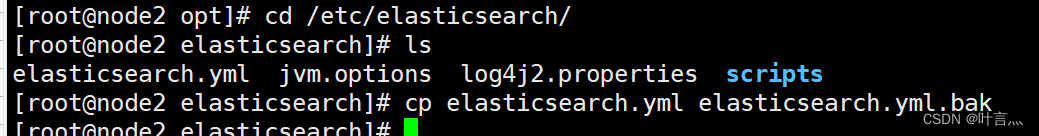

cd /etc/elasticsearch/

cp elasticsearch.yml elasticsearch.yml.bak

rpm -ivh elasticsearch-5.5.0.rpm

cd /etc/elasticsearch/

cp elasticsearch.yml elasticsearch.yml.bak

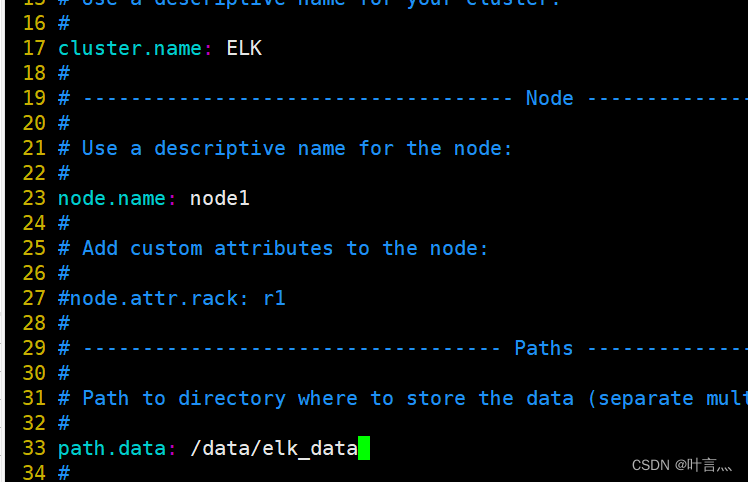

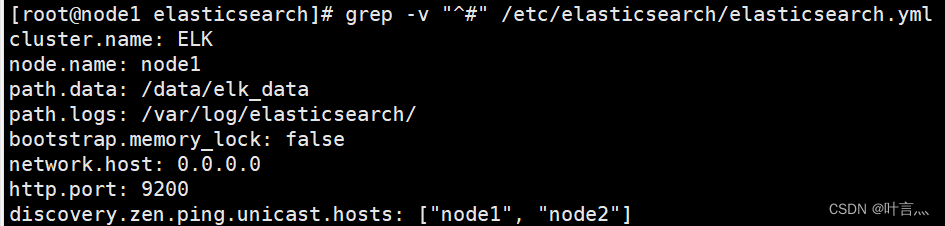

1.3、配置Elasticsearch主配置文件

vim /etc/elasticsearch/elasticsearch.yml

--17--取消注释,指定集群名字

cluster.name: zhang

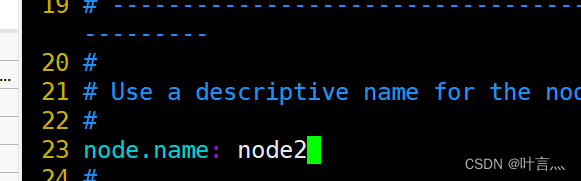

--23--取消注释,指定节点名字:Node1节点为node1,Node2节点为node2

node.name: node1

--33--取消注释,指定数据存放路径

path.data: /data/elk_data

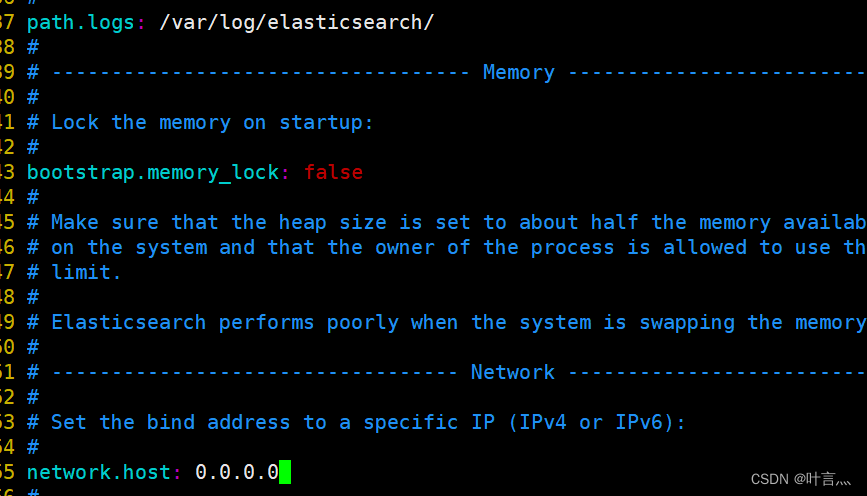

--37--取消注释,指定日志存放路径

path.logs: /var/log/elasticsearch/

--43--取消注释,改为在启动的时候不锁定内存

bootstrap.memory_lock: false

--55--取消注释,设置监听地址,0.0.0.0代表所有地址

network.host: 0.0.0.0

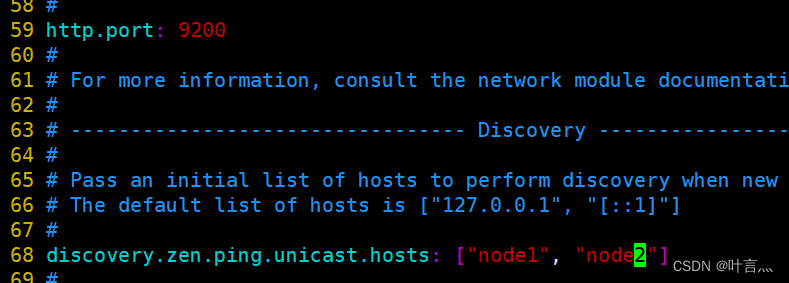

--59--取消注释,ES 服务的默认监听端口为9200

http.port: 9200

--68--取消注释,集群发现通过单播实现,指定要发现的节点 node1、node2

discovery.zen.ping.unicast.hosts: ["node1", "node2"]

grep -v "^#" /etc/elasticsearch/elasticsearch.yml #查看一下有效的配置,注释全去掉

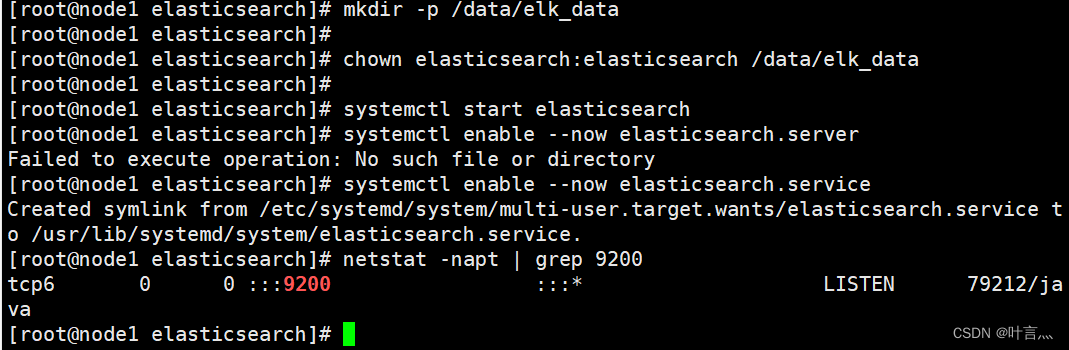

1.4、创建数据存放路径并授权

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data

systemctl start elasticsearch

systemctl enable --now elasticsearch.service

netstat -napt | grep 9200

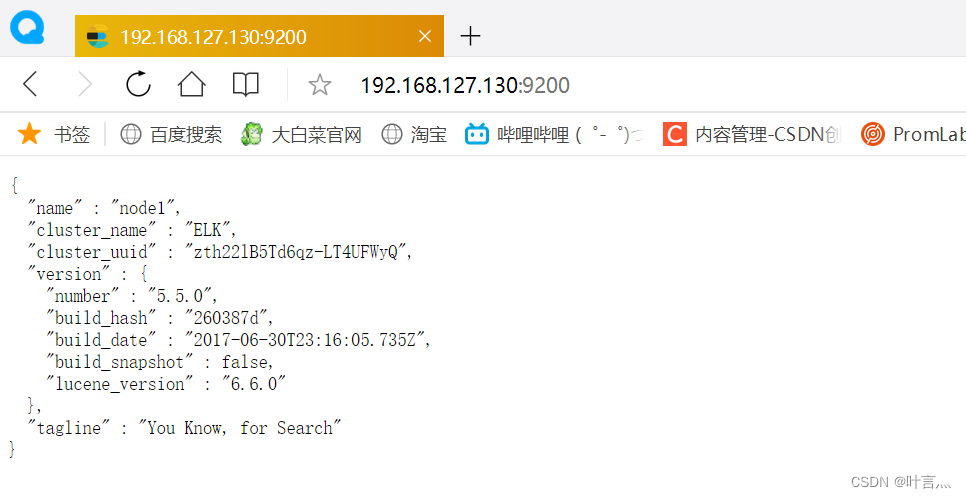

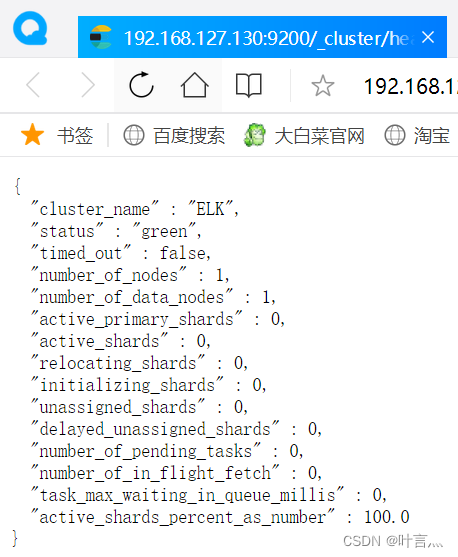

1.5、查看node1节点信息

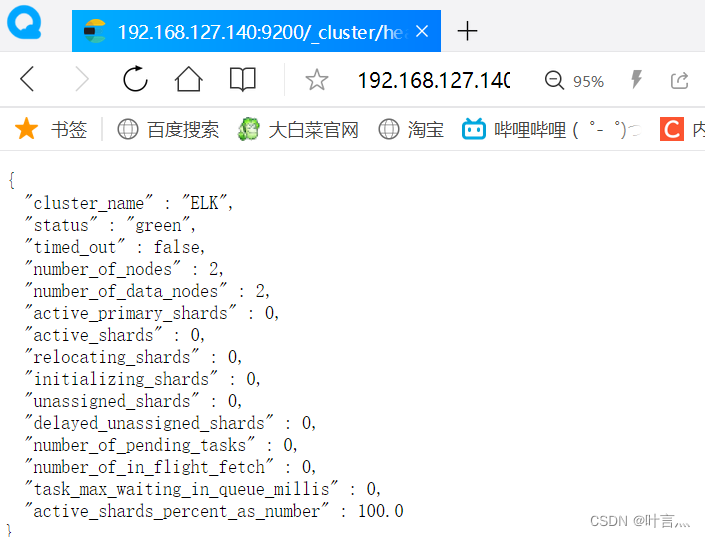

http://192.168.127.130:9200/_cluster/health?pretty

#查看健康状态

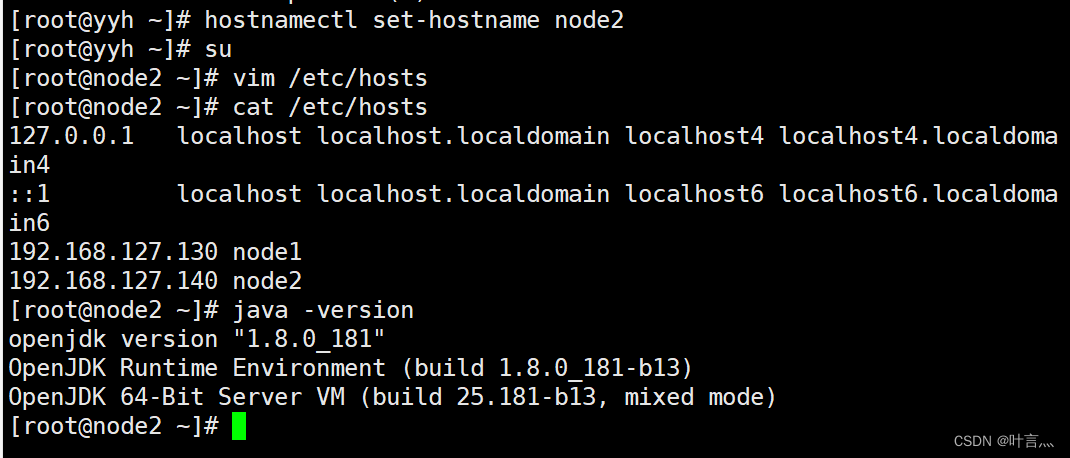

2、Elasticsearch集群部署(在node2上操作)

2.1、配置与node1一致

配置node2与node1一致,需要注意配置文件中的节点名

2.2、将node1节点的配置文件上传到node2上

其余配置跟node1一样

2.3、创建数据存放路径并授权

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

systemctl daemon-reload

systemctl enable --now elasticsearch.service

systemctl start elasticsearch

netstat -antp | grep 9200

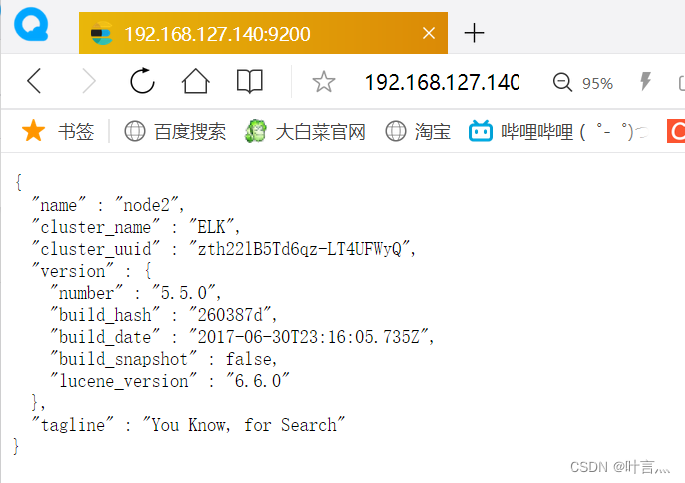

2.4、查看node2节点信息

3、安装Elasticsearch-head插件(node1和node2节点操作一样)

Elasticsearch 在 5.0 版本后,Elasticsearch-head 插件需要作为独立服务进行安装,需要使用npm工具(NodeJS的包管理工具)安装。 安装 Elasticsearch-head 需要提前安装好依赖软件 node 和 phantomjs。

node:是一个基于 Chrome V8 引擎的 JavaScript 运行环境。 phantomjs:是一个基于 webkit 的JavaScriptAPI,可以理解为一个隐形的浏览器,任何基于 webkit 浏览器做的事情,它都可以做到。

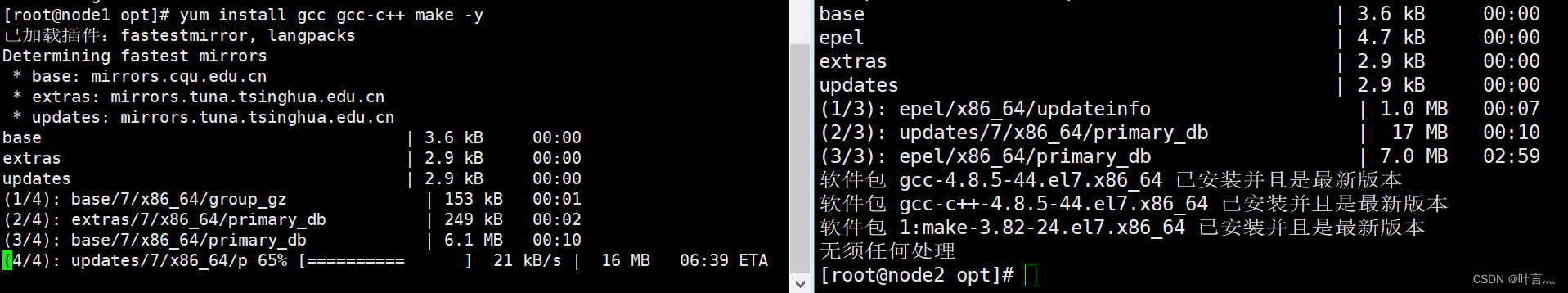

3.1编译安装node

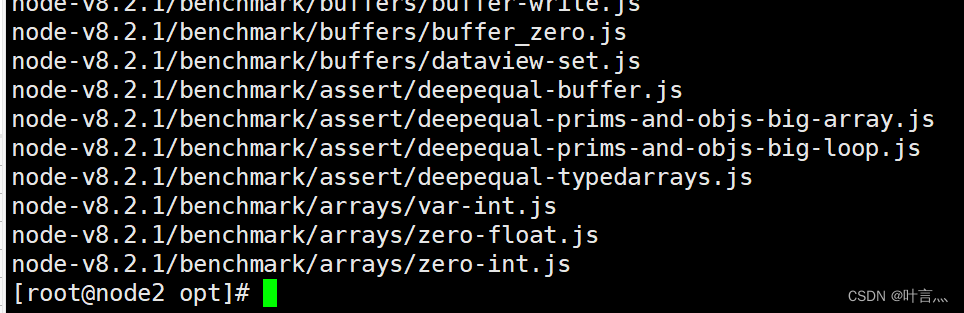

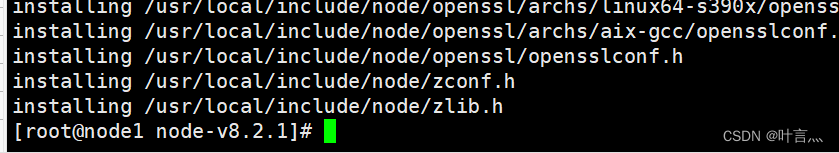

上传软件包 node-v8.2.1.tar.gz 到/opt yum install gcc gcc-c++ make -y cd /opt tar zxvf node-v8.2.1.tar.gz cd node-v8.2.1/ ./configure make && make install

3.2安装phantomjs

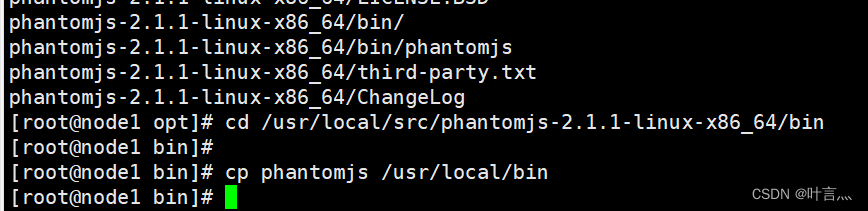

上传软件包 phantomjs-2.1.1-linux-x86_64.tar.bz2到opt cd /opt tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/local/src/ cd /usr/local/src/phantomjs-2.1.1-linux-x86_64/bin cp phantomjs /usr/local/bin

3.3安装Elasticsearch-head数据可视化工具

3.3安装Elasticsearch-head数据可视化工具

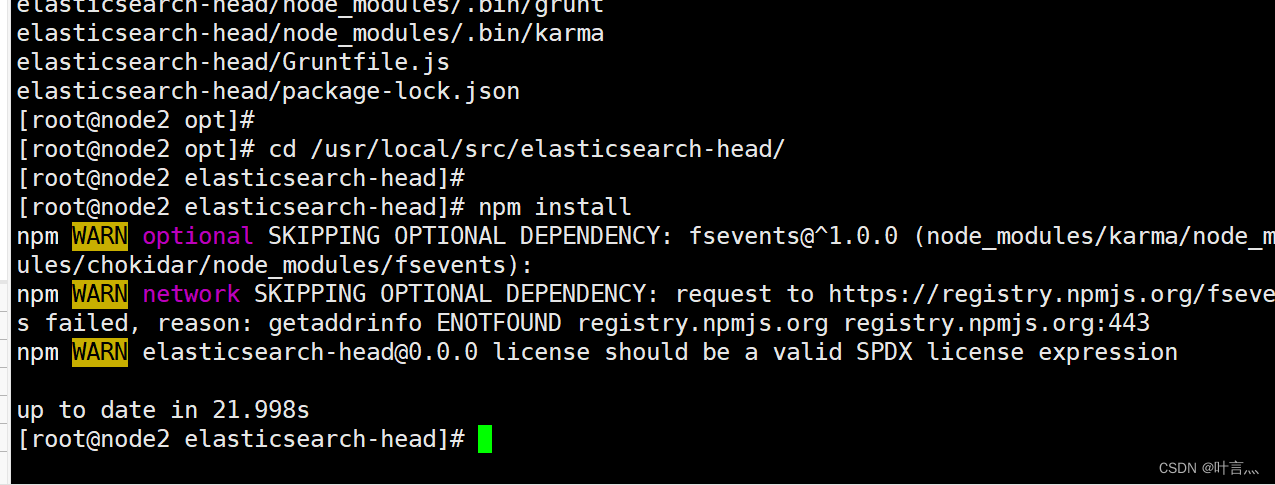

上传软件包 elasticsearch-head.tar.gz 到/opt cd /opt tar zxvf elasticsearch-head.tar.gz -C /usr/local/src/ cd /usr/local/src/elasticsearch-head/ npm install

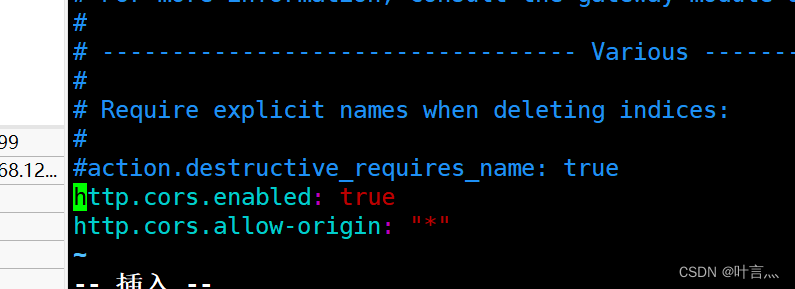

3.4修改Elasticsearch主配置文件

systemctl restart elasticsearch #重启服务

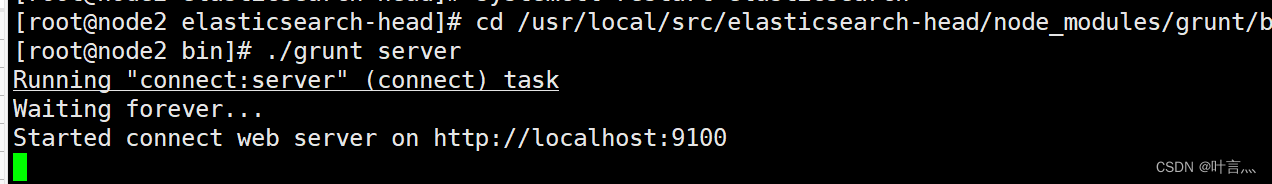

3.5、启动elasticsearch-head服务

cd /usr/local/src/elasticsearch-head/node_modules/grunt/bin ./grunt server #前台启动

3.6通过Elasticsearch-head查看Elasticsearch信息

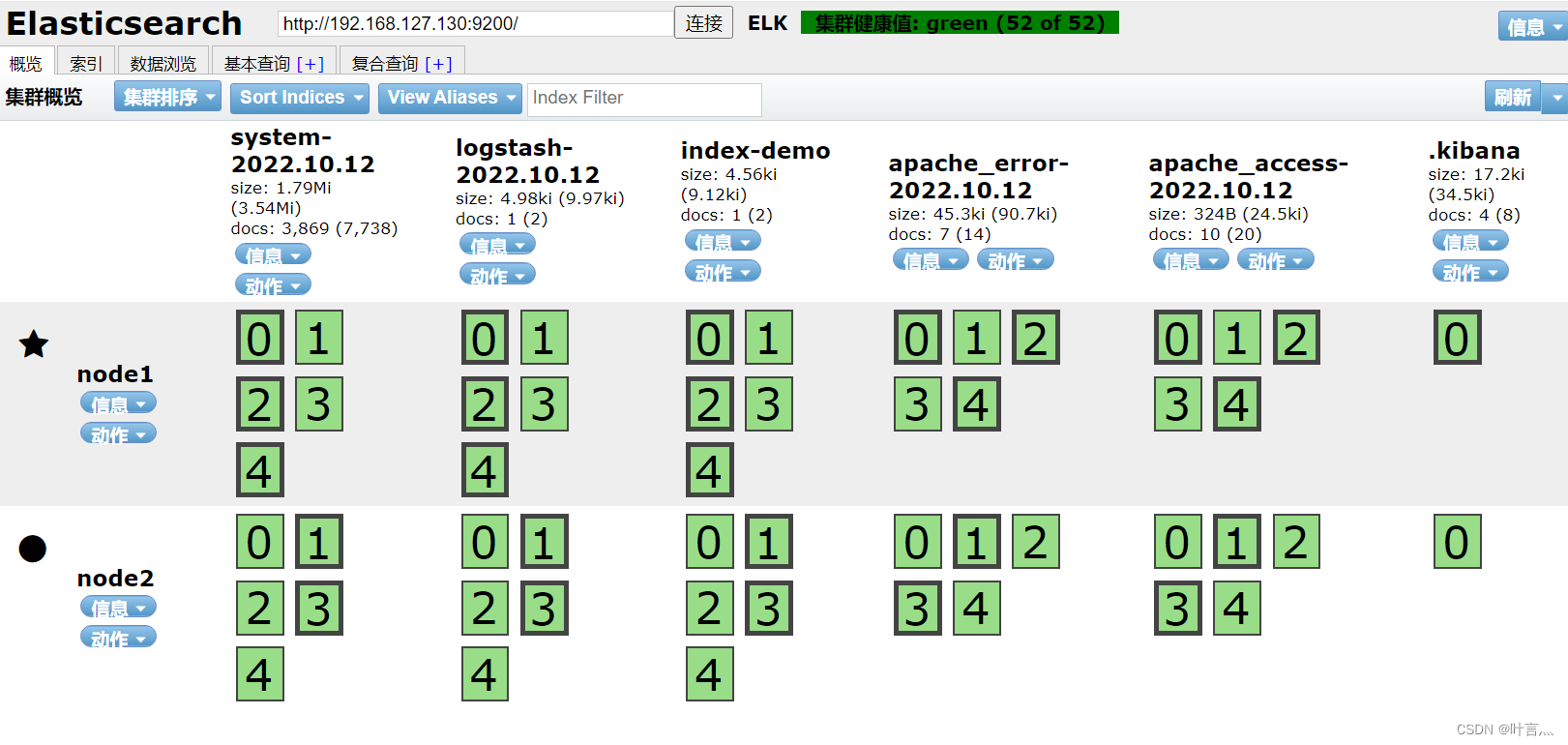

浏览器访问 http://192.168.127.130:9100/ 地址并连接群集。如果看到群集健康值为 green 绿色,代表群集很健康。

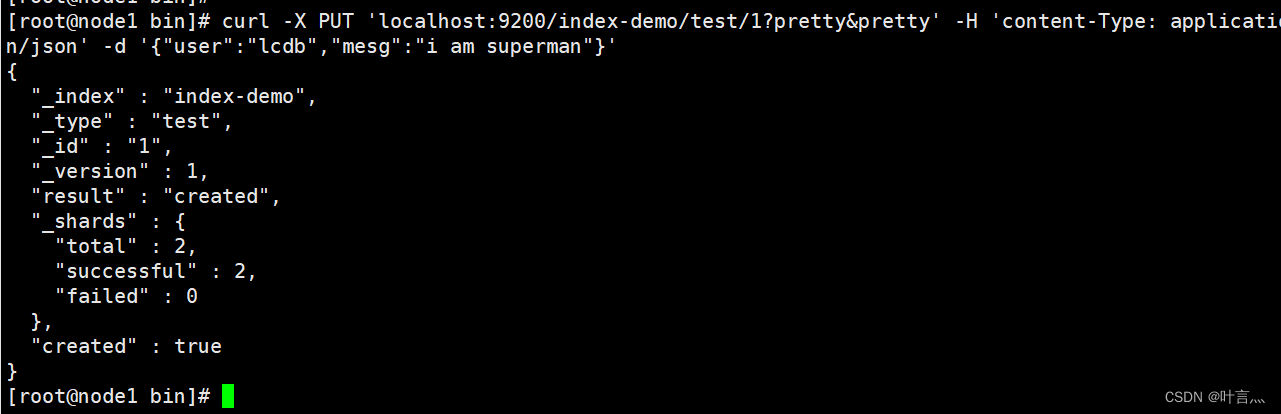

3.7、插入索引,进行测试

3.7、插入索引,进行测试

#node1节点插入

curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"lcdb","mesg":"i am superman"}'

浏览器访问 http://192.168.127.130.9100/ 查看索引信息,可以看见索引默认被分片5个,并且有一个副本。 点击“数据浏览”,会发现在node1上创建的索引为 index-demo,类型为 test 的相关信息。

4、Logstash部署(192.168.127.199)

下载地址:https://www.elastic.co/cn/downloads/past-releases/logstash-5-5-1

Logstash 一般部署在需要监控其日志的服务器。在本案例中,Logstash 部署在 Apache 服务器上,用于收集 Apache 服务器的日志信息并发送到 Elasticsearch。

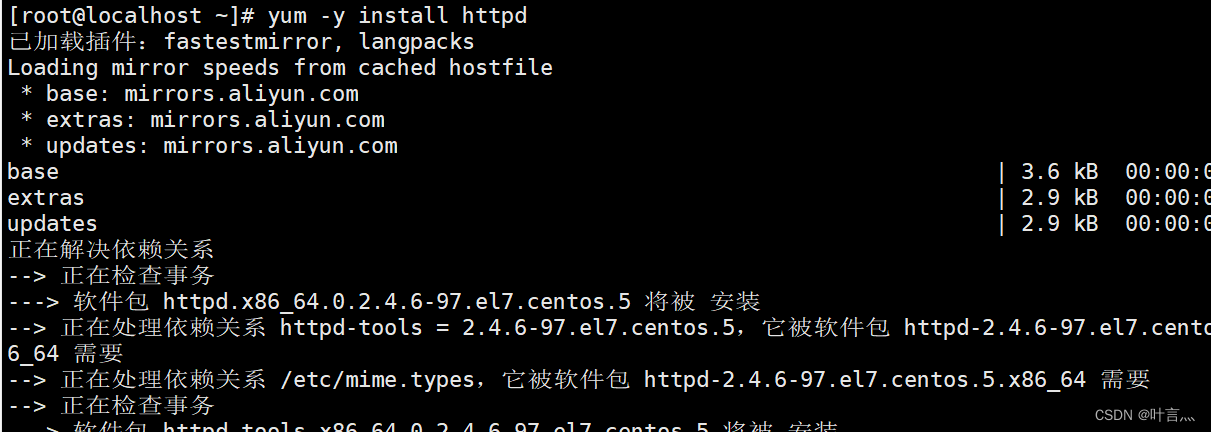

4.1安装httpd服务

yum -y install httpd systemctl start httpd

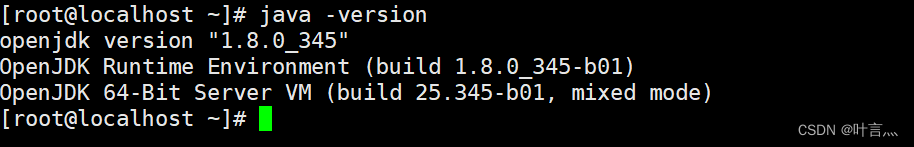

4.2安装java环境

yum -y install java java –version

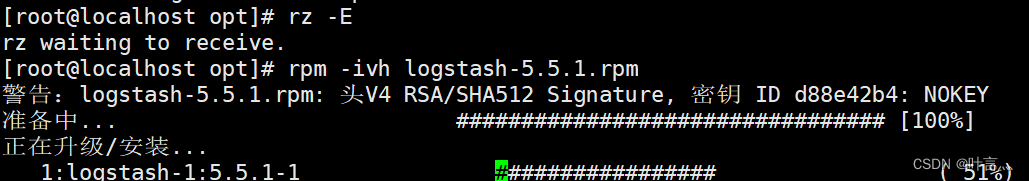

4.3安装logstash

4.3安装logstash

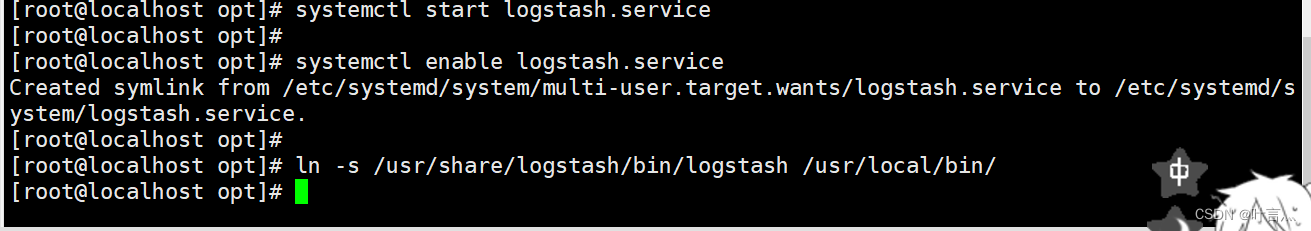

cd /opt rpm -ivh logstash-5.5.1.rpm systemctl start logstash.service systemctl enable logstash.service ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

4.4测试Logstash

Logstash命令常用选项

-f:通过这个选项可以指定 Logstash 的配置文件,根据配置文件配置 Logstash 的输入和输出流。 -e:从命令行中获取,输入、输出后面跟着字符串,该字符串可以被当作 Logstash 的配置(如果是空,则默认使用 stdin 作为输入,stdout 作为输出)。 -t:测试配置文件是否正确,然后退出。

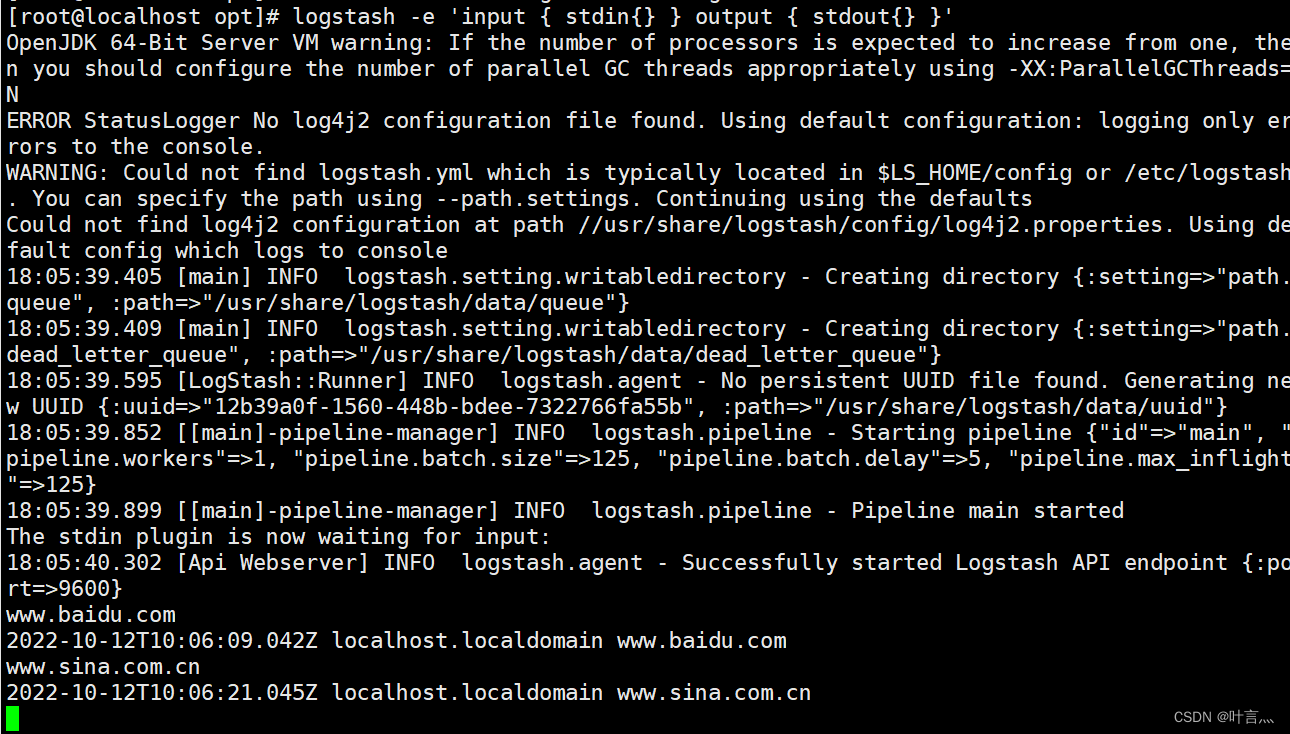

定义输入输出流

输入采用标准输入,输出采用标准输出(类似管道) 指定数据输入端口,默认为9600~9700

logstash -e 'input { stdin{} } output { stdout{} }'

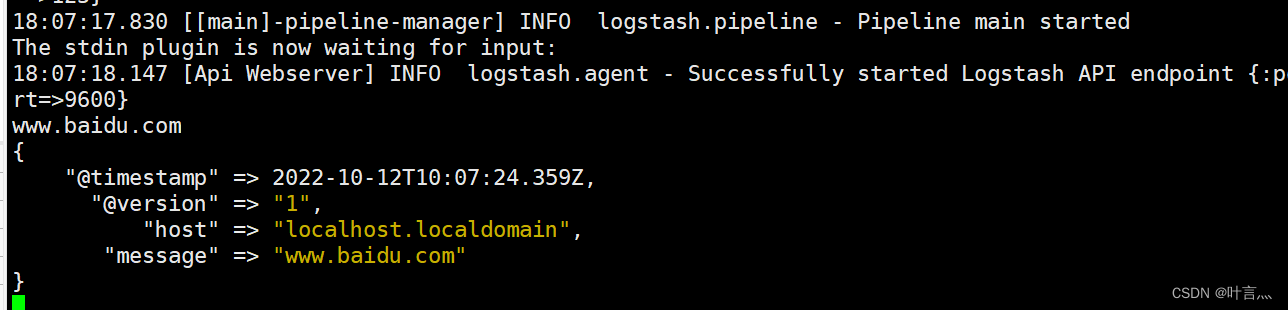

使用runydebug输出详细格式显示,codec为一种编解码器

logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

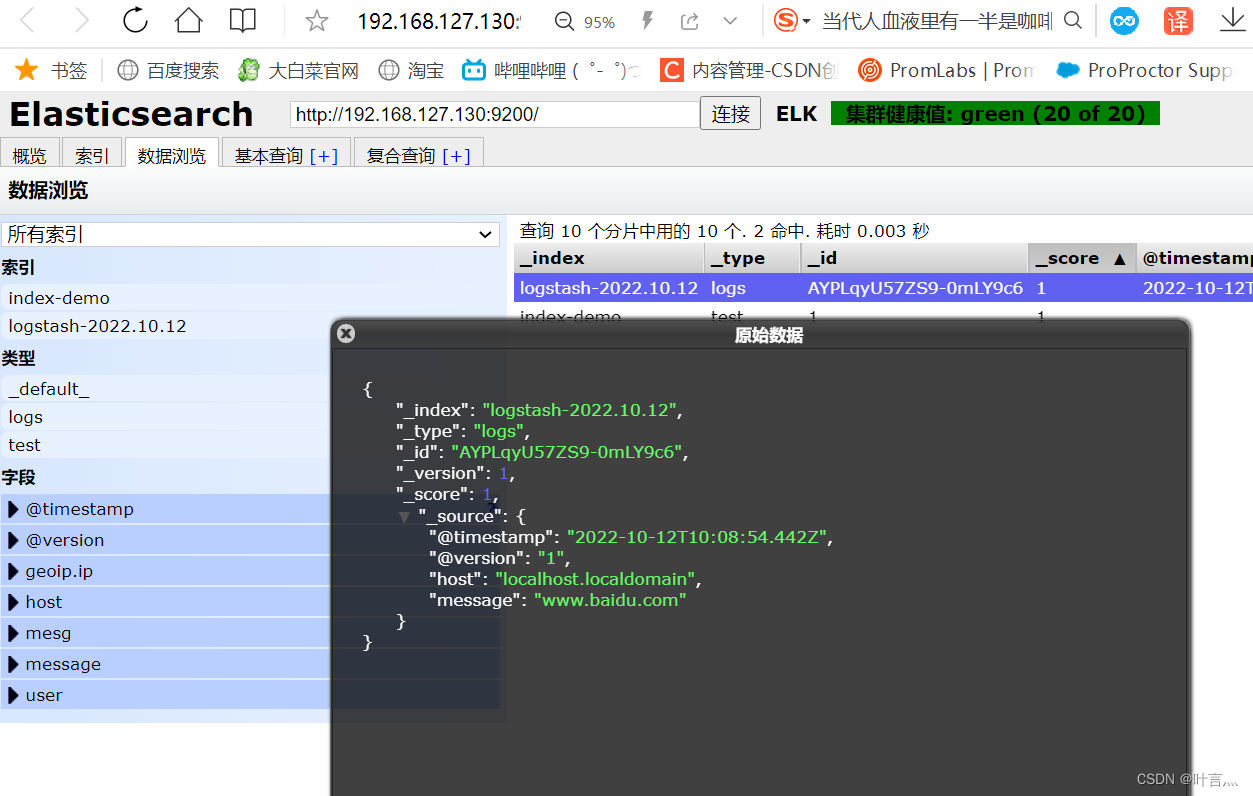

使用Logstash将信息写入Elasticsearch中

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.127.130:9200"] } }'

结果不在标准输出显示,而是发送至 Elasticsearch 中,可浏览器访问 http://192.168.127.130:9100/ 查看索引信息和数据浏览。

4.5定义logstash配置文件

Logstash 配置文件基本由三部分组成(根据需要选择使用)

-

input:表示从数据源采集数据,常见的数据源如Kafka、日志文件等

-

filter:表示数据处理层,包括对数据进行格式化处理、数据类型转换、数据过滤等,支持正则表达式

-

output:表示将Logstash收集的数据经由过滤器处理之后输出到Elasticsearch。

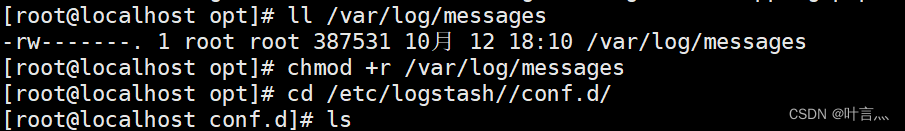

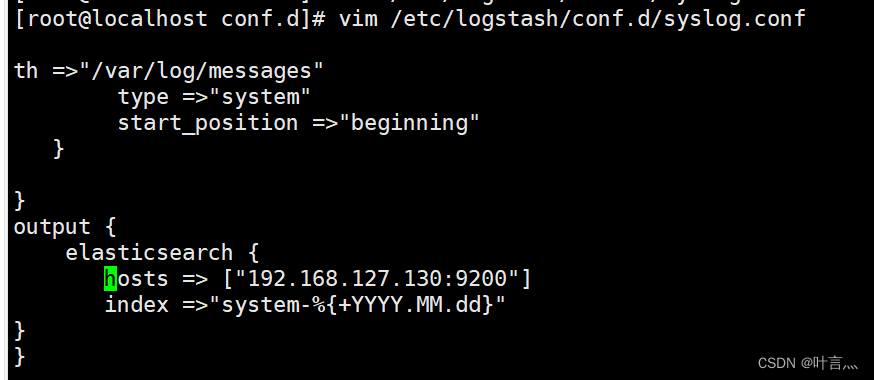

修改 Logstash 配置文件,让其收集系统日志/var/log/messages,并将其输出到 elasticsearch 中

#创建配置文件 vim /etc/logstash/conf.d/syslog.conf

systemctl restart logstash #重启服务

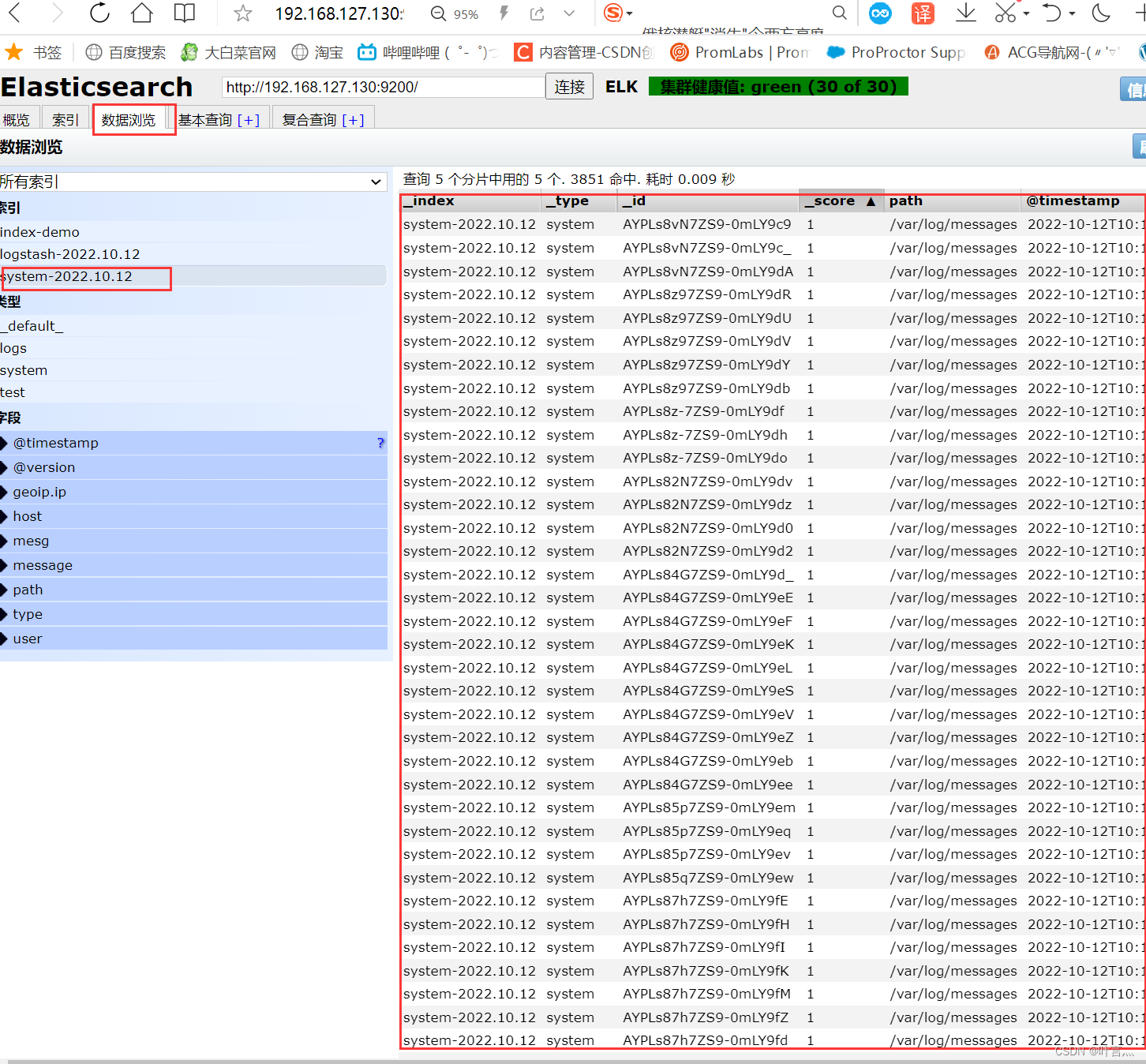

4.6浏览器验证查看索引信息

5、kibana部署(Node1节点)

下载地址:https://www.elastic.co/cn/downloads/past-releases/kibana-5-5-1

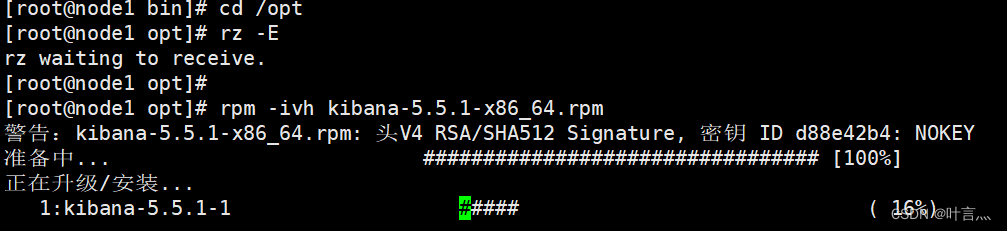

5.1安装Kibana

cd /opt rpm -ivh kibana-5.5.1-x86_64.rpm

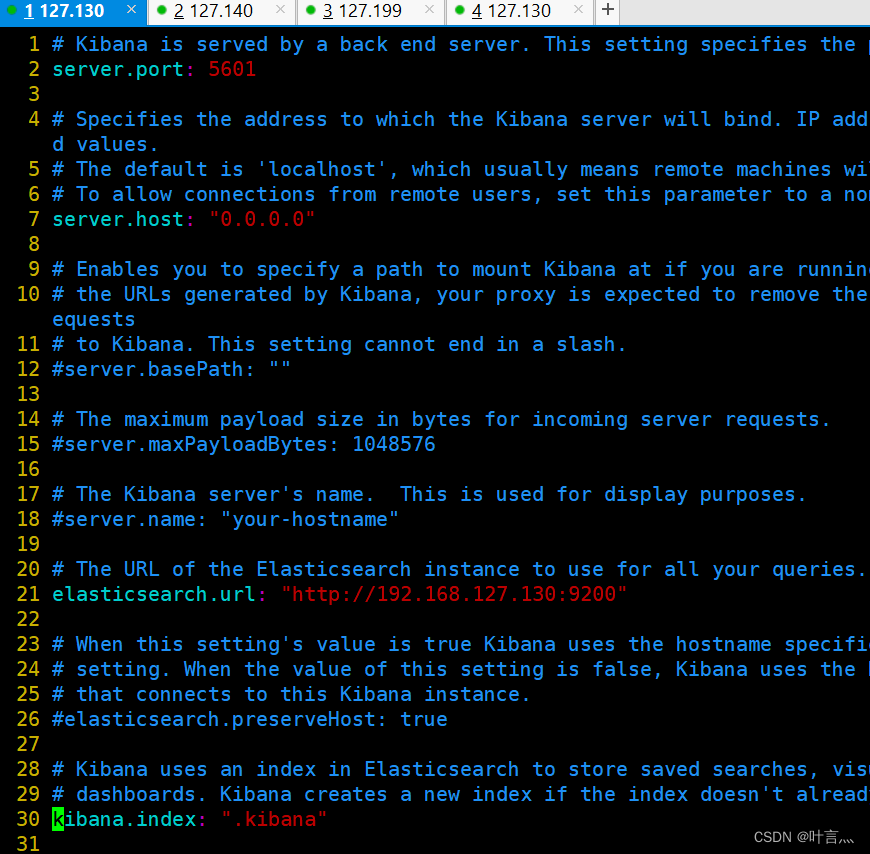

5.2设置Kibana的主配置文件

5.2设置Kibana的主配置文件

vim /etc/kibana/kibana.yml --2--取消注释,Kiabana 服务的默认监听端口为5601 server.port: 5601 --7--取消注释,设置 Kiabana 的监听地址,0.0.0.0代表所有地址 server.host: "0.0.0.0" --21--取消注释,设置和 Elasticsearch 建立连接的地址和端口 elasticsearch.url: "http://192.168.127.130:9200" --30--取消注释,设置在 elasticsearch 中添加.kibana索引

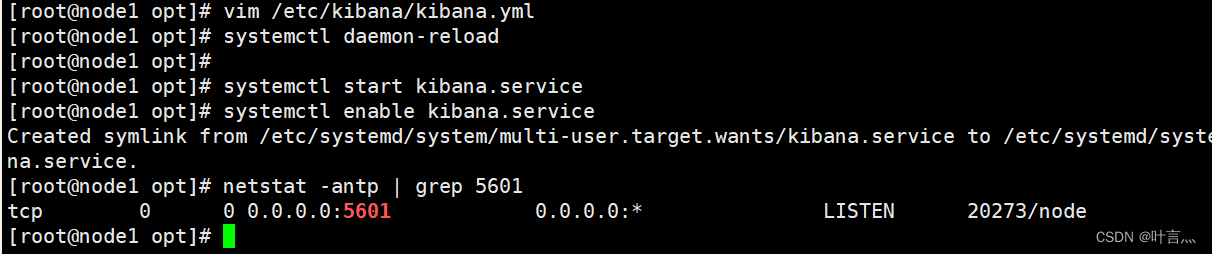

5.3启动kibana服务

5.3启动kibana服务

systemctl daemon-reload systemctl start kibana.service systemctl enable kibana.service netstat -antp | grep 5601

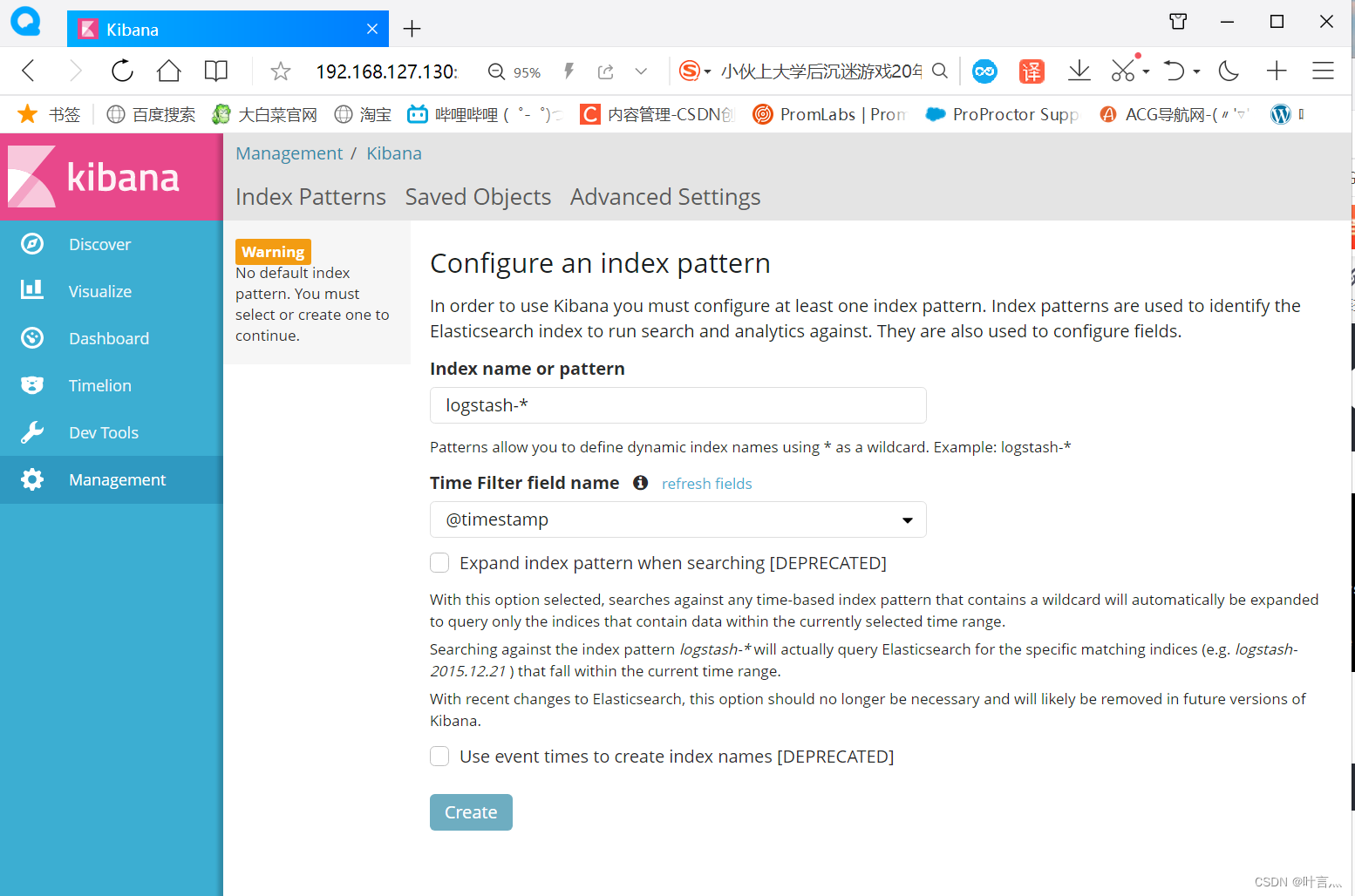

5.4验证Kibana

浏览器访问:http://192.168.127.130:5601

这里切换到发现就会发现有数据

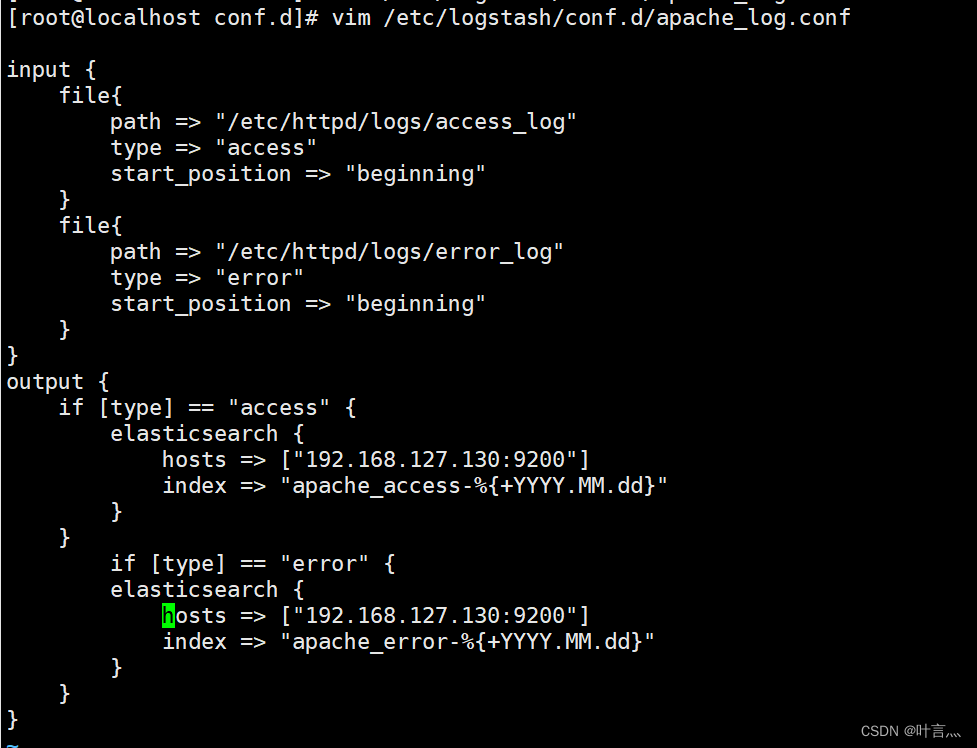

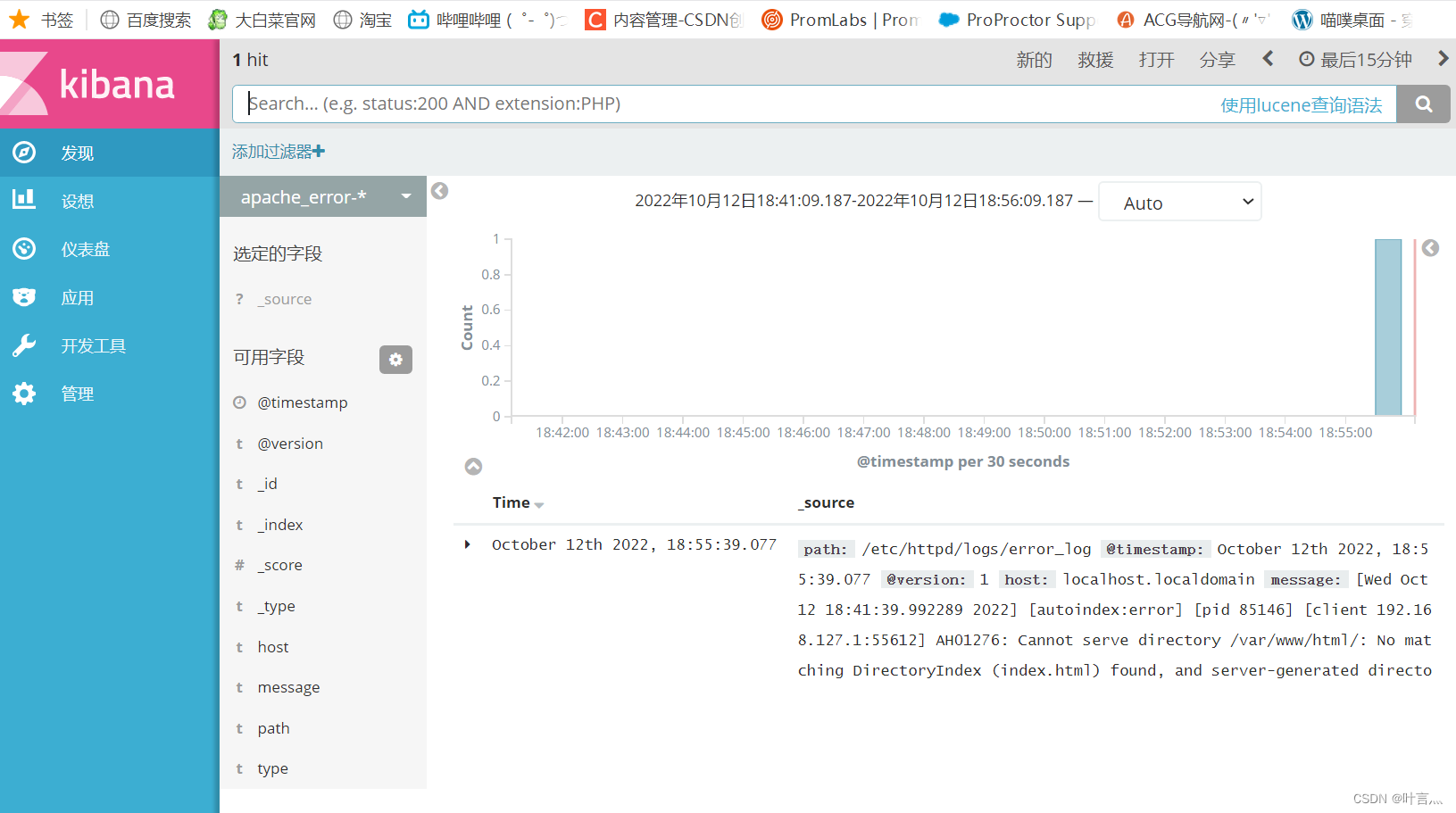

5.5将 Apache 服务器的日志(访问的、错误的)添加到 Elasticsearch 并通过 Kibana 显示

vim /etc/logstash/conf.d/apache_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.127.130:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.127.130:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

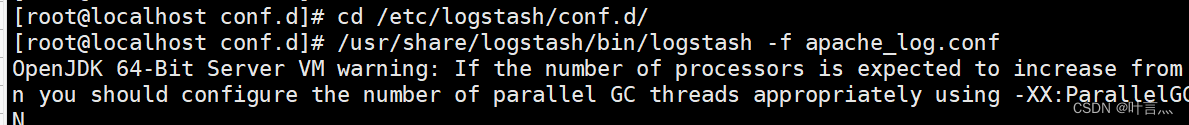

cd /etc/logstash/conf.d/ /usr/share/logstash/bin/logstash -f apache_log.conf

访问apache(192.168.127.199),增加日志

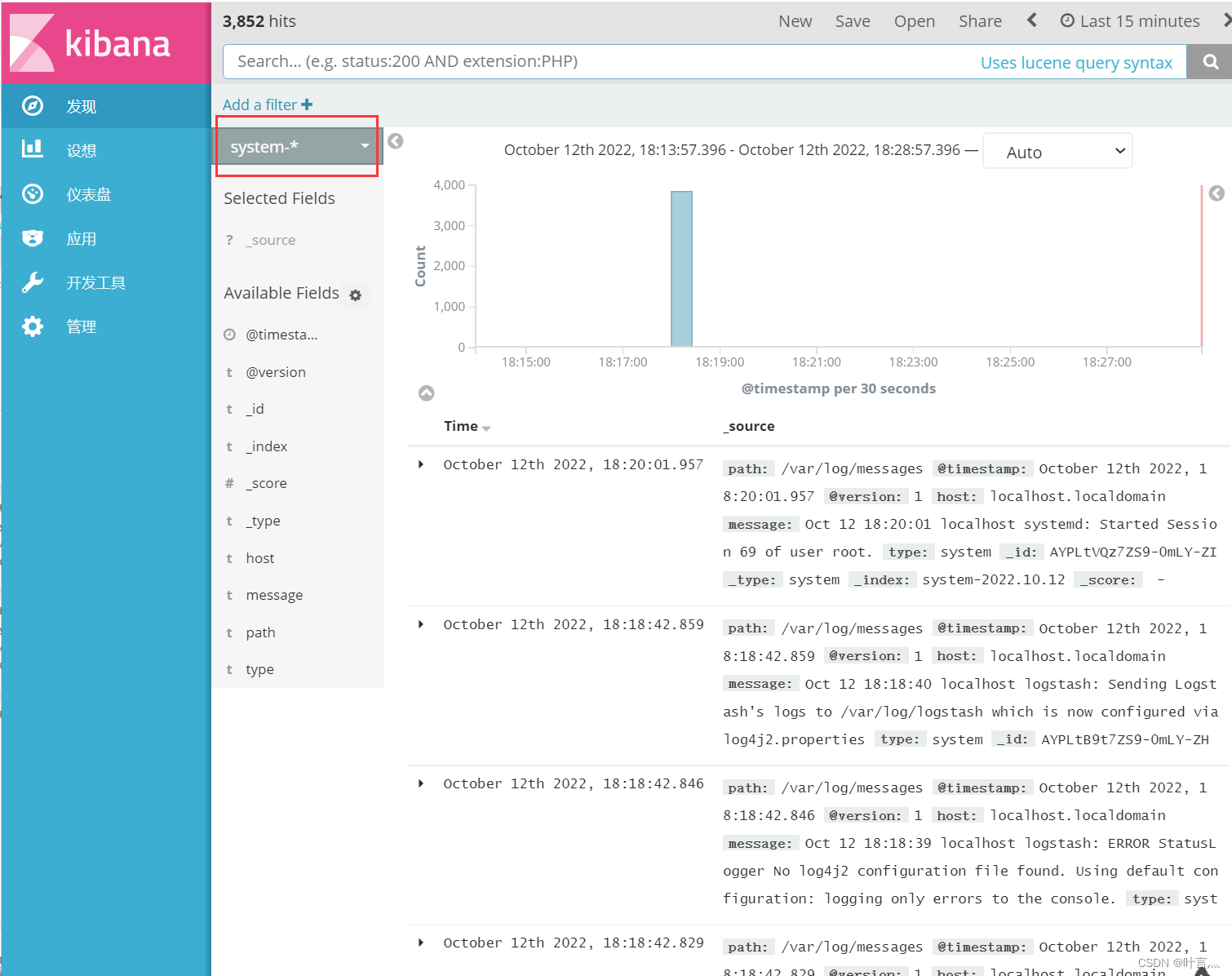

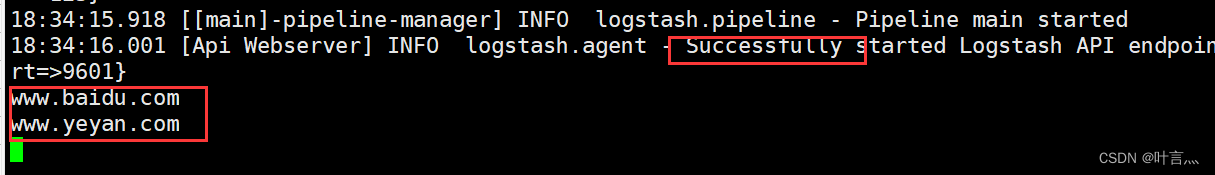

浏览器访问 http://192.168.127.130:9100 查看索引是否创建

成功

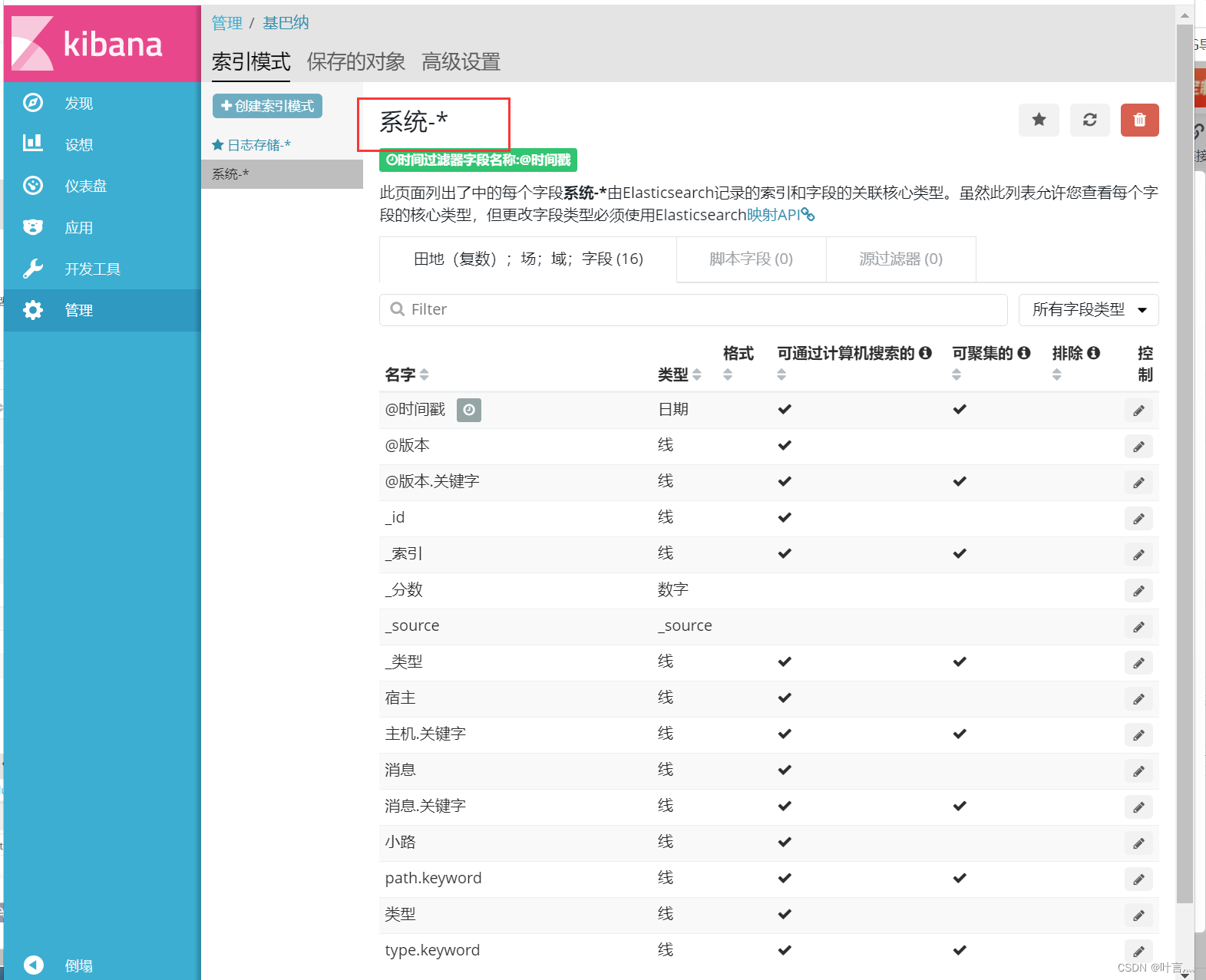

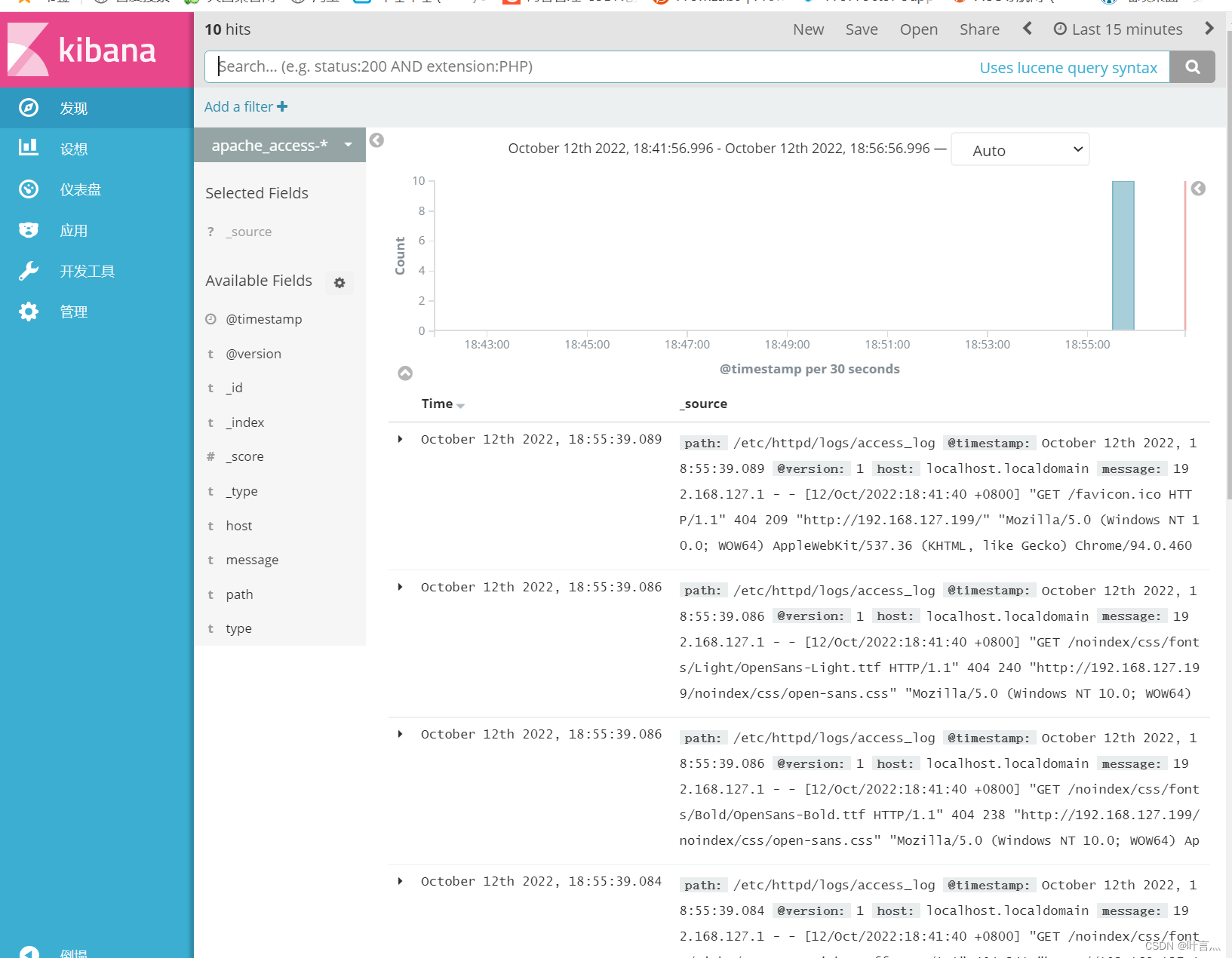

接着去kibana创建访问日志索引

然后在宿主机上刷新访问,会刷新日志,可以在kibana查看时间