CLIP(Contrastive Language-Image Pre-training)是一种机器学习技术,它可以准确理解和分类图像和自然语言文本,这对图像和语言处理具有深远的影响,并且已经被用作流行的扩散模型DALL-E的底层机制。在这篇文章中,我们将介绍如何调整CLIP来辅助视频搜索。

这篇文章将不深入研究CLIP模型的技术细节,而是展示CLIP的另外一个实际应用(除了扩散模型外)。

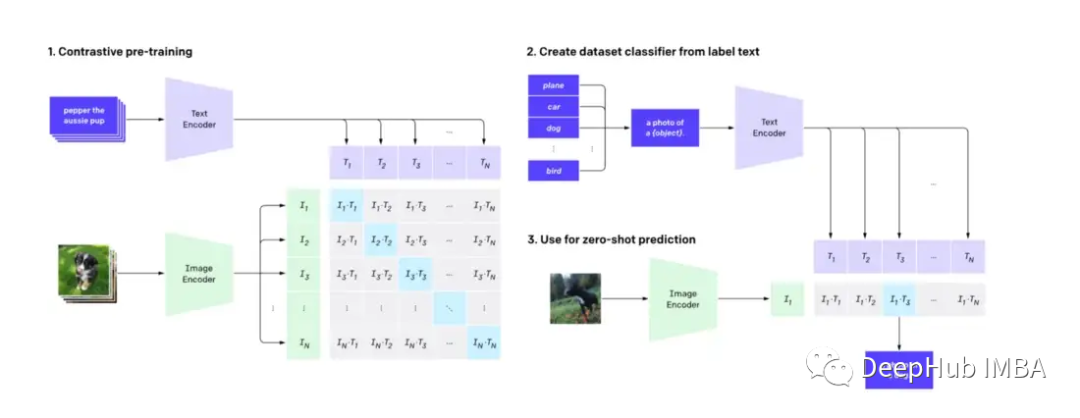

首先我们要知道:CLIP使用图像解码器和文本编码器来预测数据集中哪些图像与哪些文本是匹配的。

https://avoid.overfit.cn/post/a190cdd81cf74c5dadd651a87697d14c

标签:视频,CLIP,模型,搜索引擎,图像,文本 From: https://www.cnblogs.com/deephub/p/17016244.html