序幕

童年经典游戏

童年经典游戏

80、90年代出生的人,红白机总是童年时光重要的记忆片段之一。几叠游戏盒,两个手柄,就可以开启一整天的欢乐时光,乐此不疲地探索各种红白机游戏中的玩法、机制、彩蛋。虽然只是2维平面上的像素头小人,虽然只是“上上下下左右左右BABA”这般的简单按键,但依然被玩家们开发出了各种精彩纷呈的决策行为,时至今日,仍然有很多爱好者在挑战各种诸如“一命通关”,“最速通关”的游戏记录:

而随着时代的发展,游戏类型也变得五花八门,于是玩家们探索的方式也愈加丰富,各类玩家解说攻略视频大大加快了游戏知识的传播速度,还有一系列基于规则的辅助工具将程序和算法引入到游戏探索之中。

最近几年,人工智能技术的发展更是大大提升了算法探索游戏的极限,从2016年 AlphaGo 在围棋领域技惊四座开始,再到后续2019年的 AlphaStar、OpenAI Five,以深度强化学习为核心的决策 AI,在这些复杂度和博弈性最顶尖的游戏中,一次又一次地创造着人工智能的新高峰。

但其实,这些最前沿的决策与智能,离我们并不遥远。比如在很多人的少年时代,玩家们通过个人自身的练习和尝试,朋友间数不清的讨论与琢磨,探索着这些红白机游戏中的种种策略,而在当下,其实我们也可以去学习和运用深度强化学习技术,从另一个视角去打造决策智能,解锁各种有趣有成就感的游戏玩法,还可以跳出游戏的圈子,尝试应用到各种各样的日常决策行为,以及各行各业的优化与设计中去。

想象一下,你不仅可以训练出一个帮你探索游戏玩法的最佳辅助,又可以拥有一个响应你各种日常指令的机器管家,自主导航和操作完成各种任务。

智能体在 habitat-sim 环境中按照指令执行任务

智能体在 habitat-sim 环境中按照指令执行任务

基于相似愿景,上海人工智能实验室 OpenDILab (开源决策智能平台)将会设计推出一系列的决策智能公开课。

首先推出的决策智能入门级公开课 PPO × Family 由中国计算机学会主办,上海人工智能实验室承办,全球高校人工智能学术联盟、北京大学人工智能研究院多智能体中心、浙江大学上海高等研究院、商汤科技协办,知乎、机器之心、智海平台、 Paperweekly 支持。顺利结课的学员还可获得由中国计算机学会颁发的课程学习认证证书。

此课程旨在运用一种最经典的深度强化学习算法 Proximal Policy Optimization (PPO),解决各种各样的决策智能问题,帮助一切对于深度强化学习技术有好奇心的人,轻便且高效地制作应用原型,了解和学习最强大最易用的 PPO × Family。在上完这门课程后,如果有进一步兴趣的话,受众可以将所学知识应用到相关领域中,利用更多的计算资源,去追逐和挑战更强大的人工智能。

首映

PPO 原本是在2017年由 OpenAI 提出的一种深度强化学习算法,而在往后几年中,又有诸多研究者从不同方面给 PPO 添加了许多算法技巧,时至今日,PPO 已成为最受欢迎的算法之一。

OpenDILab 总结了各方面研究者们的相关工作,又结合了开源发布一年来,在40多种决策环境中调优和实践的经验和总结,最终凝练而成了这门 PPO × Family 决策智能入门公开课。

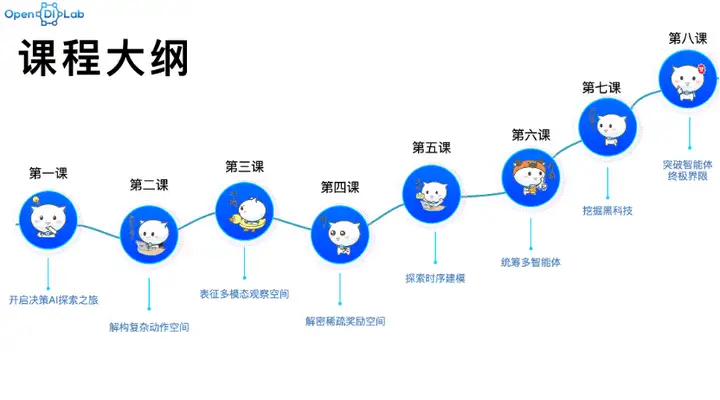

课程大纲

本系列课程将分为8节线上公开课,每节课40-50分钟。相对于强化学习领域已有的优秀公开课,这门课并没有选择自顶向下地讲述强化学习发展演变的各个算法分支,而是自底向上地,从实际应用深度强化学习的角度出发,讲述把算法理论应用到实际决策问题时常用的种种分析方法和优化技巧,通过这门课让受众盘清算法理论,理顺代码逻辑,玩转决策AI应用实践。

其中,第1节课将会通过多重对比来讲解决策 AI 问题定义和研究的特殊之处;第2-7节课将会分别以子领域专题的形式,扩充 PPO × Family 的相关成员;最后一节课,将会综合运用之前累积的各方面知识,去设计和搭建一个“终极”智能体。

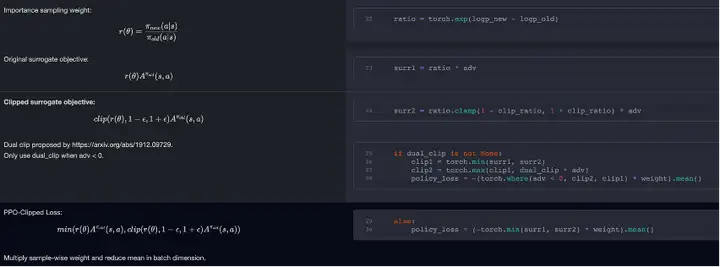

更重要的是,每节课程都会保持“算法理论-代码实现-应用实践”三合一的讲解模式,真正做到知其然(代码)又知其所以然(算法),并学以致用(应用)。

算法理论公式和代码实现的一一对应讲解

在 PPO × Family 八节课的过程中,受众会接触到各种各样的决策智能应用,最终结课时,就相当于完成了自动驾驶、量化交易、机器人控制、游戏 AI 等多个领域相关决策任务的入门实践,从而真正做到集中一点,演化出无限可能。

此外,OpenDILab 也特地优化了每节课的实践任务的计算开销,整个 PPO × Family 系列课程并不需要大量计算资源,一定配置的个人电脑完全可以应对各种挑战(当然课程官方也会提供一些免费的计算资源用于备用)。

在上完这门课程后,如果有进一步兴趣的话,受众可以将所学知识应用到相关领域中,利用更多的计算资源,去追逐和挑战更强大的人工智能。而且,这门课程也会在每节课布置一些算法理论分析的小作业,如果能够坚持完成并参与讨论,可以获得由中国计算机学会颁发的课程学习认证证书。

课程预告

目前,OpenDILab 已经建立了 课程 GitHub 相关仓库,每一节课程的课件、文字讲稿,代码,答疑等教学素材都会全部公开在这个仓库中。而每节课的课程录像,将会在B站(账号:OpenDILab)、公众号平台(账号:OpenDILab决策AI)、知乎平台(账号:OpenDILab浦策)同步发布,欢迎保持关注。

PPO × Family 课程 GitHub链接:

https://github.com/opendilab/PPOxFamily

另外,由于剪辑和制作需要,同时响应受众的需求不断优化课程内容,我们将会以每1-2周一节课的速度逐渐更新课程内容,也欢迎大家积极参与贡献,希望能够真正将知识传达给有需要的人,共建知识共享的开源社区。

课程第一讲(开启决策 AI 探索之旅)将会在 2022年12月8日正式上线。

感兴趣的朋友可添加课程小助手微信(课程小助手微信:OpenDILab),备注「课程」,欢迎大家与我们交流。

References:

[1]https://github.com/Kautenja/nes-py

[2] https://www.bilibili.com/video/BV14d4y1N7KH/?spm_id_from=333.999.0.0

[3] https://github.com/facebookresearch/habitat-sim

标签:游戏,Family,AI,PPO,决策,算法,课程 From: https://www.cnblogs.com/OpenDILab/p/16941484.html