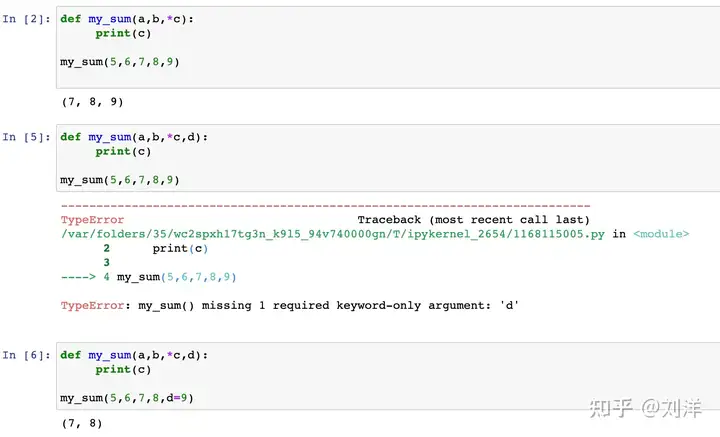

变量前单星号表示将参数转化成元组

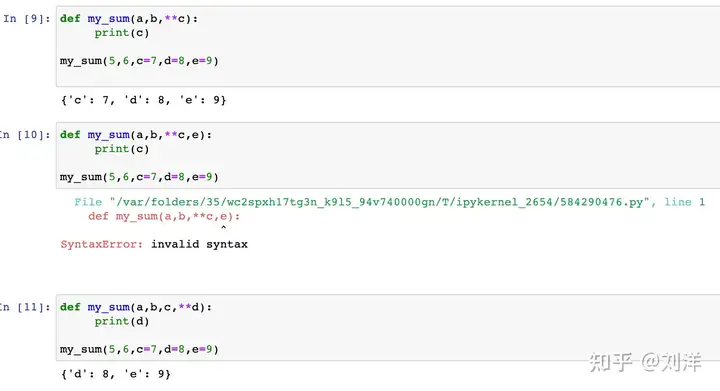

变量前双星号表示将参数转化成字典

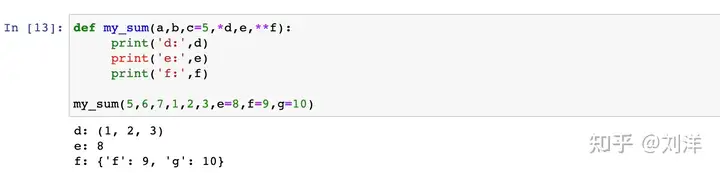

函数传参顺序

从左到右(一般):位置参数、默认参数、单星号参数、关键字传参、双星号参数

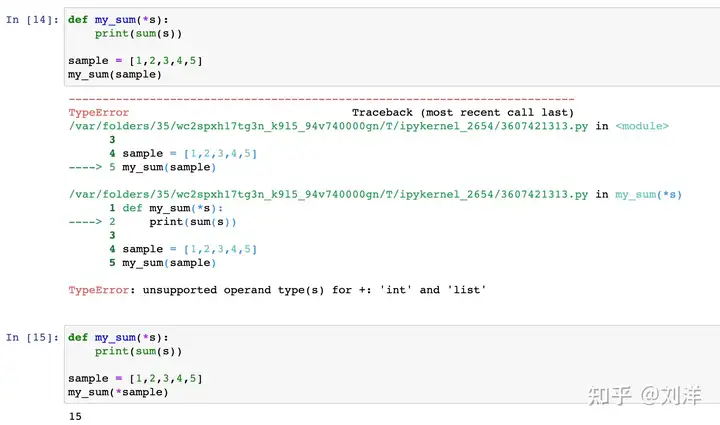

传参解压功能

单星号对list或元组进行解压,输入的参数不是一个list或元组,而是其中的元素。

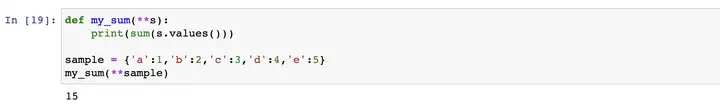

双星号对字典进行解压,输入的参数变成 " a=1, b=2, c=3, d=4, e=5 "。

标签:传参,解压,变量,python,元组,星号,参数 From: https://www.cnblogs.com/sangern/p/17472601.html